上一篇

分布式存储软件架构

- 行业动态

- 2025-05-13

- 10

分布式存储软件架构基于分层设计,通过数据分片、冗余备份、一致性协议及负载均衡实现高可用与扩展性

分布式存储软件架构详解

分布式存储是一种通过多台服务器协同工作来存储和管理数据的架构,其核心目标是实现数据的高可用性、可扩展性和可靠性,以下是分布式存储软件架构的核心组成部分、设计原则及关键技术解析。

架构模式分类

分布式存储的架构模式主要分为以下三类:

| 架构模式 | 特点 | 适用场景 |

|---|---|---|

| 集中式索引 | 元数据由单一节点管理,数据分片存储在多个节点 | 小规模集群,对元数据性能要求高 |

| 主从式复制 | 主节点负责写入和同步,从节点提供读服务 | 读写分离场景,如日志存储 |

| 对等式无中心 | 所有节点地位平等,数据通过算法自动分布 | 大规模集群,高可用要求 |

典型代表:

- 集中式索引:传统NAS(网络附加存储)

- 主从式复制:Redis Cluster、Elasticsearch

- 对等式无中心:Ceph、GlusterFS

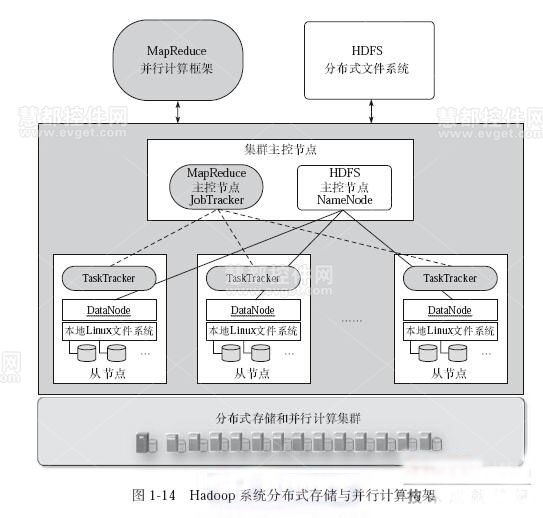

核心组件与功能

分布式存储系统通常包含以下关键模块:

| 组件 | 功能描述 |

|---|---|

| 客户端(Client) | 发起数据读写请求,负责数据分片、路由和负载均衡 |

| 元数据服务(MDS) | 管理文件/对象的元信息(如目录结构、权限、数据块位置),支持命名空间服务 |

| 存储节点(OSD) | 实际存储数据块,负责数据持久化、复制和恢复 |

| 监控模块 | 实时监控系统状态(如磁盘健康、网络延迟、负载),触发故障切换和扩容策略 |

以Ceph为例:

- 客户端通过CRUSH算法直接与OSD交互,无需中心元数据服务器。

- Monitor组件维护集群状态地图,确保数据一致性。

数据分布与冗余策略

数据分片(Sharding)

- 哈希分片:按数据键值取模分配到不同节点(简单但易导致负载不均)。

- 一致性哈希(Consistent Hashing):缓解节点增减导致的数据迁移问题,例如Ceph的CRUSH算法。

数据冗余与容错

- 副本策略(Replication):每份数据存储多份副本(如HDFS默认3副本),适用于读密集型场景。

- 纠删码(Erasure Coding):将数据编码为多个块和校验块,节省存储空间(如Ceph的EC Pool)。

| 策略 | 空间开销 | 容错能力 | 适用场景 |

|---|---|---|---|

| 副本(3副本) | 300% | 允许任意2节点故障 | 高可用读、低延迟要求 |

| 纠删码(6+3) | 150% | 允许任意3节点故障 | 大容量存储、低成本优先 |

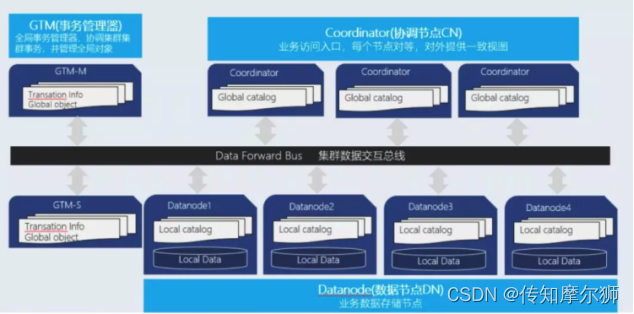

一致性模型与协议

CAP定理权衡

- 强一致性(CP):保证数据一致但牺牲可用性(如ZooKeeper)。

- 最终一致性(AP):允许短暂不一致以提升可用性(如DynamoDB)。

一致性协议

- Paxos/Raft:用于元数据服务的强一致性选举(如Etcd)。

- Quorum NWR:通过读写多数派实现最终一致性(如Cassandra)。

容错与恢复机制

故障检测

- 心跳机制:节点定期发送心跳包,超时则标记为故障(如HDFS的DataNode心跳)。

- 数据校验:通过哈希值或校验码检测数据完整性(如RAID的奇偶校验)。

数据恢复

- 自动重平衡:节点故障时,系统自动将数据迁移至健康节点。

- 冷热分层:根据访问频率将数据分层存储(如SSD+HDD组合)。

性能优化技术

| 优化方向 | 技术手段 |

|---|---|

| 缓存加速 | 客户端本地缓存、LRU缓存策略(如MinIO的内存缓存) |

| 负载均衡 | 动态权重分配、一致性哈希虚拟节点(如Ribbon负载均衡算法) |

| 数据压缩 | Zlib、Snappy等算法减少传输和存储开销(如Ceph的RBD块压缩) |

| 并行处理 | 多线程并发读写、流水线处理(如Spark与分布式存储的集成) |

FAQs

Q1:分布式存储与集中式存储的核心区别是什么?

A1:集中式存储依赖单一节点(如NAS/SAN),存在性能瓶颈和单点故障风险;分布式存储通过多节点协同,实现容量和性能的线性扩展,并通过冗余机制提高可靠性。

Q2:如何选择数据分布策略(哈希 vs. 一致性哈希)?

A2:若节点数量固定且规模较小,哈希分片足够;若需动态扩缩容或节点频繁变动,一致性哈希能减少数据迁移量(如从100