上一篇

分布式存储软件文档介绍内容

- 行业动态

- 2025-05-13

- 8

分布式存储软件文档详述系统架构、核心功能及部署方案,涵盖数据冗余、负载均衡等关键技术,提供集群管理、运维监控实操指南,附API接口说明与云存储、大数据等场景应用示例,助力

分布式存储软件技术解析与实践指南

分布式存储基础概念

分布式存储系统通过将数据分散存储在多个物理节点上,结合网络通信和数据管理算法,实现数据的高可用性、可扩展性和容错能力,与传统集中式存储相比,其核心优势体现在:

- 容量扩展:支持EB级数据存储,突破单节点硬件限制

- 性能提升:并行化数据访问,吞吐量可达传统存储的数十倍

- 可靠性保障:数据冗余机制使可用性达到99.999%以上

- 成本优化:利用普通PC服务器构建存储集群,降低硬件投入

核心架构设计要素

| 组件类型 | 功能描述 |

|---|---|

| 存储节点 | 实际存储数据的物理设备,包含本地存储介质(HDD/SSD) |

| 元数据服务 | 管理文件目录结构、块位置映射等元信息,典型实现如Ceph的MON、GlusterFS的Volumis |

| 客户端接口 | 提供标准协议接入(如S3、POSIX、NFS),实现数据分片和流量调度 |

| 协调服务 | 负责集群状态管理、故障检测和恢复,常见方案包括ZooKeeper、Etcd等 |

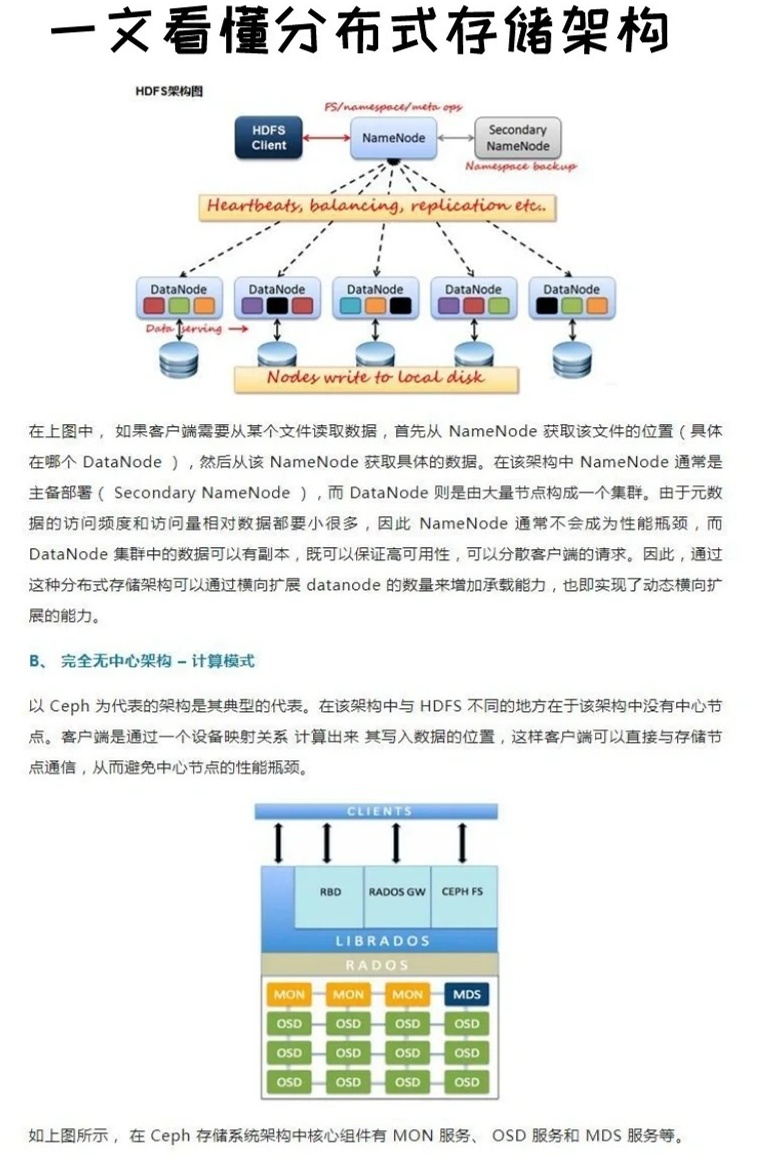

典型架构采用无中心化设计,通过一致性哈希算法实现数据均匀分布,以Ceph为例,其CRUSH算法可动态调整数据分布策略,支持机房级故障隔离。

关键特性实现机制

数据冗余策略

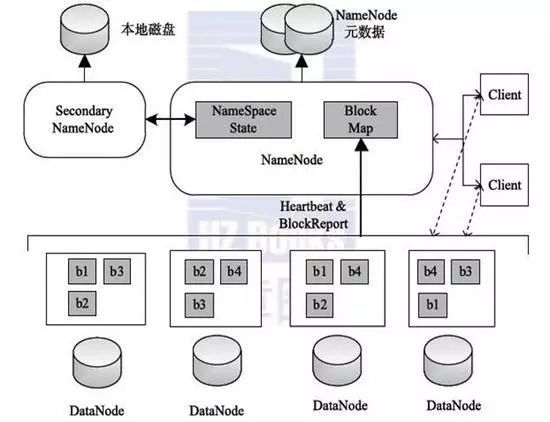

- 副本机制:每个数据块保存3个副本(如HDFS默认配置)

- 纠删码技术:将数据编码为k+m块,可容忍m/k比例的节点故障(如Reed-Solomon编码)

- 混合模式:热数据用副本,冷数据用纠删码(Ceph CRUSH Map支持)

故障自愈流程

graph TD A[节点故障检测] --> B{心跳超时} B -->|是| C[触发数据重建] C --> D[计算缺失数据块] D --> E[选取健康节点生成新副本] E --> F[校验数据一致性] F --> G[恢复完成]性能优化方案

- 数据分层:LRU算法自动迁移冷热数据

- 读写分离:日志型写入优化(如Cassandra的Memtable设计)

- 网络优化:RDMA技术降低延迟(BeeGFS支持)

主流技术对比分析

| 特性维度 | Ceph | MinIO | GlusterFS |

|---|---|---|---|

| 协议支持 | S3/RBD/POSIX | S3/GCS API | NFS/SMB/POSIX |

| 扩展方式 | 线性扩展 | 横向扩展 | ASM自动均衡 |

| 数据保护 | CRUSH Map+EC | 4:1纠删码 | AFR/AFRP |

| 适用场景 | 云原生/块存储 | 对象存储 | NAS替代 |

| 学习曲线 | 高(复杂配置) | 低(Docker部署) | 中(依赖存储逻辑) |

企业级应用实践

云计算基础设施

- OpenStack集成:Cinder组件对接块存储,Swift对接对象存储

- 多租户隔离:Ceph Cephx认证体系实现权限控制

- 计费系统:基于Prometheus监控存储资源消耗

大数据分析平台

- Hadoop集成:HDFS-HA模式与Ceph RBD对接

- Spark优化:利用Prefetch机制预加载热点数据

- 数据湖架构:支持Delta Lake事务处理

灾备方案设计

- 跨地域复制:Rsync+IPSEC实现异步复制

- 版本控制:快照技术保留历史数据版本

- 演练验证:Chaos Engineering工具模拟故障场景

部署实施要点

硬件选型建议

- 节点配置:CPU至少8核,内存32GB+,磁盘RAID组(SAS HDD+NVMe缓存)

- 网络要求:万兆以太网或InfiniBand,MTU≥1500

- 机架规划:每机架部署6-8台节点,预留20%扩展空间

软件安装流程

# Ceph集群部署示例 ceph-deploy new <monitor_host> # 初始化MON节点 ceph-deploy osd --data <disk> <osd_host> # 添加OSD节点 ceph osd pool create mypool 128 128 replicated # 创建存储池

性能调优参数

| 参数项 | 推荐值 | 作用说明 |

|———————-|———————–|—————————|

|osd_recovery_op_priority| 5 | 恢复任务优先级 |

|filestore_xattr_use_omap| true | 元数据存储优化 |

|bluestore_cache_size| 4G | RocksDB缓存配置 |

技术演进趋势

- 智能存储:AI驱动的数据分类和生命周期管理

- 混合云存储:跨私有云/公有云的统一命名空间

- 存算一体化:近数据处理减少网络传输延迟

- 绿色存储:MAID技术降低待机功耗

FAQs常见问题解答

Q1:如何选择合适的分布式存储软件?

A:需评估三个维度:①业务类型(数据库/日志/视频等)②性能需求(IOPS/吞吐量)③运维能力。

- 云原生应用优先MinIO(兼容S3)

- 虚拟化环境推荐Ceph(支持RBD)

- 文件共享场景适用GlusterFS(NAS协议)

Q2:遇到存储节点离线如何处理?

A:应急处理步骤:

- 立即执行

ceph osd tree查看集群状态 - 标记故障节点:

ceph osd out <osd.id> - 触发数据恢复:

ceph osd reweight-by-utilization - 排查硬件故障(检查/var/log/ceph/osd.

.log) - 节点修复后执行`ceph osd in