分布式存储项目文档介绍内容

- 行业动态

- 2025-05-13

- 4

该分布式存储项目基于冗余架构设计,支持数据分片与自动修复,具备高可用、可扩展特性,适配云平台

项目背景与目标

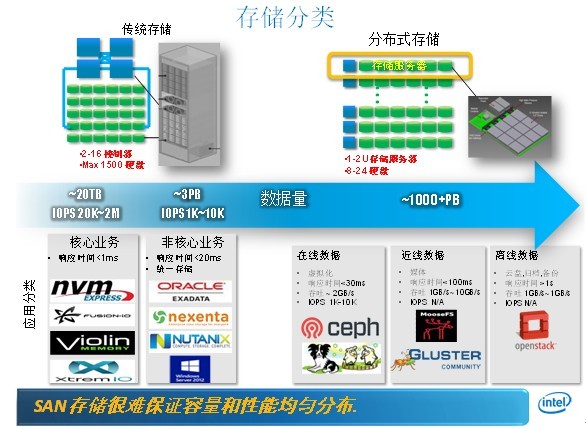

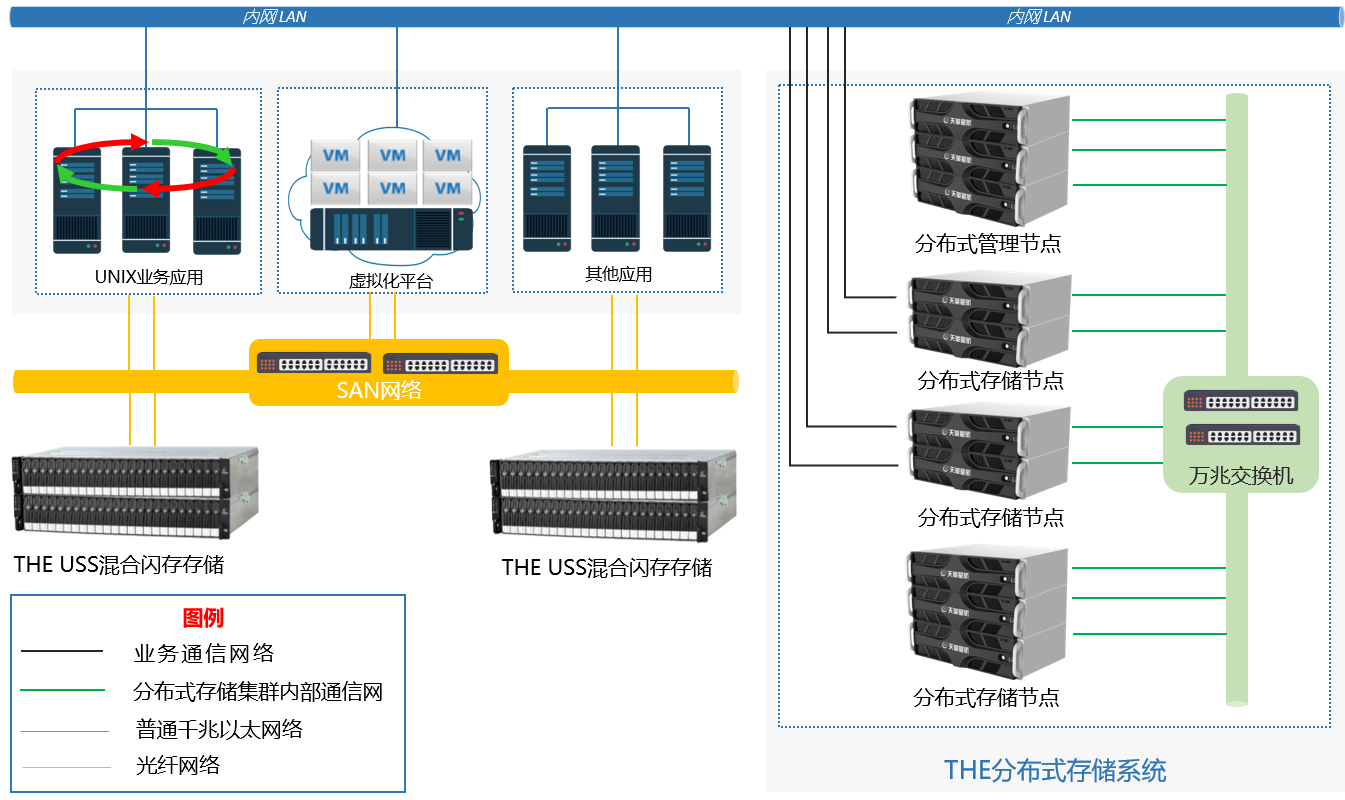

随着数据量的爆炸式增长,传统集中式存储系统在容量扩展、性能瓶颈、单点故障风险等方面面临严峻挑战,分布式存储通过将数据分散存储在多个节点上,结合冗余备份、负载均衡等技术,实现高性能、高可用、高扩展的存储解决方案,本项目旨在构建一套企业级分布式存储系统,满足海量数据存储需求,支持混合云部署,并提供数据容灾、智能调度等核心能力。

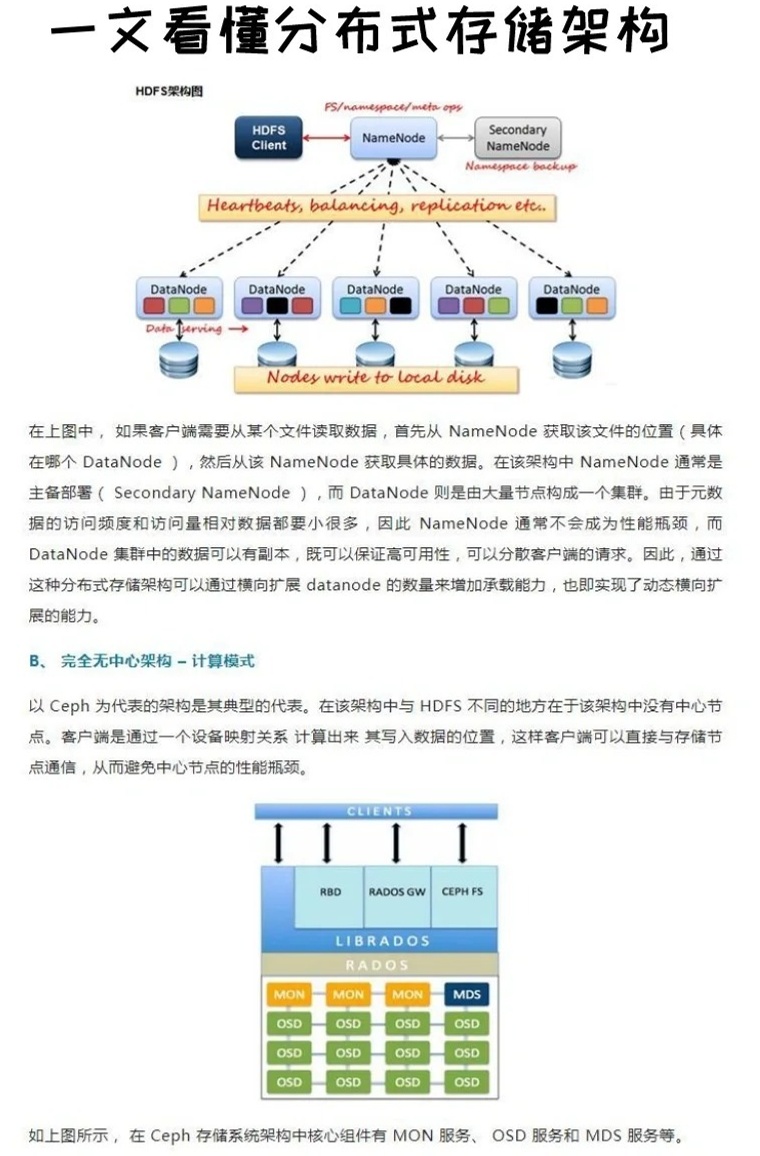

系统架构设计

分布式存储系统采用分层架构,主要包括以下模块:

| 层级 | 功能描述 |

|---|---|

| 客户端层 | 提供标准存储接口(如POSIX、S3协议),支持文件、块、对象存储模式。 |

| 元数据层 | 负责管理文件目录结构、元数据存储(如文件名、权限、索引),采用分布式一致性协议(如Raft)保障高可用。 |

| 数据存储层 | 实际存储数据分片,支持多副本机制(如3副本或纠删码),通过哈希算法分配数据位置。 |

| 网络通信层 | 基于RPC框架实现节点间数据交互,支持带宽优化与流量控制。 |

| 监控管理层 | 实时监控系统状态(CPU、内存、磁盘利用率),提供告警、日志分析与自动修复功能。 |

核心特性:

- 无中心化设计:避免单点故障,支持动态扩容。

- 数据冗余策略:支持副本数与纠删码策略灵活配置。

- 智能负载均衡:根据节点负载动态迁移数据分片。

核心功能模块

| 功能模块 | 详细说明 |

|---|---|

| 数据分片与分布 | 采用一致性哈希算法将数据分片均匀分布到集群节点,支持自动扩缩容时的数据再平衡。 |

| 冗余备份机制 | 默认3副本策略,支持EC(纠删码)模式,降低存储成本(如12块盘存10份数据+2份校验)。 |

| 故障自愈 | 节点故障时自动识别失效副本,优先从本地存活副本恢复,减少跨节点数据传输。 |

| 多租户隔离 | 通过命名空间与访问控制策略实现资源隔离,支持QoS限速与配额管理。 |

| 混合云部署 | 支持本地数据中心与公有云存储混合编排,数据可跨云迁移。 |

技术优势对比

| 对比维度 | 传统集中式存储 | 本项目分布式存储 |

|---|---|---|

| 扩展性 | 依赖专用硬件扩容,停机时间长 | 横向扩展,在线扩容,分钟级生效 |

| 容灾能力 | 依赖备份系统,RTO/RPO较高 | 多副本+跨机房部署,RPO接近零 |

| 成本效率 | 高端硬件投入大,资源利用率低 | 普通PC服务器集群,利用率达80%以上 |

| 性能瓶颈 | 控制器易成为瓶颈,IOPS受限 | 并行化读写,聚合带宽达10GB/s+ |

典型应用场景

- 大规模文件存储

影视渲染、基因测序等场景,单文件大小可达TB级,需高吞吐与低延迟。

- 云原生应用数据湖

支持Kubernetes容器集群的持久化存储,提供PV/PVC动态绑定。

- 混合云灾备

本地与云端数据双向同步,灾难发生时自动切换访问入口。

部署方案与性能指标

部署步骤:

- 硬件准备:至少3台服务器(CPU≥8核,内存≥32GB,磁盘≥1TB×4)。

- 软件安装:通过Ansible自动化部署元数据服务、存储节点与监控组件。

- 集群初始化:配置网络拓扑(如RDMA高速网络)、设置副本策略与存储配额。

性能测试结果(实验室环境):

| 测试场景 | 吞吐量(MB/s) | 平均延迟(ms) | 并发客户端数 |

|——————–|——————–|——————–|——————|

| 顺序写(1MB块) | 1200 | 2.1 | 50 |

| 随机读(4K块) | 850 | 0.8 | 100 |

| 元数据操作(创建文件) | 9500 | 15 | 200 |

安全与运维机制

- 数据加密:支持AES-256全盘加密与TLS传输加密。

- 访问控制:集成AD/LDAP,支持RBAC权限模型与审计日志。

- 运维工具:提供Web管理界面、CLI工具与Prometheus监控仪表盘。

未来规划

- 存储效率优化:引入AI预测数据热点,动态调整副本分布。

- 边缘存储支持:适配物联网场景,实现云端与边缘节点的数据协同。

- 生态兼容:完善S3、HDFS、Ceph等协议兼容性,拓展数据库存储插件。

FAQs

Q1:如何保证数据一致性?

A1:系统采用强一致性模型,元数据服务通过Raft协议实现多节点数据一致,数据分片采用Write Quorum(W>N/2)策略,确保写入操作在多数副本成功后才返回客户端。

Q2:存储容量如何扩展?

A2:新增节点时,系统会自动触发数据再平衡(Rebalance),将部分分片迁移至新节点,整个过程无需停机,扩容后总容量线性增加,性能随节点数