分布式存储软件部署

- 行业动态

- 2025-05-13

- 8

分布式存储软件部署详解

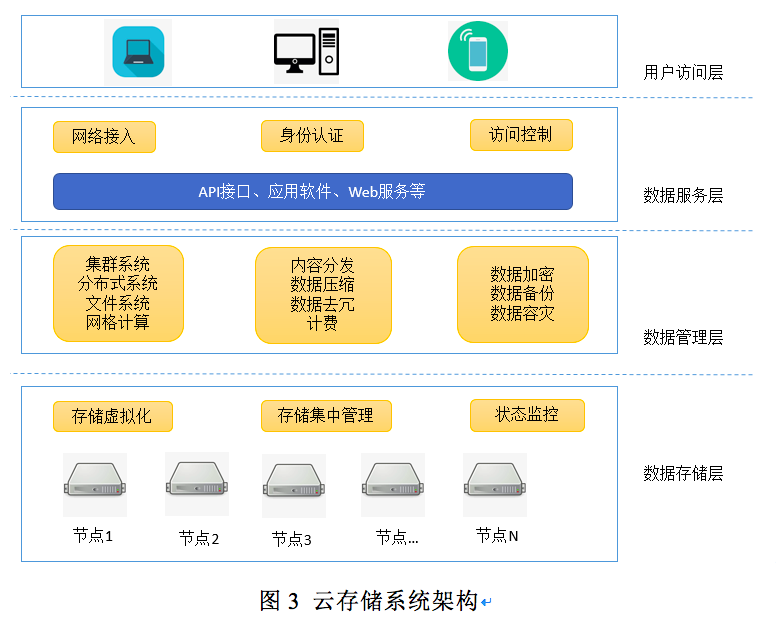

分布式存储系统通过将数据分散存储在多个节点上,实现数据的高可用性、可扩展性和容错能力,本文将从架构设计、部署流程、配置优化到监控维护,全面解析分布式存储软件的部署要点,并提供常见问题解答。

分布式存储架构核心组件

| 组件类型 | 功能描述 | 典型技术实现示例 |

|---|---|---|

| 存储节点 | 负责实际数据存储,支持水平扩展 | Ceph OSD、MinIO Pod |

| 元数据服务 | 管理文件/对象元数据,协调数据分布与访问 | Ceph MON、MinIO Gateway |

| 客户端接口 | 提供标准协议(如S3、POSIX、NFS)供上层应用访问 | MinIO S3 API、Ceph RGW |

| 数据冗余机制 | 通过副本或纠删码保障数据可靠性 | Erasure Code、Replication |

| 监控模块 | 实时采集系统运行状态,触发告警与自愈 | Prometheus + Grafana |

部署前准备与规划

硬件资源评估

- 节点规格:根据数据量与访问频率选择CPU/内存/磁盘配置,建议SSD+HDD混合存储

- 网络拓扑:万兆网卡+低延迟交换机,建议采用RDMA技术提升传输效率

- 冗余设计:至少部署3个AZ(可用区),单机房故障不影响服务

软件选型对比

| 特性维度 | Ceph | MinIO | Elasticsearch FS |

|—————|—————|—————|—————-|

| 存储协议 | RADOS/S3/SWIFT| S3 API | HTTP REST |

| 数据冗余方式 | CRUSH算法/EC | Erasure Code | Sharding |

| 扩展性 | 千节点规模 | 百节点规模 | 中等 |

| 学习成本 | 高(复杂配置) | 低(Docker化)| 中 |网络规划

- 心跳网络:独立VLAN保障元数据同步(建议MTU≥1500)

- 存储网络:RDMA或RoCE协议优化延迟,启用Jumbo Frame(MTU 9000)

- 客户端网络:公网/内网分离,配置WAF防火墙

部署实施步骤

基础环境搭建

# 以Ceph为例的初始化操作 ceph-deploy new <monitor-node> # 部署监控节点 ceph-deploy osd create --data <disk> <osd-node> # 创建存储节点 ceph-deploy mgr create <node> # 部署管理节点

集群配置关键参数

| 参数类别 | 配置建议 |

|—————-|————————————————————————–|

| 数据分布 | CRUSH map权重分配(根据硬盘IOPS/带宽动态调整) |

| 冗余策略 | 副本数≥3(EC模式需6+3配置) |

| 恢复策略 | 后台scrub频率设为每日,修复优先级调高 |

| 客户端限速 | 设置osd_client_message_cap防止单节点过载 |

安全加固措施

- 认证机制:启用Ceph x509证书认证或MinIO IAM策略

- 网络隔离:存储流量与管理流量分离,配置IP白名单

- 审计日志:开启操作审计并保留≥180天

性能优化与运维要点

存储桶策略优化

- 冷热数据分层:使用生命周期规则将30天未访问数据转存至Glacier类存储

- 分片大小调整:根据对象平均大小设置分片(建议128KB~64MB)

监控指标阈值

| 指标名称 | 危险阈值 | 说明 |

|——————|————————-|————————————–|

| OSD延迟 | >50ms | 磁盘IO瓶颈预警 |

| PG不平衡度 | >0.05 | 数据分布不均需修复 |

| 网络包丢失率 | >0.1% | 检查物理链路或交换机配置 |故障处理流程

- 节点宕机:自动触发CRUSH重平衡,手动检查硬盘SMART状态

- 脑裂问题:启用仲裁机制(如Ceph Mon quorum)+ 心跳超时设置

- 数据不一致:执行

ceph osd deep-scrub或minio heal命令

典型场景部署方案

| 应用场景 | 推荐架构 |

|---|---|

| 海量小文件 | MinIO + GPU加速元数据处理,配置预取缓存 |

| 大数据分析 | Ceph + HDFS兼容模式,集成Spark/Presto直接访问 |

| 混合云灾备 | 双活数据中心部署,采用Rsync+增量快照实现跨云同步 |

| AI训练存储 | NVMe over Fabrics + 并行文件系统,配置显存直通存储池 |

FAQs

Q1:Ceph与MinIO如何选择?

A1:Ceph适合需要复杂企业级功能(如块存储、文件系统)的场景,但运维复杂度高;MinIO更适合云原生对象存储需求,开箱即用且兼容S3协议,若现有K8s环境建议优先MinIO,传统IDC环境可考虑Ceph。

Q2:部署后出现读写延迟过高怎么办?

A2:按以下顺序排查:

- 检查OSD磁盘IOWait是否>30%(

iostat命令) - 查看网络P99延迟是否>10ms(

iperf3测试) - 分析PG数量是否过载(Ceph

ceph pg ls) - 检查客户端