hdfs小文件存储

- 行业动态

- 2025-05-12

- 1

HDFS小文件存储问题解析与优化方案

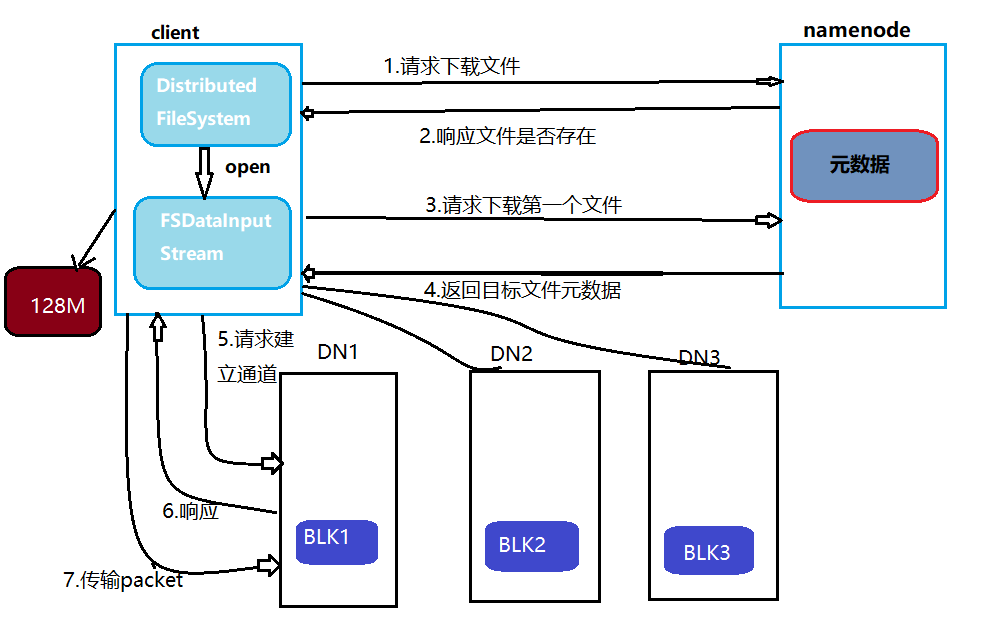

在Hadoop分布式文件系统(HDFS)中,小文件存储一直是影响集群性能和资源利用率的关键问题,当大量小于HDFS块大小(默认128MB)的小型文件直接存储时,会引发元数据膨胀、数据节点存储效率低下、NameNode内存压力剧增等一系列连锁反应,本文将系统分析小文件存储的痛点,并提出多维度的优化解决方案。

小文件存储问题的本质特征

HDFS采用”一次写入,多次读取”的设计模式,其核心存储单元为固定大小的Block(默认128MB),当文件尺寸远小于Block大小时,会产生以下典型特征:

| 特征维度 | 具体表现 |

|---|---|

| 元数据开销 | 每个文件独立占用NameNode内存,100万小文件需约3.6GB内存(按默认配置估算) |

| 存储效率 | 单个Block存储多个小文件时产生内部碎片,实际有效数据占比不足1% |

| 网络传输成本 | MapReduce任务处理时,每个小文件都需要独立的读取操作,增加寻址时间 |

| 数据节点负载 | 海量小文件导致DataNode磁盘索引膨胀,目录遍历耗时显著增加 |

小文件引发的性能瓶颈

NameNode元数据压力

每个文件对应一个FsImage元数据条目,包含文件名、权限、Block位置等信息,当文件数量达到百万级时:- 内存占用:默认配置下单个NameNode可支持约9千万个小文件

- 编辑日志体积:频繁的文件创建/删除操作导致EditLog急剧膨胀

- 目录树深度:过深的目录结构(超过10层)会显著降低文件检索效率

数据节点存储浪费

假设1万个1KB文件存储在128MB Block中:- 有效数据:10,000×1KB=9.77MB

- 存储开销:128MB Block 9.77MB = 118.93MB浪费空间

- 空间利用率:仅7.6%

计算任务执行效率

在MapReduce作业中:

- 任务启动延迟:每个小文件生成独立切片,Task启动时间占比达30%以上

- 网络开销:读取1TB小文件需要约2.5亿次RPC调用(按4KB/文件计算)

- CPU资源浪费:任务调度和Speculative Execution机制消耗大量计算资源

主流优化方案对比分析

| 优化方案 | 实现原理 | 适用场景 | 优缺点 |

|---|---|---|---|

| 文件合并 | 通过CombineFileInputFormat等机制将多个小文件合并处理 | 批处理作业场景 | 优点:减少任务数;缺点:可能改变数据访问粒度 |

| 序列化存储 | 使用SequenceFile/Avro容器格式打包小文件 | 日志类小文件存储 | 优点:支持压缩;缺点:增加解码开销 |

| 分层存储架构 | 构建Hadoop Archives(HAR)或使用异构存储系统 | 冷热数据混合场景 | 优点:透明访问;缺点:增加存储复杂度 |

| 存储格式优化 | 采用Parquet/ORC列式存储格式 | 结构化数据场景 | 优点:高压缩比;缺点:需要数据预处理 |

| 元数据优化 | 调整dfs.namenode.fs.limit.max.dir.items等参数 | 大规模目录管理场景 | 优点:提升元数据服务能力;缺点:增加内存消耗 |

实战优化策略

文件预合并处理

使用Hadoop提供的CombineFileInputFormat家族实现:// 配置示例 Configuration conf = new Configuration(); conf.set("mapreduce.input.fileinputformat.split.minsize", "128MB"); conf.set("mapreduce.input.fileinputformat.split.maxsize", "256MB"); Job job = Job.getInstance(conf, "Small File Processing"); job.setInputFormatClass(CombineTextInputFormat.class);该方案可将小文件合并为逻辑Block,使Map任务处理量减少80%以上。

序列化容器应用

采用SequenceFile格式存储日志类小文件:

| 参数项 | 配置建议 | 效果提升 |

|———————–|———————————–|———————————–|

| 压缩编码 | 启用Snappy压缩 | 压缩比提升3-5倍 |

| Key值设计 | 使用时间戳+UUID组合键 | 保证全局唯一性 |

| 缓存策略 | 配置io.seqfile.buffer.size=64KB | 减少磁盘IO次数 |存储层分离架构

构建分级存储体系:graph TD A[热数据] --> B[HDFS] A --> C[Alluxio] D[冷数据] --> E[Amazon S3] D --> F[HDFS Archive]

通过Tachyon/Alluxio构建内存级缓存,将实时访问的小文件加载到内存,同时将历史数据迁移至廉价存储。

元数据优化配置

关键参数调整建议:

| 参数项 | 默认值 | 优化建议 | 作用效果 |

|——————————–|————–|————————|———————————–|

| dfs.namenode.fs.limit.max.dir.items | 100万 | 根据实际需求调整至500万 | 提升单目录容纳能力 |

| dfs.block.size | 128MB | 调整为64MB(视情况) | 平衡Block利用率 |

| dfs.datanode.max.transfer.threads | 40 | 根据磁盘IOPS调整至100+ | 提升并发传输能力 |

最佳实践清单

数据生成端优化

- 实施文件预聚合:在数据落地前完成合并(如Flume通道配置)

- 采用流式数据处理框架(如Apache Kafka)缓冲小记录

存储架构设计

- 构建双层NameNode架构:联邦命名空间+视图文件系统(ViewFileSystem)

- 部署Harbor工具:自动归档旧数据到低成本存储

运维监控体系

- 建立小文件检测机制:通过HDFS UI监控under-replicated blocks

- 配置预警阈值:当目录包含超过10万文件时触发告警

- 定期执行hdfs dfsadmin -report查看存储分布

FAQs

Q1:如何判断当前集群是否受到小文件问题影响?

A1:可通过以下指标诊断:

- NameNode内存使用率持续超过80%

- HDFS浏览器中出现深层目录结构(超过5层嵌套)

- MapReduce任务中出现”Too many open files”错误

- DataNode磁盘IO等待时间超过平均响应时间的50%

Q2:合并后的文件大小如何选择?

A2:建议遵循以下原则:

- 单个合并文件建议控制在2-4个HDFS Block大小(256MB-512MB)

- 根据业务访问模式调整:随机访问为主时适当减小,顺序访问为主时可增大

- 需平衡合并开销与存储效率,通常合并因子建议在100-20