上一篇

hive数据库hdfs

- 行业动态

- 2025-05-11

- 10

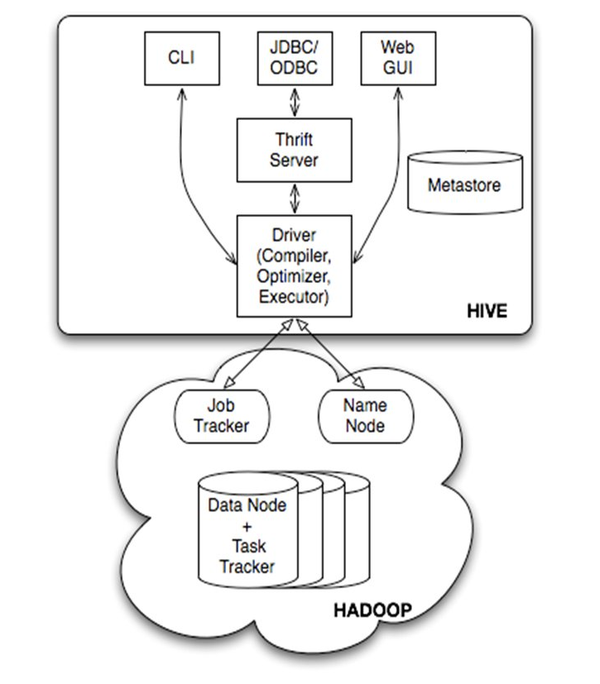

Hive依托 HDFS存储数据,利用MapReduce实现SQL查询,高效处理

Hive数据库与HDFS深度解析及实践应用

Hive和HDFS(Hadoop Distributed File System)是大数据生态中的两大核心组件,分别承担数据计算与存储的职责,Hive作为数据仓库工具,依赖HDFS实现海量数据的分布式存储;而HDFS则为Hive提供高可靠、可扩展的底层存储支持,两者结合构建了完整的“存储-计算”体系,广泛应用于数据分析、ETL处理等场景。

Hive与HDFS的核心概念

| 特性 | Hive | HDFS |

|---|---|---|

| 定位 | 数据仓库工具,SQL-on-Hadoop | 分布式文件系统,底层存储引擎 |

| 数据模型 | 类SQL表结构(分区、桶)、支持ACID | 无结构化,按块存储原始文件 |

| API接口 | SQL、JDBC、Thrift | Java API、命令行(如hadoop fs) |

| 核心功能 | 查询优化、任务调度、元数据管理 | 数据分块、副本复制、容错恢复 |

| 典型应用场景 | 离线数据分析、报表生成 | 大规模数据存储、日志归档 |

Hive通过类SQL语法(HiveQL)将复杂MapReduce任务抽象化,降低开发门槛;HDFS则通过分块存储(默认128MB/块)和多副本机制(默认3副本)保障数据可靠性,支持横向扩展。

Hive与HDFS的协同工作原理

数据存储依赖

Hive表的数据实际存储在HDFS中,元数据(表结构、分区信息等)由Hive的MetaStore服务管理。- 创建Hive表时,数据文件以

.txt、.orc或.parquet格式存入HDFS目录。 - 分区表的分区路径直接映射为HDFS子目录(如

/user/hive/warehouse/partition_date=2023)。

- 创建Hive表时,数据文件以

查询执行流程

- SQL解析:Hive将HiveQL转换为逻辑执行计划。

- 优化编译:生成MapReduce或Spark任务(依赖底层引擎)。

- 任务执行:从HDFS读取数据块,通过YARN调度资源完成计算。

- 结果输出:计算结果可存回HDFS或直接展示。

事务与一致性

- HDFS采用“一次写入,多次读取”模型,天然支持流式数据写入。

- Hive通过引入事务表(

TRANSACTIONAL)和ACID特性,结合HDFS的原子性操作(如Append),实现更新/删除的事务支持。

关键特性与对比

HDFS的存储优势

- 高容错性:数据块自动复制到多个节点,单点故障不影响可用性。

- 横向扩展:通过添加DataNode动态扩容,无需停机。

- 流式处理:适合批量写入大文件(如日志、归档数据),但随机写性能较差。

Hive的计算优势

- SQL兼容性:支持大部分标准SQL语法,降低学习成本。

- 分区与桶:通过分区(如按日期)和桶(Hash分桶)优化查询效率。

- UDF扩展:自定义函数(如

RANK、DATE_FORMAT)增强灵活性。

局限性对比

| 场景 | Hive | HDFS |

|———————–|———————————–|———————————-|

| 实时性要求 | 延迟较高(适合离线分析) | 低延迟读写需结合其他组件(如Kafka)|

| 小文件处理 | 性能下降(需合并小文件) | 元数据压力大,建议最小文件块优化 |

| 数据更新 | 事务表支持有限,需谨慎设计 | 仅支持追加(Append),无原地更新 |

最佳实践与优化策略

Hive优化

- 分区设计:按高频查询字段(如日期、地区)分区,减少全表扫描。

- 文件格式:优先使用

ORC或Parquet格式,支持列式存储和压缩。 - 并行度调优:调整

mapreduce.job.reduces参数,平衡资源消耗。

HDFS优化

- 块大小调整:根据文件特性设置块大小(如日志文件可增大至256MB)。

- 副本策略:冷数据可降低副本数(如1副本),减少存储开销。

- 回收机制:定期清理

/tmp和/user/hive/history目录,释放空间。

联合使用场景

- ETL流程:通过Hive加载HDFS数据,结合

INSERT OVERWRITE刷新中间结果。 - 联邦学习:HDFS存储原始数据,Hive进行特征工程和模型训练。

- ETL流程:通过Hive加载HDFS数据,结合

常见问题与解决方案

FAQs

Q1:Hive查询HDFS数据时提示“文件不存在”?

- 原因:Hive MetaStore元数据与HDFS实际路径不匹配,可能因手动删除HDFS文件或Hive未正确刷新元数据。

- 解决:

- 检查HDFS路径是否存在(

hadoop fs -ls /path)。 - 在Hive中执行

MSCK REPAIR TABLE table_name修复元数据。

- 检查HDFS路径是否存在(

Q2:HDFS小文件过多导致Hive查询缓慢?

- 原因:大量小文件会增加NameNode内存压力,且Map阶段任务启动耗时长。

- 解决:

- 使用

Hive CONCAT命令合并小文件。 - 调整HDFS参数

dfs.namenode.fs-limit-total扩大元数据容量。 - 业务侧优化数据生成逻辑,避免频繁写入小文件。

- 使用