上一篇

分布式数据仓库hive入门

- 行业动态

- 2025-05-09

- 2141

Hive是基于Hadoop的分布式数据仓库,支持HiveQL类SQL语法,数据存储于HDFS,通过将SQL转换为MapReduce任务实现批处理,适合离线数据分析,核心组件包括MetaStore元数据管理和Driver执行引擎,具备良好的横向扩展性,是大数据ETL和OL

分布式数据仓库Hive入门详解

Hive

Hive是基于Hadoop的数据仓库工具,专为处理大规模结构化数据设计,它通过类SQL语法(HiveQL)实现数据查询,底层依赖HDFS存储数据,并借助MapReduce或Tez等计算框架执行任务,Hive的核心优势在于将复杂的分布式计算抽象为熟悉的SQL操作,降低大数据处理门槛。

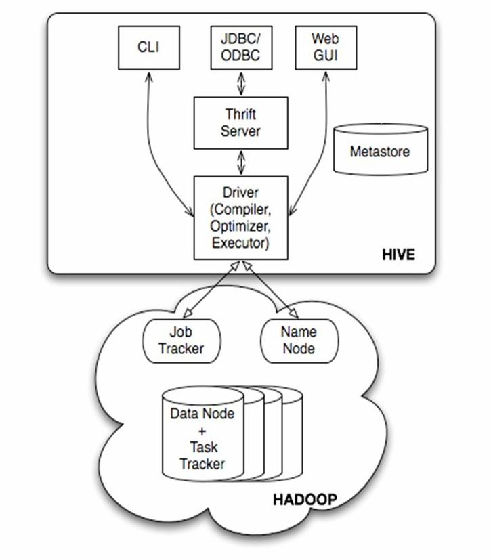

核心架构组件

| 组件名称 | 功能描述 |

|---|---|

| MetaStore | 元数据管理系统,存储数据库、表结构、分区等信息(默认使用内嵌Derby数据库) |

| Driver | 解析HiveQL语句并生成执行计划,协调其他组件工作 |

| Compiler | 将逻辑执行计划转换为物理执行计划(如MapReduce任务) |

| Execution Engine | 实际执行计算任务(可对接MR/Tez/Spark等引擎) |

| HDFS | 底层存储系统,存储Hive表数据(支持ORC/Parquet等列式存储格式) |

环境搭建步骤

前置条件

- Hadoop集群(版本兼容)

- JDK 1.8+

- 配置HADOOP_HOME环境变量

安装流程

# 解压Hive安装包 tar -xzf apache-hive-.tar.gz -C /opt/ cd /opt/apache-hive- # 配置环境变量 export HIVE_HOME=/opt/apache-hive- export PATH=$PATH:$HIVE_HOME/bin # 初始化元数据库 schematool -dbType mysql -initSchema

关键配置文件

| 文件名 | 作用 |

|—————–|——————————-|

| hive-site.xml | 核心配置(连接MetaStore、HDFS)|

| hive-env.sh | 设置Java_HOME、HADOOP_HOME等 |

基础操作实践

创建数据库与表

CREATE DATABASE retail_db; USE retail_db; CREATE TABLE orders ( order_id BIGINT, customer_id STRING, order_date DATE, amount DECIMAL(10,2) ) STORED AS ORC; -列式存储优化查询性能数据加载方式

| 方式 | 命令示例 |

|———————|————————————————————————–|

| 从本地文件导入 |LOAD DATA INPATH '/data/orders.csv' INTO TABLE orders;|

| 从HDFS文件导入 |LOAD DATA INPATH 'hdfs:///user/data/orders.csv' INTO TABLE orders;|

| 直接插入数据 |INSERT INTO orders VALUES(1,'C001','2023-01-01',99.99);|查询与分析

-基础查询 SELECT FROM orders WHERE amount > 100; -聚合分析 SELECT customer_id, COUNT() AS order_count FROM orders GROUP BY customer_id; -窗口函数 SELECT order_id, amount, RANK() OVER (ORDER BY amount DESC) AS rank FROM orders;

存储格式与优化策略

| 存储格式 | 特点 |

|---|---|

| Text | 行式存储,适合小规模数据,无压缩导致IO开销大 |

| ORC | 列式存储,支持压缩(Zlib/Snappy),高效列式读取,适合复杂查询 |

| Parquet | 列式存储,支持更多压缩算法,与Spark生态兼容性好 |

| Avro | 基于Schema的二进制格式,支持数据演化 |

优化建议:

- 分区表:按时间/地域等维度分区,减少全表扫描

CREATE TABLE orders_partitioned ( order_id BIGINT, customer_id STRING, amount DECIMAL(10,2) ) PARTITIONED BY (order_date DATE) STORED AS ORC; - Bucketing:哈希分桶提升join效率

CLUSTERED BY (customer_id) INTO 10 BUCKETS; -创建10个分桶

- 索引:创建Compacted/Bitmap索引加速特定字段查询

Hive与RDBMS对比分析

| 特性 | Hive | 传统数据库(如MySQL) |

|---|---|---|

| 数据规模 | PB级分布式存储 | GB级集中式存储 |

| 延迟 | 高(分钟级) | 低(毫秒级) |

| 扩展性 | 横向扩展(Add Nodes) | 纵向扩展(硬件升级) |

| 事务支持 | ACID支持有限 | 完整ACID支持 |

| 适用场景 | ETL批处理、离线分析 | OLTP在线交易、实时查询 |

常见问题与解决方案

Q1:Hive执行速度慢如何解决?

- 优化方向:

- 启用列式存储(ORC/Parquet)+ 压缩

- 合理设计分区/分桶策略

- 使用Tez/Spark替代MapReduce引擎

- 调整并行度参数(set mapreduce.job.reduces=10;)

Q2:如何保障Hive数据一致性?

- ACID事务配置:

在hive-site.xml中启用:<property> <name>hive.support.concurrency</name> <value>true</value> </property> <property> <name>hive.enforce.bucketing</name> <value>true</value> </property> <property> <name>hive.exec.dynamic.partition.mode</name> <value>nonstrict</value> </property> - 使用Insert Overwrite代替Insert Into:避免脏