上一篇

hive是一种什么模式数据仓库

- 行业动态

- 2025-05-08

- 4

Hive是基于Hadoop的离线数据仓库,采用类SQL查询语言(HiveQL),支持大规模数据

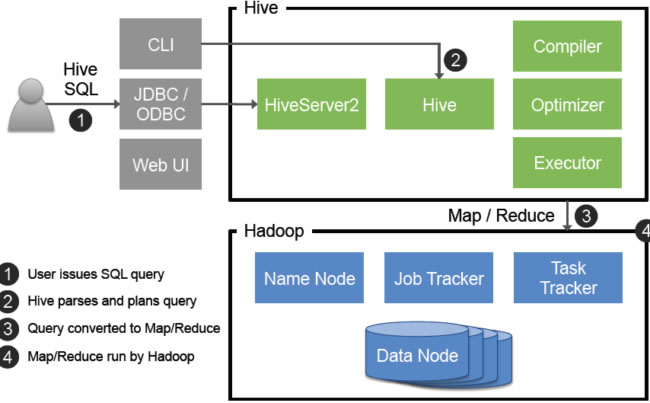

Hive是一种基于Hadoop生态系统的分布式数据仓库解决方案,采用典型的离线批处理模式,专为大规模数据分析场景设计,其核心架构融合了SQL-like查询语言(HiveQL)、HDFS存储引擎和MapReduce计算框架,通过类数据库表结构组织数据,支持复杂查询和ETL操作,以下从技术架构、模式特征、核心组件、适用场景等多个维度展开分析:

Hive的技术架构与模式特征

| 维度 | Hive特性描述 |

|---|---|

| 计算模式 | 批处理模式(基于MapReduce/Tez/Spark) |

| 存储层 | 依托HDFS构建分区式列存表,支持ORC/Parquet等高效存储格式 |

| 数据模型 | 类关系型数据库表结构(外部表/内部表),支持分区、桶排序、SerDe序列化机制 |

| 查询接口 | HiveQL(兼容SQL-92标准,扩展UDF/UDAF函数) |

| 元数据管理 | MetaStore(独立关系型数据库存储元数据) |

| 事务支持 | 基础版本无ACID事务(Hive 3.0+支持受限事务) |

核心存储模式

- 静态列式存储:数据按表结构写入HDFS,块状存储优化扫描效率,适合读多写少场景

- 分区与桶策略:通过分区字段(如日期)实现物理隔离,桶(Hash分布)优化Join操作

- 文件格式演进:从Text/SequenceFile到ORC/AVRO,存储效率提升300%+(压缩比优化)

计算执行模式

- 声明式查询转换:HiveQL → 逻辑执行计划 → 物理执行计划(MapReduce任务链)

- 向量化执行:Hive 3.0+支持Vectorization,单节点性能提升50%以上

- 资源隔离:通过YARN整合实现计算资源动态分配,避免Hadoop集群资源争抢

Hive与传统数据仓库的对比分析

| 对比维度 | 传统数仓(如Teradata) | Hive数据仓库 |

|---|---|---|

| 扩展性 | 垂直扩展(硬件堆砌) | 水平扩展(添加节点) |

| 成本模型 | 高昂的专有硬件/软件授权 | 开源免费(Hadoop生态) |

| 数据吞吐 | TB级/小时(优化硬件) | PB级/天(HDFS吞吐量) |

| 实时性 | 亚秒级响应(MPP架构) | 分钟级延迟(批处理本质) |

| 灵活性 | 固定Schema强约束 | Schema-on-read(允许数据宽松写入) |

典型架构差异图示

传统数仓: [客户端] ←→ [MPP计算层] ←→ [专用存储]

Hive数仓: [客户端] ←→ [Hive MetaStore] ←→ [HDFS] + [YARN]Hive的核心组件与工作机制

元数据管理层

- MetaStore:集中存储表结构、分区信息、权限配置,支持MySQL/PostgreSQL等RDBMS

- Metadata Locking:通过ZooKeeper实现分布式锁,保证元数据一致性

查询执行层

- Driver:解析HiveQL → 生成抽象语法树(AST) → 转换为物理执行计划

- Execution Engine:早期MapReduce(高延迟),现支持Tez(DAG调度)、Spark(内存计算)

- Optimizer:谓词下推、列式裁剪、Join重排序等优化策略

存储管理层

- HDFS交互:通过InputFormat/OutputFormat接口实现数据读写

- 文件合并策略:小文件合并(避免Map任务过载)、动态分区调整

Hive的适用场景与局限性

优势场景

- 海量数据ETL:每日PB级日志处理、用户行为分析

- 复杂分析查询:多表Join、窗口函数、CTE递归查询

- 历史数据归档:冷数据存储与长期分析需求

- BI报表支撑:通过ODBC/JDBC连接Tableau/PowerBI

典型局限

- 实时性缺陷:分钟级查询延迟不满足即时决策需求

- 事务限制:仅支持Insert操作,无Update/Delete原生支持

- 资源消耗:复杂查询可能占用整个YARN队列资源

- 学习曲线:HiveQL与标准SQL存在10%-15%语法差异

Hive生态工具对比矩阵

| 工具类别 | Hive原生 | Impala | Spark SQL | Presto |

|---|---|---|---|---|

| 计算引擎 | MapReduce/Tez | Mpp SQL引擎 | 内存计算引擎 | DAG调度引擎 |

| 实时性 | 高延迟 | 亚秒级响应 | 中等延迟 | 低延迟 |

| 资源模型 | YARN共享池 | 独立资源池 | 独立资源池 | 无绑定资源 |

| SQL兼容性 | HiveQL扩展 | 标准SQL | 标准SQL | 标准SQL |

| 部署复杂度 | 低(依赖Hadoop) | 中(需协调资源) | 高(独立集群) | 极低(无依赖) |

企业落地实践建议

- 混合部署策略:Hive+Impala/Spark SQL构建Lambda架构

- Hive处理>10TB的历史数据分析

- Impala/Spark应对实时交互查询

- 存储优化方案:

- ORC文件格式(压缩+列式存储)

- BloomFilter索引加速查询

- 分区字段设计遵循访问模式(如按天/地区分区)

- 性能调优要点:

- 合理设置

mapreduce.job.reduces(避免数据倾斜) - 开启CBO(Cost-Based Optimizer)优化器

- 使用Bucket MapJoin替代Reduce端Join

- 合理设置

FAQs

Q1:Hive是否支持事务处理?

A1:Hive 3.0+版本引入ACID事务特性,但需满足以下条件:

- 启用

hive.txn.manager配置 - 使用支持事务的存储格式(如ORC)

- 开启WAL(Write-Ahead Logging)机制

注:事务支持会增加约15%-20%的存储开销,适用于需要少量更新的场景。

Q2:如何提升Hive查询性能?

A2:关键优化措施包括:

- 存储层优化:

- 使用ORC格式并开启Zlib压缩

- 创建空值敏感的统计信息(ANALYZE COMMAND)

- 查询改写:

- 避免全表扫描,利用分区裁剪(PARTITION PRUNING)

- 将子查询转为JOIN操作

- 资源配置:

- 调整

mapreduce.map.memory.mb(默认1024MB) - 启用

hive.exec.parallel并行执行DDL/DML

- 调整

- 执行引擎升级:

- 替换MapReduce为Tez引擎(降低50%+执行时间)

- 对热数据启用LLAP(Low Latency Abstract