上一篇

hadoop云计算实战

- 行业动态

- 2025-05-10

- 9

Hadoop云计算实战基于分布式框架,通过HDFS实现海量数据存储,结合MapReduce并行计算与YARN资源调度,支撑数据挖掘、机器学习等场景,具备高扩展性与容错能力,有效降低

Hadoop云计算实战:从部署到优化的完整指南

Hadoop作为大数据处理的核心框架,在云计算环境中的部署与优化是企业实现高效数据处理的关键,本文将从架构设计、云平台选择、部署流程、性能调优到实际应用场景展开,结合表格对比和实战经验,提供一份详细的Hadoop云计算实战手册。

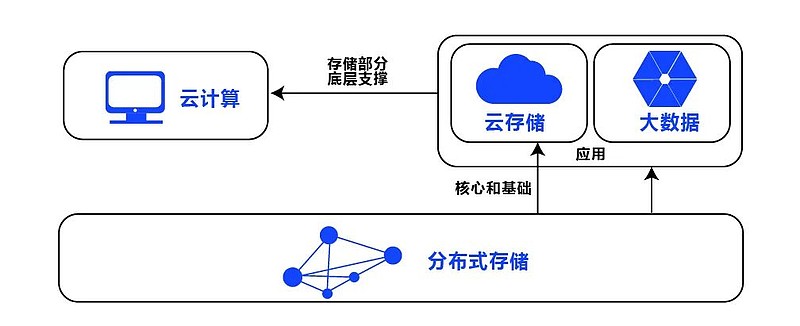

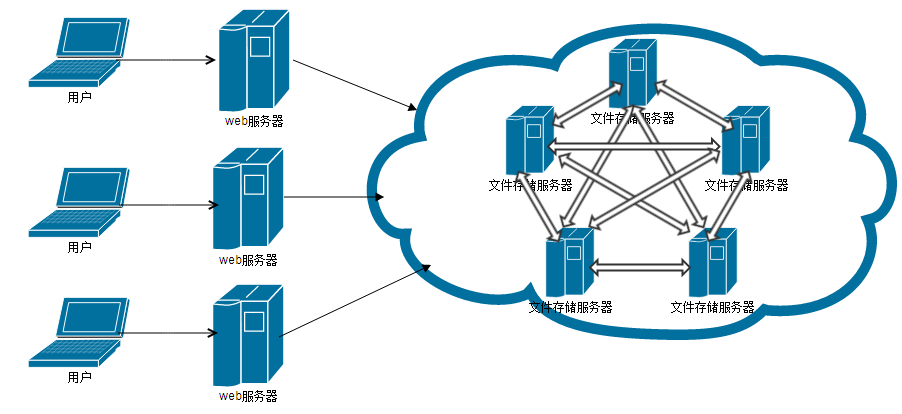

Hadoop云计算架构设计

在云环境中部署Hadoop集群时,需结合公有云特性设计高可用、弹性扩展的架构,以下是核心组件与云服务的对应关系:

| Hadoop组件 | 云服务替代方案 | 作用 |

|---|---|---|

| HDFS NameNode | 云存储(如AWS S3、Azure Blob Storage) | 元数据管理与持久化存储 |

| ResourceManager | 云容器服务(如AWS ECS、Azure ACI) | 资源调度与任务分配 |

| NodeManager | 云虚拟机/容器实例 | 任务执行与资源监控 |

| YARN | 云托管Yarn服务(如EMR、HDInsight) | 统一资源管理 |

架构设计要点:

- 存储层:优先使用云对象存储(如S3)替代HDFS,通过

s3a://协议实现数据读写,降低存储成本。 - 计算层:采用容器化部署(如Docker+Kubernetes),通过云自动伸缩组(Auto Scaling)动态调整计算节点。

- 网络层:利用云VPC(虚拟私有云)隔离集群,配置安全组与NAT网关保障内网通信安全。

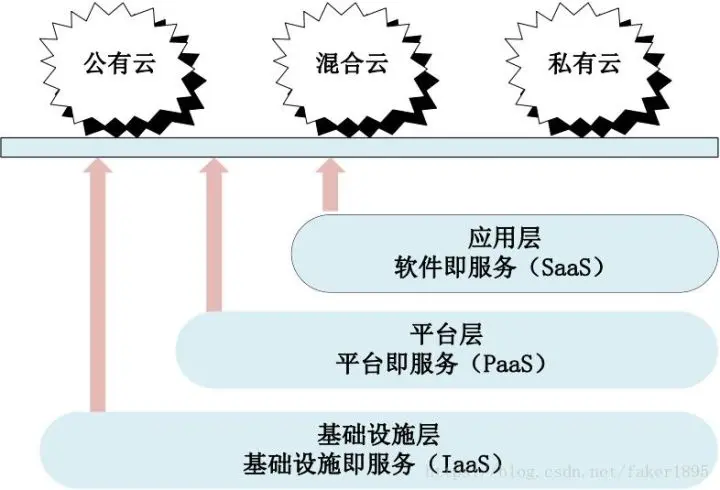

云平台选择与部署流程

主流公有云均提供Hadoop托管服务,需根据业务需求选择:

| 云服务商 | 产品 | 特点 |

|---|---|---|

| AWS | EMR(Elastic MapReduce) | 支持Spot Instance节省成本,集成S3、Redshift |

| Azure | HDInsight | 与Azure Data Lake深度集成,支持Serverless |

| 阿里云 | E-MapReduce | 兼容Hadoop 3.x,支持MaxCompute加速查询 |

| 酷盾安全 | TCE(Tencent Cloud Emr) | 提供私有化部署方案,适配国产化硬件 |

部署步骤(以AWS EMR为例):

- 环境准备:创建S3存储桶存放输入数据,配置IAM角色赋予EMR访问权限。

- 集群配置:

- 主节点类型:

m5.xlarge(4核16GB内存) - Core节点类型:

r5.8xlarge(32核256GB内存) - 启用Spot Instance降低计算成本。

- 主节点类型:

- 软件配置:通过Bootstrap Action安装必要插件(如Spark、Hive)。

- 自动化部署:使用Terraform编写IaC脚本,定义集群资源与参数。

性能调优与成本控制

Hadoop在云环境中的性能瓶颈通常集中在存储、计算与网络三个层面,需针对性优化:

| 优化方向 | 具体措施 |

|---|---|

| 存储优化 | 启用S3分片上传(Multipart Upload) 使用S3 Select过滤数据 压缩存储格式(ORC/Parquet) |

| 计算优化 | 调整YARN内存参数(yarn.nodemanager.resource.memory-mb)启用动态资源分配(DRMA) |

| 网络优化 | 配置VPC端点(Endpoint)直连S3 启用EBS优化型实例提升磁盘IOPS |

成本控制策略:

- 按需与预留实例混合:核心主节点使用预留实例,计算节点使用Spot Instance。

- 数据生命周期管理:通过S3 Lifecycle Policy将冷数据转移至低频存储(如GLACIER)。

- 自动缩容:设置空闲超时规则,自动终止闲置计算节点。

监控与运维管理

云原生监控工具可显著降低运维复杂度:

| 监控指标 | 工具/服务 | 阈值示例 |

|---|---|---|

| CPU/内存使用率 | Amazon CloudWatch(自定义Dashboard) | Core节点CPU >80%持续5分钟触发告警 |

| 磁盘IOPS | Prometheus + Grafana | 写入延迟 >500ms触发扩容 |

| SLA合规性 | AWS Trusted Advisor | 检查安全组配置、闲置资源 |

日志管理方案:

- 集中式日志:通过EMR自带日志推送功能将NodeManager日志存入S3。

- 异常检测:使用CloudWatch Logs Insights分析错误日志(如Container超时)。

典型应用场景与实战案例

大规模日志分析:

- 流程:通过Flume采集Nginx日志→存入S3→EMR Spark作业清洗数据→结果写入Redshift。

- 优化点:启用S3 Select跳过无效日志行,减少Shuffle阶段数据传输。

机器学习模型训练:

- 流程:S3存储训练数据→EMR Spark运行ALS算法→模型参数存至S3。

- 优化点:使用Spot Instance配合Checkpointing机制,失败自动重试。

数据仓库加速:

- 方案:Hadoop集群预处理原始数据→生成列式存储文件→导入AWS Redshift。

- 收益:相比直接加载CSV,预处理后查询性能提升3倍以上。

FAQs:Hadoop云计算常见问题解答

Q1:如何选择云存储类型(例如标准S3 vs SSD)?

A1:若数据频繁读写(如中间结果存储),优先选择SSD(如AWS EBSS);若为长期归档或冷数据,使用标准S3即可,可通过S3生命周期策略自动分层存储。

Q2:如何根据任务类型调整计算资源?

A2:

- CPU密集型任务(如MapReduce排序):增加Core节点vCPU核心数,选择

c5系列实例。 - 内存密集型任务(如Spark Shuffle):扩大

yarn.scheduler.maximum-allocation-mb参数,选用r5系列高内存实例。 - 突发流量:启用Auto Scaling策略,设置CloudWatch触发器动态扩容