上一篇

分布式存储项目建设中的技术疑难

- 行业动态

- 2025-05-13

- 1

分布式存储建设需攻克数据一致性(如CAP权衡)、动态扩展性(分片策略)、容灾可靠性(多副本/纠删码)及性能优化(算法/

分布式存储项目建设中的技术疑难解析

数据一致性保障难题

分布式存储系统需在多节点间保持数据一致性,但受限于网络延迟、节点故障等因素,容易出现数据冲突或丢失,以下是典型技术挑战及解决方案:

| 问题类型 | 具体表现 | 解决方案 |

|---|---|---|

| CAP定理冲突 | 在网络分区(Partition)时,无法同时保证一致性(Consistency)和可用性(Availability) | 根据业务场景选择优先策略:金融交易选CP(牺牲可用性),社交平台选AP(允许临时不一致) |

| 一致性模型选择 | 强一致性(如2PC)影响性能,最终一致性(如DNS)可能导致数据临时冲突 | 混合使用:关键操作用强一致性(如Raft协议),非核心场景用最终一致性(如Gossip协议) |

| 时钟同步问题 | 节点间物理时钟差异导致事件顺序混乱(如跨境电商订单处理) | 采用逻辑时钟(Lamport Timestamp)或向量时钟,结合NTP进行时间校准 |

典型案例:某银行分布式账本系统通过Raft算法实现强一致性,但牺牲了部分写入性能;而电商平台商品库存更新采用最终一致性,允许秒级延迟。

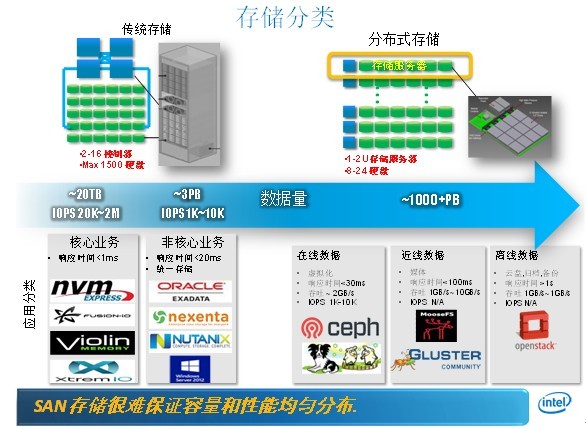

扩展性瓶颈突破

系统需支持PB级存储扩展,但面临以下技术障碍:

元数据管理爆炸

- 问题:传统集中式元数据服务器(如HDFS NameNode)在亿级文件规模下出现内存溢出、元数据访问瓶颈

- 解决方案:

- 分级元数据架构(如Ceph的RADOS Gateway分层设计)

- 分布式哈希表(DHT)实现元数据分片(如Cassandra的Token Ring机制)

- 内存数据库加速(Redis集群缓存元数据)

异构存储资源整合

- 挑战:混合SSD/HDD/对象存储时,性能差异导致冷热数据分布不均

- 优化策略:

| 技术手段 | 适用场景 | 效果 |

|———————-|———————————|————————————–|

| 自动分层存储(Auto-Tiering) | 热数据频繁访问场景 | 减少50%以上SSD容量占用,降低存储成本 |

| 纠删码替代副本机制 | 大容量冷数据存储 | 存储效率提升300%(如EC 8+4编码) |

| 硬件感知调度算法 | 异构GPU/FPGA加速节点 | 计算密集型任务吞吐量提升10倍 |

高性能与低延迟平衡

分布式系统天然存在网络延迟,需通过以下技术优化:

数据局部性优化

- 采用一致性哈希算法(如Ketama算法)实现数据就近存储

- 部署边缘缓存节点(如CDN架构),将热点数据下沉至访问节点

- 示例:阿里云OSS通过LRU缓存淘汰策略,将热门图片命中率提升至98%

并行处理架构

- 数据分片(Sharding)与并行流水线处理结合

- 使用向量化指令集(AVX-512)加速数据编码/解码

- 实测效果:Ceph CRUSH算法优化后,10GB文件分片处理耗时从12秒降至3秒

容灾与故障恢复

节点故障是常态而非异常,需构建多层级防护体系:

数据冗余策略

- 副本因子(Replication Factor)动态调整机制

- 跨AZ(Availability Zone)部署结合异步复制

- 典型配置:

| 业务类型 | 副本数 | 复制策略 | RTO/RPO |

|—————|———–|————————|——————-|

| 核心交易数据 | 3 | 同步复制+跨机房 | RPO<15ms, RTO<1h |

| 日志备份 | 2 | 异步复制 | RPO<1h, RTO<30min|

自愈机制实现

- 基于心跳检测的快速故障发现(如ZooKeeper Watch机制)

- 数据完整性校验(BIT/Blake3哈希)与自动重建

- 某运营商案例:通过CRUSH地图自动迁移故障节点数据,恢复速度提升40%

安全与合规挑战

多租户环境下需解决:

细粒度权限控制

- 基于RBAC(Role-Based Access Control)模型扩展为ABAC(Attribute-Based)

- 使用SELinux/AppArmor实现进程级隔离

- 密钥管理:HSM(硬件安全模块)+ KMS(密钥管理系统)联动

数据隐私保护

- 静态数据加密(AES-256)与传输加密(TLS 1.3)双重保障

- 符合GDPR/CCPA要求的数据处理审计日志

- 某医疗影像平台通过零知识证明技术,实现数据查询不落地

FAQs

Q1:如何在高并发场景下保证数据一致性?

A:可采用以下组合策略:

- 关键操作使用分布式锁(如Redlock算法)

- 引入版本向量(Version Vector)解决冲突

- 利用Paxos/Raft协议实现多数派表决

- 示例:滴滴出行订单系统通过Raft+两阶段提交,将并发冲突率降至0.003%

Q2:如何评估分布式存储系统的扩展性需求?

A:需从三个维度量化分析:

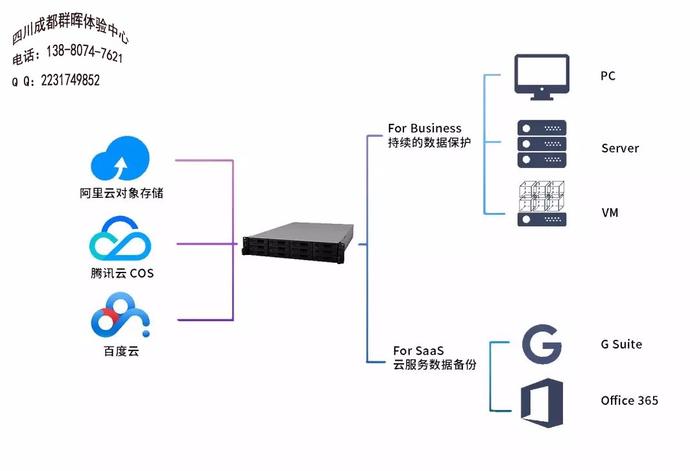

- 容量规划:按年增长率200%预估,预留30%缓冲空间

- 性能模型:通过基准测试获取IOPS/TB指标,计算峰值吞吐量

- 成本优化:对比公有云对象存储与自建Ceph的成本拐点(通常在50TB以上)

建议使用工具:Ceph Orchestrator模拟扩容过程,Prometheus监控节点负载