上一篇

分布式海量数据存储技术原理

- 行业动态

- 2025-05-06

- 4351

通过分片、多副本、负载均衡及容错机制,实现海量数据的高效存储

分布式海量数据存储技术原理详解

核心原理

分布式海量数据存储技术通过将数据分散存储在多个物理节点上,结合网络通信、数据分片、冗余备份等机制,实现数据的高效存储、快速访问和高可靠性保障,其核心目标包括:

- 扩展性:支持PB级甚至EB级数据存储,动态扩展存储容量和性能。

- 高可用性:通过数据冗余和故障转移机制,保证节点故障时数据不丢失。

- 高性能:通过并行化数据读写和负载均衡,提升吞吐量和响应速度。

- 低成本:利用普通硬件设备(如PC服务器)构建集群,降低硬件成本。

关键技术解析

分布式存储系统的实现依赖于以下核心技术:

| 技术组件 | 功能描述 | 典型实现 |

|---|---|---|

| 数据分片(Sharding) | 将数据划分为多个片段,分散存储到不同节点,平衡负载并支持水平扩展。 | 哈希分片、范围分片、目录分片 |

| 数据副本(Replication) | 为每个分片创建多个副本,分布在不同节点或机架,提升数据可靠性和读取性能。 | 主从复制、链式复制、RAID码 |

| 元数据管理(Metadata Management) | 记录数据分片的位置、副本信息等,支持快速定位和路由。 | ZooKeeper、Etcd、自定义算法 |

| 一致性协议(Consensus Protocol) | 确保分布式环境下数据的一致性,解决并发冲突和节点故障问题。 | Paxos、Raft、ZAB协议 |

| 负载均衡(Load Balancing) | 动态调整数据分布,避免热点节点过载,优化资源利用率。 | 一致性哈希、虚拟节点、动态迁移 |

数据分片原理

数据分片是分布式存储的基础,常见策略包括:

- 哈希分片:根据Key的哈希值取模,均匀分配到不同节点,Key为

user123的数据,通过hash("user123") % N(N为节点数)确定存储位置。 - 范围分片:按数据范围划分,如时间戳或ID区间,订单数据按日期分片,

2023-01-01至2023-01-10的数据存储在节点A。 - 目录分片:基于目录树结构,适用于多维数据(如地理坐标),但实现复杂度较高。

数据副本机制

副本机制通过冗余存储提升可靠性,常见策略包括:

- 全量副本:每个分片的所有数据均复制到多个节点(如3副本),适用于强一致性需求场景。

- 纠删码(Erasure Coding):将数据分割为多个块,并生成冗余校验块,减少存储开销,HDFS采用6+3纠删码,存储效率比副本高。

- 副本放置策略:副本需分布在不同机架或数据中心,避免单点故障导致数据不可用。

元数据管理

元数据是存储系统的核心,需解决以下问题:

- 元数据存储:通常由专用节点(如NameNode)或分布式数据库(如ZooKeeper)管理。

- 元数据一致性:通过分布式锁或版本控制,确保元数据更新的原子性。

- 元数据性能优化:缓存热点元数据,减少访问延迟。

分布式存储架构设计

典型的分布式存储系统架构分为以下层次:

| 层级 | 功能模块 | 关键技术 |

|---|---|---|

| 客户端层 | 提供数据读写接口,支持SDK或RESTful API。 | 负载均衡、连接池、异步IO |

| 路由层 | 根据元数据路由请求到对应存储节点。 | 一致性哈希、DNS负载均衡 |

| 存储节点层 | 实际存储数据分片和副本,处理读写请求。 | 本地文件系统(如EXT4)、SSD优化 |

| 元数据管理层 | 维护数据分片、副本、节点状态等信息。 | ZooKeeper、Etcd、自研分布式数据库 |

| 监控与管理层 | 监控系统健康状态,触发故障恢复和负载均衡。 | Prometheus、AlertManager、自动化脚本 |

经典架构案例

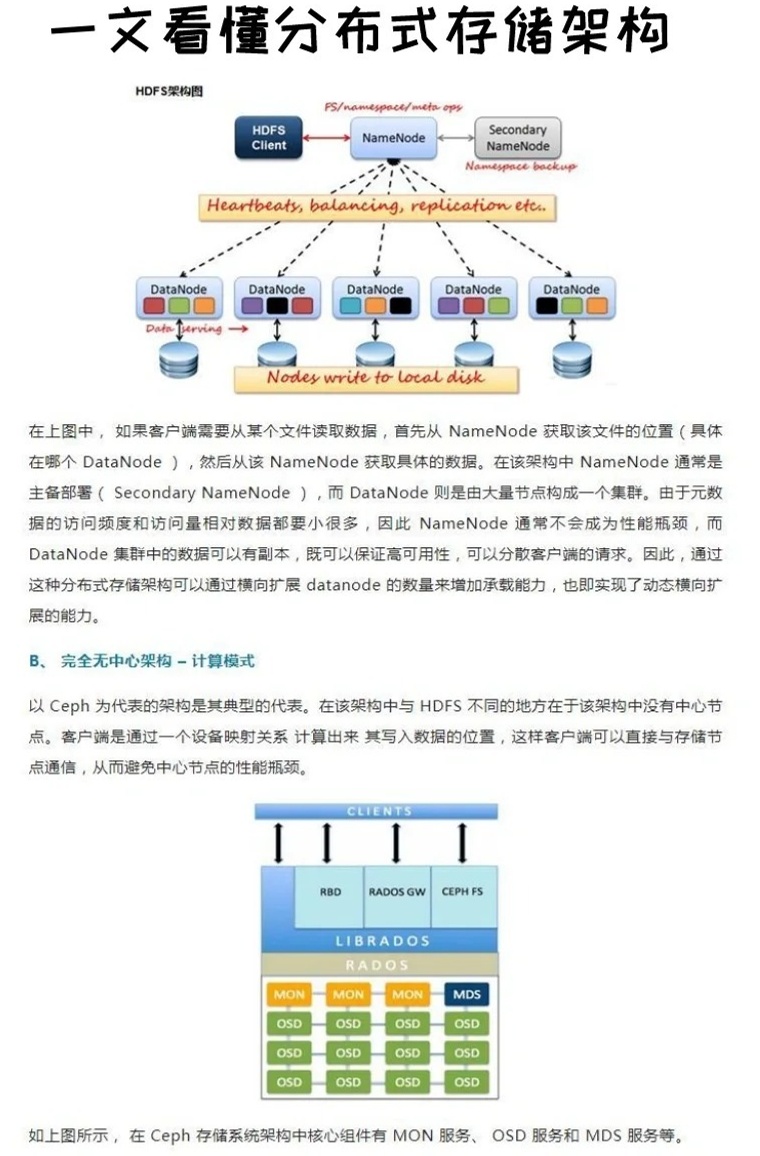

- HDFS(Hadoop Distributed File System):采用Master-Slave架构,NameNode管理元数据,DataNode存储数据块,默认3副本策略。

- Ceph:基于CRUSH算法实现数据分片和副本分布,支持对象存储、块存储和文件存储。

- Cassandra:去中心化架构,无单点故障,通过Gossip协议同步元数据。

挑战与解决方案

分布式存储面临的核心挑战及应对策略如下:

| 挑战 | 问题描述 | 解决方案 |

|---|---|---|

| 数据一致性 | 分布式环境下如何保证数据强一致性? | 使用Paxos/Raft协议实现分布式共识,或采用最终一致性模型(如DynamoDB)。 |

| 节点故障 | 节点宕机导致数据不可用或丢失。 | 自动故障检测(心跳机制)、副本重选、数据迁移。 |

| 扩展性瓶颈 | 元数据管理节点成为性能瓶颈。 | 采用分布式元数据存储(如MDS集群)、分片元数据。 |

| 网络分区 | 数据中心网络故障导致分区内数据不一致。 | CAP定理权衡(优先AP或CP)、多副本跨机房部署。 |

| 冷热数据分层 | 高频访问数据与冷数据混合存储导致资源浪费。 | 基于LSM树的分层存储、冷热数据分离(如TiDB)。 |

应用场景与实践

分布式海量存储技术广泛应用于以下场景:

- 大数据分析:如Hadoop、Spark集群依赖HDFS存储TB/PB级数据。

- 云存储服务:AWS S3、阿里云OSS等对象存储服务基于分布式架构实现。

- 视频与图片存储:抖音、Netflix等平台使用分布式存储处理海量多媒体数据。

- 物联网(IoT):传感器数据流式写入分布式系统,支持实时查询与分析。

FAQs

问题1:分布式存储与集中式存储的核心区别是什么?

答:集中式存储依赖单一节点(如NAS/SAN),存在容量和性能上限,且单点故障可能导致数据丢失,分布式存储通过多节点协同,实现容量无限扩展、高可用性和负载均衡,适合海量数据场景。

问题2:如何选择合适的分布式存储系统?

答:需考虑以下因素:

- 数据规模:EB级数据需选择支持横向扩展的系统(如Ceph)。

- 一致性要求:强一致性需求选择基于Raft协议的系统(如etcd),最终一致性可选Cassandra。

- 成本:开源系统(如MinIO)适合预算有限场景,商业系统(如NetApp)提供更高可靠性。

- 场景适配:对象存储(S3协议)、块存储(iSCSI)或文件存储(NFS)