上一篇

分布式海量数据存储与分析

- 行业动态

- 2025-05-07

- 3896

分布式海量数据存储与分析基于分布式架构,通过数据分片与并行

核心技术与实践

分布式海量数据存储的核心概念

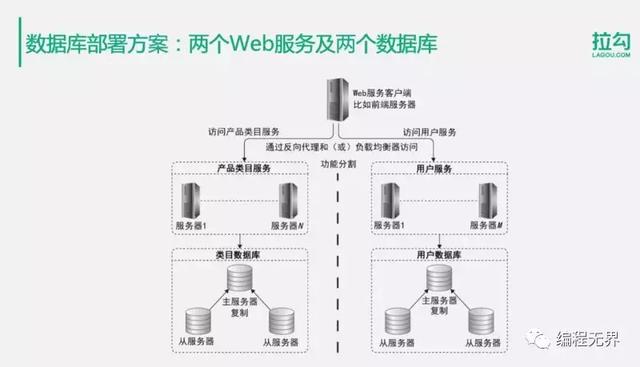

分布式海量数据存储是指通过多台服务器协同工作,将大规模数据集分散存储在物理或逻辑节点中,同时保证数据的高可用性、可扩展性和一致性,其核心目标是解决传统单机存储系统在容量、性能和可靠性方面的瓶颈问题。

关键特性:

- 横向扩展性:通过增加节点实现存储容量和计算能力的线性扩展。

- 数据分片:将数据拆分为多个片段(Shard),分布到不同节点。

- 冗余备份:通过数据副本(Replication)保证高可用性。

- 负载均衡:动态分配读写请求,避免单点压力过大。

主流分布式存储技术对比

| 技术类型 | 代表框架/系统 | 数据模型 | 适用场景 | 一致性保障 |

|---|---|---|---|---|

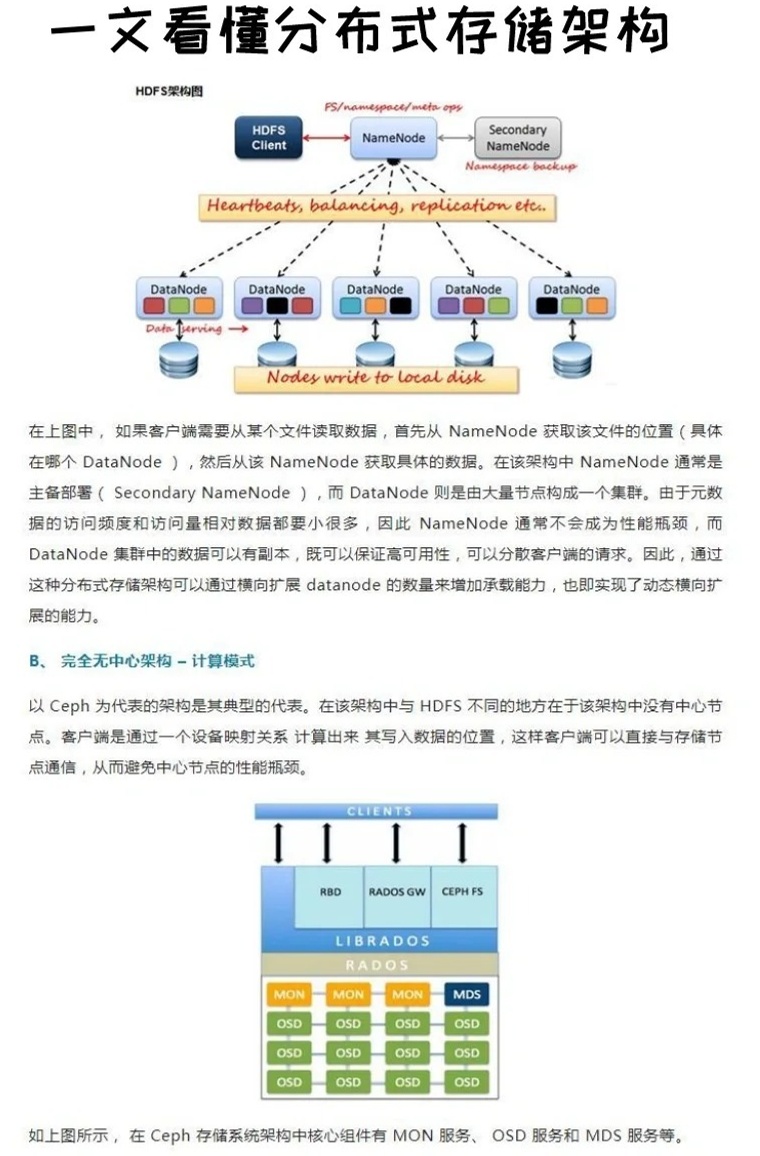

| 分布式文件系统 | HDFS(Hadoop) | 块存储(Block Storage) | 大规模日志、音视频文件 | 最终一致性(Base HA) |

| 分布式数据库 | Cassandra | 键值/宽行(Key-Value) | 高并发写入(如社交应用) | Tumbstone标记删除 |

| MongoDB | 文档型(Document) | 半结构化数据(如JSON) | 强一致性(Write Concern) | |

| 对象存储 | Ceph/MinIO | 扁平化键值对(Object) | 非结构化数据(如图片) | 版本控制 |

| 新型存储引擎 | TiKV(TiDB) | 事务型(Transactional) | 混合OLTP/OLAP场景 | RAFT协议强一致 |

分布式数据分析的技术体系

分布式数据分析需解决数据规模大、计算复杂度高、实时性要求差异等问题,典型技术栈包括:

批处理框架

- MapReduce:通过”分而治之”思想处理PB级数据,适合离线分析(如用户行为统计)。

- Spark:基于内存计算优化迭代式作业,支持SQL(Spark SQL)、机器学习(MLlib)等高级接口。

- Flink:兼顾批处理和流处理,支持事件时间(Event Time)语义。

流处理引擎

- Kafka Streams:轻量级实时数据处理,适合日志聚合、指标监控。

- Storm:低延迟流处理,适用于金融交易风控等场景。

- Beam Model:Google提出的统一编程模型,支持多引擎(如DirectRunner、Flink)。

混合分析技术

- OLAP on Cloud: Snowflake、ClickHouse等云原生列式存储,支持TB级数据实时交互查询。

- HTAP系统:如TiDB通过Raft协议实现事务与分析混合负载。

存储与分析的协同优化

| 优化维度 | 关键技术 | 典型案例 |

|---|---|---|

| 数据分区 | 范围分区(Range)、哈希分区(Hash)、列表分区(List) | Kafka按消息键哈希分区 |

| 索引加速 | 倒排索引(Elasticsearch)、LSM树(HBase)、Bloom过滤器 | 电商搜索使用ES倒排索引 |

| 计算近数据 | 数据本地性优化(Data Affinity)、Co-location调度 | Spark任务优先调度到数据节点 |

| 成本控制 | 冷热数据分层(Tiering)、对象生命周期管理(GLACIER) | 阿里云OSS归档存储 |

| 异构计算 | CPU+GPU混合部署、FPGA加速特定算法 | 深度学习推理使用TPU |

典型应用场景与挑战

互联网用户行为分析

- 场景:日志采集→Kafka传输→Spark Streaming实时处理→Redis缓存热点数据→Hive离线存档。

- 挑战:峰值流量冲击(如双十一)、多维度组合查询性能。

金融风控系统

- 需求:毫秒级延迟检测欺诈交易,强数据一致性。

- 方案:Kafka+Flink CEP(复杂事件处理)+TiDB事务存储。

物联网时序数据处理

- 特点:高频写入(万级TPS)、长期存储(10年以上)。

- 技术:InfluxDB+Grafana可视化,或TDengine专用时序数据库。

核心挑战:

- CAP定理权衡:如Consistency与Availability的取舍(ZAB协议 vs Raft协议)。

- 数据倾斜:Key分布不均导致部分节点过载,需结合Hash+Range混合分片。

- Schema演进:NoSQL数据库需支持在线模式变更(如Cassandra的ALTER TABLE)。

未来发展趋势

- 存算一体化:通过NVMe-oF协议实现存储与计算资源池化。

- Serverless化:AWS Redshift Spectrum支持跨源联邦查询。

- AI驱动优化:自动调优参数(如Spark自适应执行引擎)。

- 边缘计算融合:在IoT设备端进行预处理,降低中心节点压力。

FAQs

Q1:什么是CAP定理,如何在分布式系统中取舍?

A:CAP定理指出分布式系统无法同时满足一致性(Consistency)、可用性(Availability)、分区容错性(Partition Tolerance),常见策略:

- CP优先:金融系统选择牺牲部分可用性保证数据一致(如ZooKeeper)。

- AP优先:社交媒体采用最终一致性,允许短暂数据延迟(如DynamoDB)。

- 混合策略:通过Paxos/Raft协议在多数节点达成一致,兼顾CA(如etcd)。

Q2:如何选择合适的分布式存储系统?

A:需综合考虑以下因素:

- 数据特征:结构化选MySQL Cluster,非结构化选对象存储。

- 访问模式:高频写入选Cassandra,复杂查询选列式数据库。

- 成本预算:开源方案(Ceph)适合初创企业,云服务(AWS S3)降低运维成本。

- 合规要求:金融数据需本地部署,通用