上一篇

分布式海量数据存储

- 行业动态

- 2025-05-07

- 2245

分布式海量数据存储采用分布式架构,通过数据分片、冗余备份及容错机制,保障扩展性与高

分布式海量数据存储:架构、技术与实践

在数字化时代,数据量呈指数级增长,传统集中式存储已无法满足大规模数据处理需求。分布式海量数据存储通过将数据分散存储在多个节点上,结合网络协同与冗余设计,成为解决PB级甚至EB级数据存储的核心方案,本文将从架构设计、核心技术、挑战与优化策略等方面展开分析,并结合实际应用场景提供参考。

核心架构与原理

分布式存储系统的核心目标是通过横向扩展(Scale-Out)实现高性能、高可用和低成本,其架构通常包含以下模块:

| 组件 | 功能描述 |

|---|---|

| 客户端(Client) | 负责数据读写请求的发起,与存储系统交互。 |

| 元数据服务(Metadata Service) | 管理文件命名空间、目录结构、块位置等元信息(如HDFS中的NameNode)。 |

| 数据节点(Data Node) | 实际存储数据块,处理读写操作,并通过副本或纠删码保证数据冗余。 |

| 协调服务(Coordination Service) | 负责集群状态管理、节点心跳检测、负载均衡(如ZooKeeper)。 |

典型架构模式:

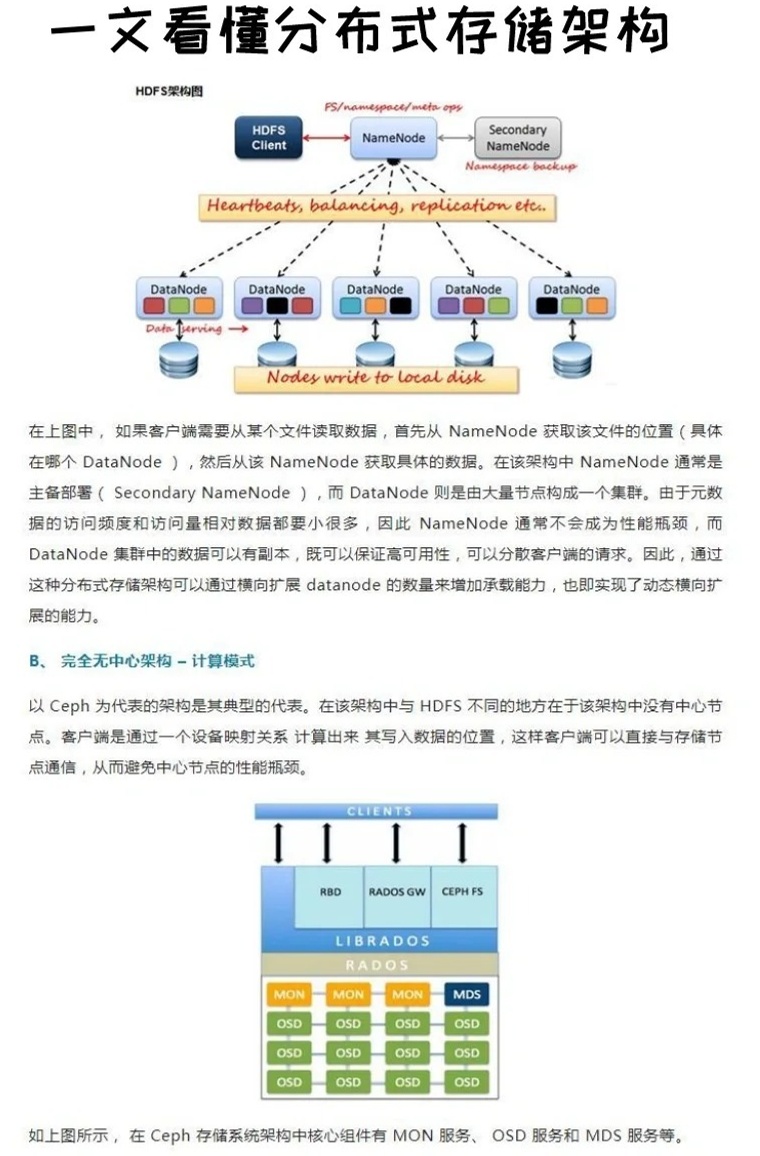

- 主从架构(如HDFS):存在中心化的元数据节点,性能瓶颈明显,但实现简单。

- 无中心化架构(如Ceph、GlusterFS):元数据与数据均匀分布,扩展性强但复杂度高。

- 混合架构(如Google Spanner):结合主从与无中心化特点,支持强一致性与高可用。

关键技术解析

分布式存储的性能与可靠性依赖于多项核心技术的支撑:

数据分片与副本机制

- 分片策略:将大文件拆分为固定大小的数据块(如HDFS默认128MB),分散存储到不同节点。

- 副本策略:通过多副本(如3副本)或纠删码(Erasure Coding)实现容错。

- 副本机制:写入时同步复制数据到多个节点,读取时优先访问最近节点。

- 纠删码(如Reed-Solomon算法):将数据分为k个数据块和m个校验块,可容忍m个节点故障而不丢失数据。

一致性协议

- CAP定理权衡:分布式系统需在一致性(Consistency)、可用性(Availability)、分区容忍性(Partition Tolerance)中取舍。

- 常见协议:

- Paxos/Raft:用于元数据服务的强一致性选举(如Etcd、Consul)。

- 最终一致性:通过版本控制或时间戳解决临时不一致问题(如DynamoDB)。

元数据管理优化

- 分层缓存:将热门元数据缓存到内存(如Redis),减少访问延迟。

- 分片存储:将元数据按目录或哈希分片,避免单点瓶颈(如Ceph的CRUSH算法)。

数据持久化与恢复

- 日志记录:通过Write-Ahead Logging(WAL)确保故障后数据可恢复。

- 快照与备份:定期生成全量快照(如增量备份+全量备份结合)。

挑战与解决方案

尽管分布式存储具备扩展优势,仍需应对以下挑战:

| 挑战 | 解决方案 |

|---|---|

| 节点故障与数据恢复 | 动态副本重建、自动故障转移(如HDFS的Block Replication)。 |

| 网络分区与延迟 | 采用异步复制、优化心跳检测频率(如Netflix的Chaos Monkey测试)。 |

| 存储成本与能效 | 使用纠删码替代多副本、部署冷数据分级存储(如AWS Glacier)。 |

| 性能瓶颈 | 数据预取(Prefetching)、热点数据缓存(如Alluxio加速计算任务)。 |

典型应用场景与案例

- 互联网企业:

- 场景:用户日志、视频流、社交图片存储。

- 案例:Facebook使用Haystack存储百亿级照片;阿里云OSS支持EB级对象存储。

- 大数据分析:

- 场景:离线计算(MapReduce)、实时分析(Flink)。

- 案例:Hadoop生态依赖HDFS实现TB~PB级数据处理。

- 云计算与混合云:

- 场景:跨数据中心容灾、冷热数据分层。

- 案例:Ceph在OpenStack云平台中提供统一存储服务。

未来趋势

- 存算一体化:通过NVMe-oF、RDMA等技术降低存储与计算间的数据传输延迟。

- AI驱动优化:利用机器学习预测数据访问模式,动态调整副本分布。

- 边缘存储:在IoT场景中,将存储能力下沉至边缘节点(如Kubernetes Edge)。

FAQs

Q1:分布式存储与传统集中式存储的核心区别是什么?

A1:分布式存储通过多节点协同实现横向扩展,具备高可用、高吞吐特性,而集中式存储依赖单一设备,扩展性差且存在单点故障风险,传统SAN/NAS难以处理万级节点并发,而Ceph可轻松扩展至数千节点。

Q2:如何根据业务需求选择分布式存储方案?

A2:需综合考虑以下因素:

- 数据规模:GB级可选本地分布式文件系统(如GlusterFS),PB级以上建议使用对象存储(如MinIO)。

- 一致性要求:金融交易类场景需强一致性(如Raft协议),日志类场景可接受最终一致性。

- 成本敏感度:冷数据存储可采用纠删码(如EC 8+4),热数据优先SSD+缓存。