上一篇

分布式数据库的存储

- 行业动态

- 2025-05-07

- 3339

分布式数据库存储通过数据分片与多副本机制实现,采用一致性协议保障数据同步,结合分区策略(如哈希/范围)优化分布,在保证高可用性的同时提升

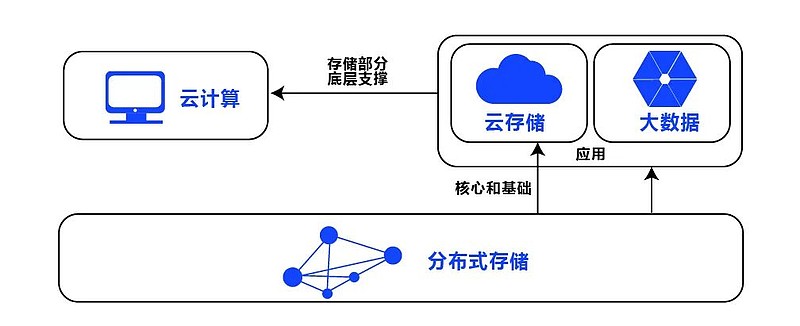

分布式数据库的存储系统是支撑大规模数据管理的核心组件,其设计目标在于平衡数据可用性、一致性、分区容忍性(CAP定理)以及性能优化,以下从存储架构、数据分片策略、副本管理、一致性保障、存储引擎优化等维度展开详细分析。

分布式存储架构的核心特点

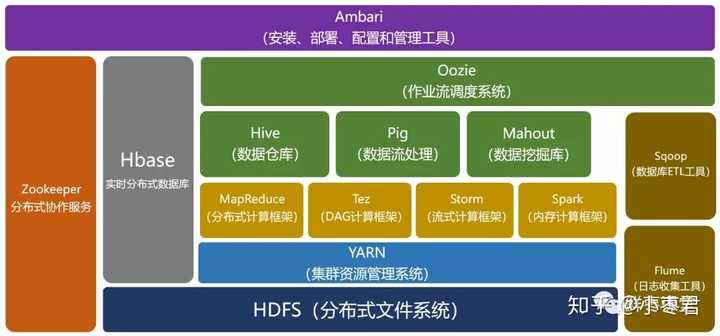

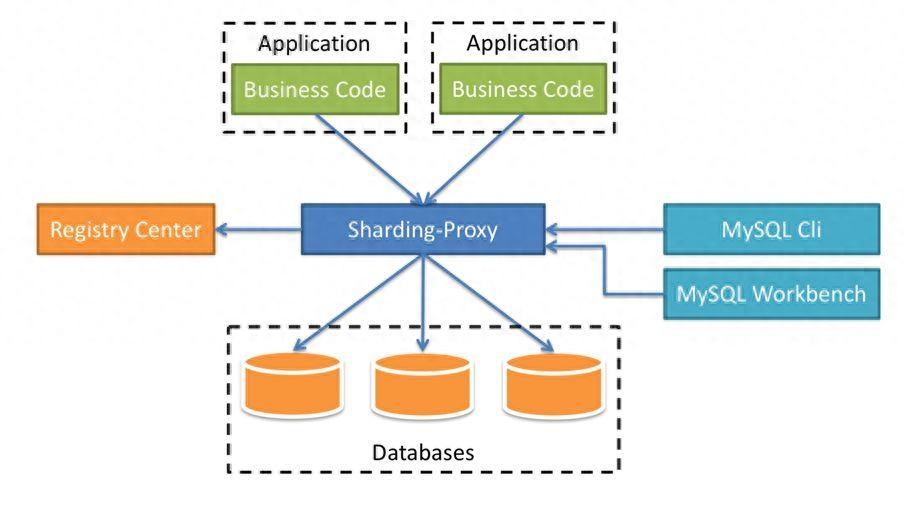

分布式数据库的存储架构通常采用无共享(Shared Nothing)设计,通过横向扩展节点实现容量与性能的线性增长,典型架构包含以下层次:

| 层级 | 功能描述 |

|---|---|

| 客户端层 | 负责接收SQL请求,解析并生成执行计划,协调分布式查询的执行路径。 |

| 路由层 | 根据数据分片规则(如哈希、范围)将请求路由至对应存储节点,支持全局事务管理。 |

| 存储层 | 实际存储数据分片(Shard),管理副本复制、数据压缩、索引构建及持久化操作。 |

| 元数据层 | 维护全局元信息(如分片映射表、节点状态),通常由ZooKeeper或Etcd等工具实现。 |

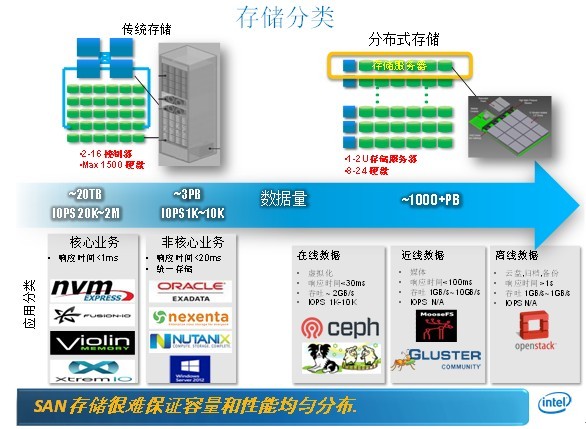

数据分片策略与对比

数据分片(Sharding)是将数据按某种规则分散到不同节点的过程,核心目标是均衡负载并减少单点瓶颈,常见策略如下:

哈希分片(Hash Sharding)

- 原理:对分片键(如用户ID)进行哈希运算,取模后分配至固定分片。

- 优点:数据均匀分布,避免热点问题。

- 缺点:范围查询效率低(需全节点扫描)。

- 适用场景:点查询为主(如用户信息查询)。

范围分片(Range Sharding)

- 原理:按时间、数值范围划分分片(如按日期分片)。

- 优点:支持范围查询,顺序扫描效率高。

- 缺点:易产生数据热点(如最新数据分片访问量大)。

- 适用场景:时间序列数据或连续范围查询。

目录分片(Directory Sharding)

- 原理:通过中央目录服务记录分片键与节点的映射关系。

- 优点:灵活调整分片规则,支持动态扩缩容。

- 缺点:目录服务可能成为性能瓶颈。

- 改进方案:采用分布式目录(如Consistent Hashing)或无目录分片(如DynamoDB)。

分片策略对比表:

| 策略 | 数据分布均匀性 | 范围查询效率 | 热点问题风险 | 动态扩缩容难度 |

|---|---|---|---|---|

| 哈希分片 | 高 | 低 | 低 | 中 |

| 范围分片 | 中 | 高 | 高 | 低 |

| 目录分片 | 可调控 | 依赖目录设计 | 中 | 高 |

副本管理与一致性保障

为提升数据可用性,分布式数据库通常采用多副本存储(如3副本),副本管理需解决以下问题:

强一致性 vs 最终一致性

- 强一致性:通过Paxos/Raft协议确保所有副本数据完全一致,但牺牲可用性(如半数节点故障时不可写)。

- 最终一致性:允许短期数据不一致,通过冲突解决机制(如版本向量)逐步收敛,提升可用性。

副本同步策略

- 同步复制:写操作需等待所有副本确认,延迟高但数据安全(如MySQL Group Replication)。

- 异步复制:主节点确认后即返回,副本异步同步,存在数据丢失风险(如MongoDB默认模式)。

- 半同步复制:折衷方案,需多数副本确认(如Quorum机制)。

CAP定理的权衡

- CP模式(如HBase):优先一致性和分区容忍性,牺牲可用性(网络分区时拒绝写操作)。

- AP模式(如Cassandra):优先可用性和分区容忍性,允许临时不一致。

- GAP替代方案:通过多活数据中心和冲突解决机制(如DynamoDB的Eventually Consistent Read)绕过CAP限制。

存储引擎优化技术

分布式数据库的存储引擎需解决高并发、大吞吐量下的性能瓶颈,常见优化技术包括:

LSM树(Log-Structured Merge Tree)

- 原理:将写操作缓存在内存(MemTable),定期刷盘并合并(Compaction)到磁盘。

- 优势:减少随机写IO,适合高频写入场景(如日志型数据库)。

- 代价:Compaction操作可能导致读放大(Read Amplification)。

混合存储引擎

- 行存+列存:行式存储支持OLTP点查询,列式存储压缩适合OLAP分析(如Google Spanner)。

- 分层存储:热数据用SSD加速,冷数据转HDD或对象存储(如Amazon DynamoDB的DAX缓存)。

索引与压缩优化

- 二级索引:通过冗余索引加速非主键查询(如Cassandra的Materialized Views)。

- 数据压缩:采用列式压缩(如LZ4)、前缀压缩(如Prometheus的TSDB)减少存储空间。

- Bloom Filter:快速判断Key是否存在,减少磁盘IO(如RocksDB的Block Bloom Filter)。

典型分布式数据库存储实现对比

| 数据库 | 存储模型 | 分片方式 | 副本协议 | 优化技术 |

|---|---|---|---|---|

| HBase | 列存(HFile) | 预分区哈希分片 | HDFS块副本 | LSM树、Bloom Filter、BlockCache |

| Cassandra | 宽列(SSTable) | 一致性哈希分片 | Paxos/Gossip | Hinted Handoff、Compaction策略 |

| TiDB | 行存+列存 | Range/Hash分片 | Raft协议 | Codis(Redis集群)、自动均衡 |

| Amazon DynamoDB | KV+二级索引 | 隐式哈希分片 | Quorum NRW | On-Demand Backup、DAX缓存 |

FAQs

Q1: 如何选择合适的数据分片策略?

A1: 需结合业务访问模式:

- 若以点查询为主(如用户画像),优先哈希分片;

- 若需频繁范围查询(如订单时间筛选),选择范围分片;

- 若业务复杂且需动态调整,可采用混合分片或无目录分片(如DynamoDB的去中心化设计)。

Q2: 节点故障时如何保证数据不丢失?

A2: 通过多副本+共识协议实现:

- 副本数量≥3,多数派协议(Quorum)确保数据可恢复;

- 使用Raft/Paxos协议同步副本状态;

- 故障检测后触发自动Failover,新主节点通过日志