上一篇

分布式数据的存储与管理

- 行业动态

- 2025-05-06

- 1

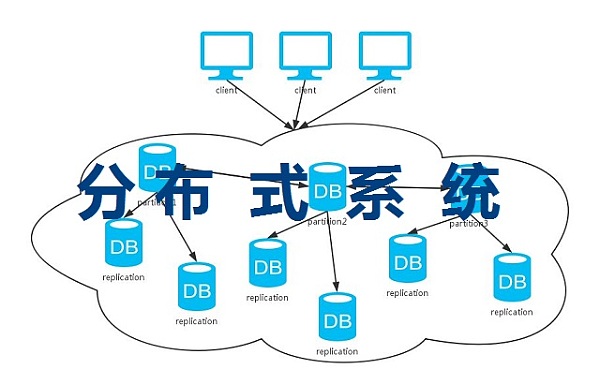

分布式数据存储与管理通过数据分片、冗余备份保障可用性,依赖一致性协议协调节点,分布式文件系统高效管理,平衡性能、容错与

分布式数据的存储与管理

分布式数据存储的核心概念

分布式数据存储是将数据分散存储在多个物理节点上,通过协同工作实现数据的高效访问与管理,其核心目标包括:扩展性(支持海量数据)、高可用性(容忍节点故障)、性能优化(低延迟与高吞吐量)以及数据一致性(保证数据正确性),与传统集中式存储相比,分布式存储通过冗余、分片和负载均衡等技术解决单点瓶颈问题。

分布式存储的核心问题与挑战

分布式系统需在以下关键维度中权衡取舍:

| 核心问题 | 描述 | 典型矛盾 |

|---|---|---|

| CAP定理 | 无法同时满足一致性(Consistency)、可用性(Availability)、分区容错性(Partition Tolerance)。 | 网络分区时需选择CP或AP模式 |

| 数据分片 | 如何将数据划分为可管理的块并分配到不同节点。 | 分片策略影响负载均衡与查询效率 |

| 数据复制 | 通过多副本提升可靠性,但需平衡存储成本与一致性。 | 强一致性 vs. 最终一致性 |

| 故障恢复 | 节点故障时快速恢复服务,避免数据丢失。 | 自动修复与人工干预的平衡 |

| 动态扩展 | 支持节点增减而不影响业务,需处理数据迁移与负载重新分配。 | 扩展时的数据均衡与一致性保障 |

CAP定理的实际应用

- CP模式(如Redis Cluster):优先保证数据一致性,适用于金融、订单等强一致性场景。

- AP模式(如Cassandra):允许临时不一致,适用于社交、日志等高可用需求场景。

- P属性:分布式系统必须处理网络分区问题,因此需在C与A之间抉择。

分布式存储的关键技术

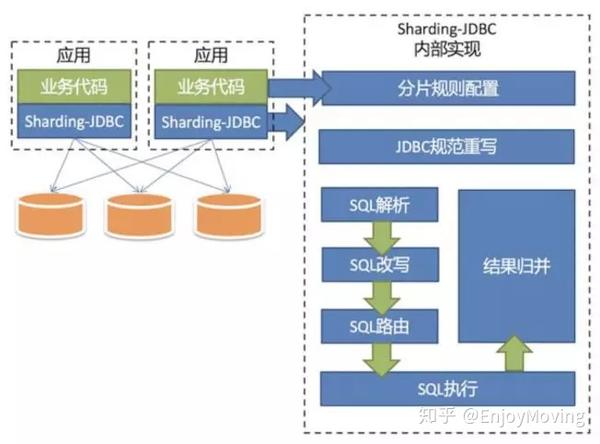

数据分片(Sharding)

- 哈希分片:按Key的哈希值均匀分布到节点,适合无序数据(如用户Session)。

- 范围分片:按时间、ID范围划分,适合时间序列数据(如日志)。

- 混合分片:结合哈希与范围,用于复杂查询场景。

- 虚拟分片:通过逻辑分片映射到物理节点,简化扩展时的迁移。

数据复制与一致性协议

- 复制策略:

| 策略 | 特点 | 适用场景 |

|—————-|—————————————|————————–|

| 主从复制 | 主节点负责写,从节点同步读 | 读多写少的场景(如缓存) |

| 多主复制 | 多个节点可写入,通过冲突解决保证一致 | 高并发写入(如社交网络) |

| 链式复制 | 数据按顺序传递至后续节点 | 弱网环境(如物联网) | - 一致性协议:

- Paxos/Raft:通过投票机制保证日志一致性,用于分布式事务(如数据库)。

- Gossip:概率传播协议,适用于大规模节点间的状态同步(如Cassandra)。

- Quorum NWR:通过读写多数派实现最终一致性(如DynamoDB)。

- 复制策略:

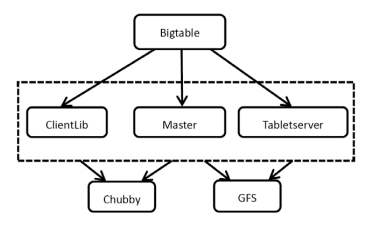

元数据管理

- 集中式元数据(如HDFS NameNode):单一节点管理文件元数据,风险高但实现简单。

- 分布式元数据(如Ceph):通过CRUSH算法将元数据分散存储,提升容错性。

- 元数据缓存:客户端本地缓存元数据,减少对元数据服务的依赖。

典型分布式存储架构对比

| 系统类型 | 代表产品 | 数据模型 | 一致性保障 | 适用场景 |

|---|---|---|---|---|

| NoSQL数据库 | Cassandra、MongoDB | 键值/文档/列族 | 最终一致性(Tunable Consistency) | 互联网应用、实时分析 |

| NewSQL数据库 | CockroachDB、TiDB | SQL结构化数据 | 线性化一致性(Raft) | 金融、企业级事务 |

| 分布式文件系统 | HDFS、Ceph、GlusterFS | 文件/块存储 | 强一致性(依赖中心节点) | 大数据分析、云存储 |

| 对象存储 | Amazon S3、MinIO | 扁平化键值(对象) | 事件一致性(版本控制) | 备份、静态资源托管 |

案例:Cassandra vs. CockroachDB

- Cassandra:采用LSM树+Memtable优化写性能,支持跨数据中心部署,适合全球分布式应用。

- CockroachDB:基于Raft协议实现多副本强一致,支持SQL与事务,适用于传统企业迁移。

分布式数据管理的关键问题

数据迁移与扩容

- 问题:新增/移除节点时需重新分片,可能导致服务中断。

- 解决方案:

- 增量迁移:通过双写或代理逐步迁移数据。

- 一致性哈希:减少扩容时的数据重分配量。

- 热迁移工具:如Kubernetes的StatefulSet实现无中断扩缩容。

数据监控与运维

- 监控指标:

- 节点健康状态(CPU、内存、磁盘IO)

- 数据分布均匀性(Skew检测)

- 延迟与吞吐量(P99/P95分位值)

- 工具链:Prometheus+Grafana监控+ELK日志分析+Alertmanager告警。

- 监控指标:

数据安全与隐私

- 加密:传输层TLS+存储层AES-256,密钥管理依赖KMS(Key Management Service)。

- 访问控制:基于角色的权限模型(RBAC),细粒度策略(如IP白名单)。

- 审计合规:记录数据操作日志,满足GDPR、HIPAA等法规要求。

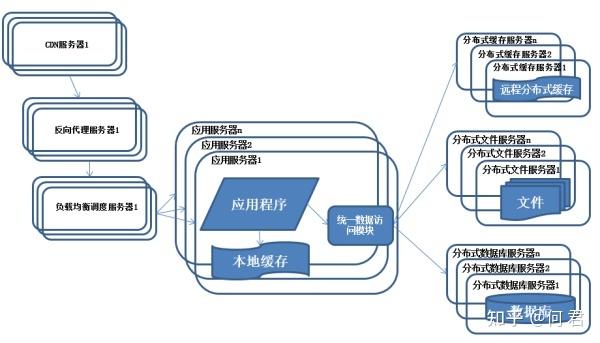

分布式存储的应用场景

| 场景 | 需求特点 | 技术选型建议 |

|---|---|---|

| 互联网大流量 | 高并发读写、低延迟 | NoSQL(如Redis+MySQL)、分片数据库 |

| 金融交易系统 | 强一致性、事务支持 | NewSQL(如TiDB)、传统分布式事务数据库 |

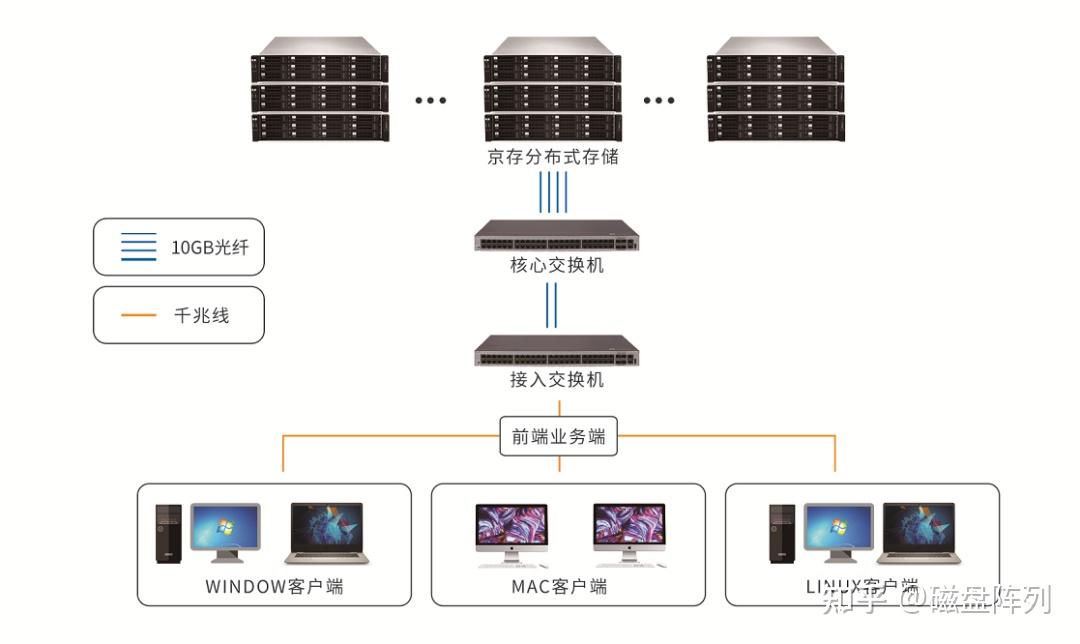

| 大数据分析 | 批量处理、高吞吐 | Hadoop HDFS+Spark、Ceph+Presto |

| 边缘计算 | 低带宽、地理分散 | P2P同步(如IPFS)、轻量级数据库(如SQLite) |

未来趋势与挑战

- AI与存储融合:通过机器学习预测数据访问模式,优化分片与缓存策略。

- Serverless存储:按需自动扩缩容,降低运维复杂度(如Faust、Azure Blob Storage)。

- 隐私增强技术:联邦学习、多方安全计算(MPC)解决数据孤岛问题。

- 新型硬件适配:针对NVMe、Optane等高速存储设备优化数据布局算法。

FAQs

Q1:如何在CAP定理中选择合适的策略?

A1:根据业务需求优先级决定:

- 强一致性场景(如支付):选择CP模式,牺牲部分可用性(如ZooKeeper)。

- 高可用场景(如社交媒体):选择AP模式,允许短期数据不一致(如Cassandra)。

- 混合策略:通过分区设计,核心业务采用CP,非核心采用AP(如Google Spanner)。

Q2:数据分片与复制如何影响查询性能?

A2:

- 分片影响:

- 哈希分片可能导致范围查询需扫描多个节点(如时间范围查询)。

- 范围分片可优化顺序扫描,但易导致负载不均。

- 复制影响:

- 读操作可通过就近读取副本提升性能(如DNS负载均衡)。

- 写操作需同步多个副本,增加延迟(如Quorum Write策略)。

优化方案:结合二级索引(如Elasticsearch)或预计算聚合(如Materialized Views