上一篇

分布式数据库 分布

- 行业动态

- 2025-05-07

- 2737

分布式数据库通过 数据分片与多节点存储实现分布,提升可用性与扩展性,平衡性能与

分布式数据库分布机制详解

分布式数据库的核心目标是通过数据分布实现高性能、高可用和横向扩展,其分布策略直接影响系统性能、容错能力和维护成本,以下从数据分布、节点分布、负载均衡、一致性保障等维度展开分析。

数据分布策略

数据分布是分布式数据库的基石,常见策略包括:

| 策略类型 | 核心思想 | 适用场景 |

|---|---|---|

| 水平分片(Sharding) | 按数据逻辑(如用户ID、时间范围)将表拆分为多个子集,分散存储到不同节点 | 海量数据且访问粒度较细的场景(如电商订单、社交日志) |

| 垂直分片(Vertical Partitioning) | 按列拆分表,不同列存储到不同节点(如用户基本信息与交易记录分离) | 单表字段过多且热点字段访问频繁的场景(如用户画像系统) |

| 哈希分片 | 通过哈希函数(如HASH(user_id) % 分片数)均匀分配数据到节点 | 数据分布均匀且无明确范围查询需求的场景(如UID随机的社交平台) |

| 范围分片 | 按时间、地理位置等连续范围划分数据(如ORDER_DATE按月份分片) | 需要按范围查询的场景(如电商订单按月统计) |

| 混合分片 | 结合哈希与范围分片(如先按时间分片,再对每个时间段内的数据哈希分片) | 复杂查询与动态扩展并存的场景(如日志分析系统) |

示例:

- 电商订单系统:采用范围分片(按月份)+ 哈希分片(按用户ID),既支持按月统计,又避免单节点数据过热。

- 社交网络:纯哈希分片(按用户UID),确保数据均匀分布,但范围查询(如“近7天动态”)需跨分片扫描。

节点分布与部署

节点分布需平衡地理距离、网络延迟和容灾需求,常见模式包括:

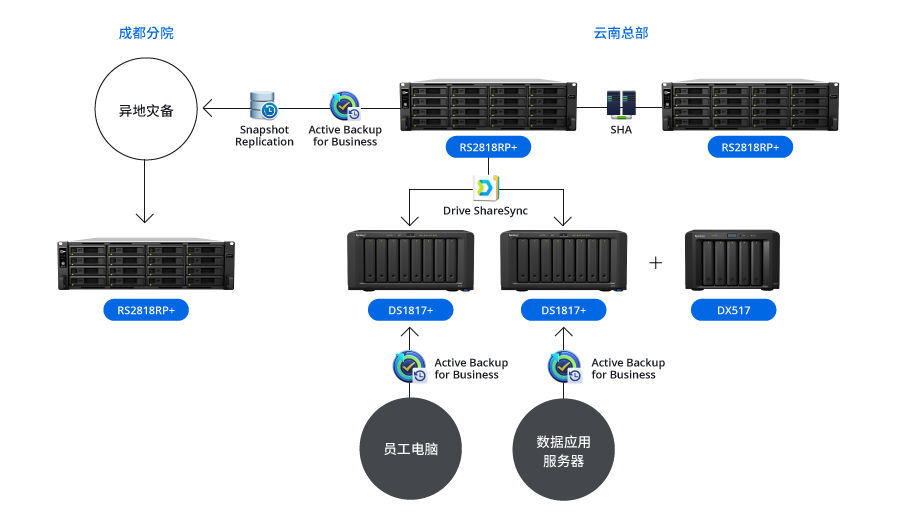

地理分布

- 多数据中心部署:将节点部署在不同地域(如北京、上海、深圳),通过DNS解析或全局负载均衡(如GSLB)实现就近访问。

- 优势:降低延迟、规避区域性故障(如地震、光纤中断)。

- 挑战:跨中心数据同步延迟(如中美两地延时300ms以上)。

数据中心内部署

- 机架感知布局:将高频交互的节点部署在同一机架,减少网络跳数。

- 冷热数据分离:高频访问数据(热数据)部署在SSD节点,冷数据存储在HDD节点。

多活架构

- 同城双活:两个数据中心同时提供读写服务,通过Paxos协议保证数据一致。

- 异地灾备:异步复制数据到异地,仅用于故障恢复,不参与日常读写。

负载均衡机制

负载均衡的目标是避免热点节点,常见策略分为两类:

| 策略类型 | 实现方式 | 优缺点 |

|---|---|---|

| 静态负载均衡 | 预设分片规则(如哈希、范围),数据固定分配至节点 | 简单高效,但无法应对动态流量变化(如突发热点事件) |

| 动态负载均衡 | 实时监控节点负载(CPU、IO、网络),通过路由规则或数据迁移调整分布 | 灵活但复杂度高,需平衡迁移成本与收益(如Redis Cluster) |

典型算法:

- 轮询法:按顺序分配请求,适合负载均衡的读操作。

- 一致性哈希:将节点映射到哈希环,数据根据哈希值顺时针分配至最近节点,减少节点变动时的数据迁移量。

- 权重分配:根据节点性能(如内存大小)设置权重,高性能节点分配更多数据。

数据一致性保障

分布式环境下,一致性与可用性遵循CAP定理,需根据业务选择策略:

强一致性

- 实现方式:2PC(两阶段提交)、Paxos/Raft协议、主从同步复制。

- 代价:性能损耗(如MySQL主从同步可能导致写延迟增加)、可用性降低(如半数节点故障时无法写入)。

- 适用场景:金融交易、订单系统等对数据准确性要求极高的场景。

最终一致性

- 实现方式:异步复制、冲突解决(如版本向量)、事务补偿机制。

- 代价:短时间数据不一致(如电商库存更新后可能存在1秒误差)。

- 适用场景:社交媒体、日志系统等容忍短暂不一致的场景。

典型案例:

- 支付宝交易:采用Paxos协议保证强一致性,任何节点故障均不影响已提交事务。

- 微博点赞:允许1秒内数据不一致,通过异步复制提升性能。

容错与高可用设计

副本策略

- 主从复制:一主多从,主节点负责写操作,从节点处理读请求(如MongoDB)。

- 多主复制:所有节点均可读写,通过冲突解决协议(如Quorum NWR)保证一致性(如Cassandra)。

故障检测与恢复

- 心跳机制:节点定期发送心跳包,超时则标记为故障。

- 自动切换:故障节点任务迁移至备用节点(如Kubernetes容器编排)。

数据修复

- 副本重建:故障节点恢复后,通过增量日志同步数据。

- 纠删码(Erasure Coding):将数据编码为多个块,允许部分块丢失后重建(如Ceph存储)。

全局事务处理

分布式事务需解决“分布式锁”与“事务原子性”问题:

两阶段提交(2PC)

- 流程:准备阶段(锁定资源)→ 提交阶段(全部成功则提交,否则回滚)。

- 缺点:阻塞时间长,不适合高并发场景。

TCC(Try-Confirm-Cancel)

- 流程:预占资源(Try)→ 确认执行(Confirm)→ 失败回滚(Cancel)。

- 适用:长事务场景(如电商下单后扣库存、生成订单、支付)。

补偿机制

- 思路:事务失败后记录补偿日志,异步重试直至成功。

- 案例:银行转账失败后,系统自动重试3次。

应用场景与挑战

典型场景:

- 电商大促:分库分表(水平分片)+ 读写分离应对高并发。

- 金融风控:强一致性协议(如Raft)保障交易可靠性。

- 物联网(IoT):边缘节点预处理数据,中心节点聚合分析。

核心挑战:

- 扩展性瓶颈:分片规则变更成本高(如从哈希分片改为范围分片需数据重构)。

- 延迟与一致性权衡:跨节点事务可能因网络延迟导致超时。

- 运维复杂度:需监控数百个节点的磁盘、内存、网络状态。

FAQs

Q1:如何选择合适的数据分片策略?

- 答:根据业务访问模式决定:

- 范围查询多:优先范围分片(如订单按时间分片)。

- 写密集且无范围查询:哈希分片更均匀。

- 混合场景:组合分片(如先按时间分片,再哈希分片)。

Q2:分布式数据库如何保障强一致性?

- 答:通过以下技术:

- 共识协议:如Raft或Paxos,确保多数节点同意后才提交事务。

- 同步复制:写操作需等待副本节点确认(如MySQL主从同步)。

- 全局时钟:使用逻辑时钟(如Lamport Clock)或物理时钟同步机制