分布式数据仓库实践

- 行业动态

- 2025-05-08

- 2139

分布式数据仓库实践核心要点解析

分布式数据仓库架构设计

分层架构模型

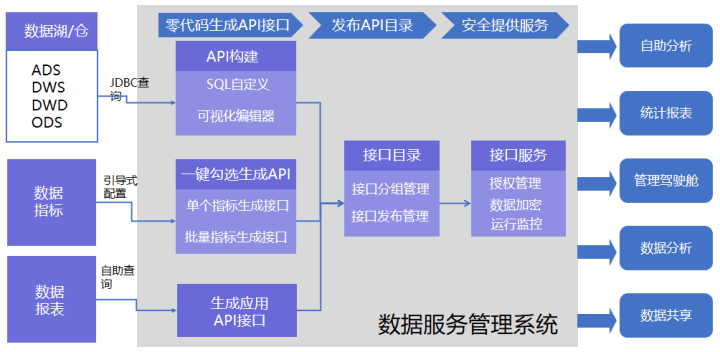

- 源数据层:整合多源异构数据(数据库/日志/文件)

- ODS层:操作数据存储,保留原始数据特征

- DWD层:细节数据层,完成数据清洗/标准化

- DWS层:轻度聚合层,构建宽表/主题域

- ADS层:应用数据层,支持BI/AI需求

技术选型对比

| 组件类型 | 主流方案 | 适用场景 | 关键特性 |

|—————-|————————-|—————————–|————————–|

| 存储引擎 | HDFS + Iceberg | PB级离线存储 | ACID事务/时间旅行 |

| 消息队列 | Kafka + Pulsar | 实时数据管道 | 高吞吐/持久化 |

| 计算引擎 | Spark + Flink | 批处理/流处理 | 内存计算/状态管理 |

| 元数据管理 | Apache Atlas | 全链路血缘追踪 | 数据资产目录 |

| 调度系统 | Apache Airflow | 复杂工作流编排 | 可视化DAG/监控告警 |存储计算分离实践

- 采用存算分离架构(如AWS Redshift Spectrum)

- 计算节点动态扩展:通过Kubernetes管理Spark集群

- 存储层弹性扩容:对象存储自动分层(热/温/冷数据)

- 典型配置:计算节点与存储节点比例1:5

数据集成与治理

多源数据同步方案

- CDC技术:Debezium捕获MySQL变更,实时写入Kafka

- 批量导入:Sqoop+Flume处理传统数据库增量数据

- 日志采集:Filebeat+Logstash处理服务器日志

- 数据校验:Great Expectations框架实现质量检查

元数据管理体系

- 构建三级元数据目录:

- 基础层:表结构/字段类型/分区信息

- 业务层:指标口径/计算逻辑/血缘关系

- 应用层:报表/API接口文档

- 实施数据血缘追踪:

- 使用Atlas记录Spark作业依赖关系

- 通过OpenLineage标准化血缘格式

- 构建三级元数据目录:

数据质量监控机制

建立质量维度:

| 维度 | 检测指标 | 处理方式 |

|————|——————————|———————————|

| 完整性 | 空值比例/主键缺失 | 自动填充/数据补录 |

| 一致性 | 跨源数据比对/维度冲突 | 异常告警/人工复核 |

| 时效性 | 数据延迟/处理周期 | 优先级调度/资源倾斜 |

| 准确性 | 业务规则校验/统计指标验证 | 数据订正/流程优化 |

性能优化策略

存储层优化

- 数据分区策略:

- 时间分区:按天/小时建立目录结构

- 哈希分区:基于业务标识取模分配

- 复合分区:时间+业务类型二级分区

- 列式存储优化:

- Parquet格式压缩比提升30%

- Z-Order排序减少Range查询IO

- BloomFilter加速不存在数据过滤

- 数据分区策略:

计算引擎调优

- Spark配置优化:

| 参数 | 建议值 | 作用 |

|———————|—————–|——————————-|

| spark.sql.shuffle.partitions | 200-500 | 平衡并行度与任务粒度 |

| spark.dynamicAllocation.enabled | true | 自动资源伸缩 |

| spark.memory.fraction | 0.6 | 堆外内存占比优化 | - 执行计划优化:

- Broadcast Hint处理小表关联

- Window函数转换为MapGroups

- 谓词下推减少数据扫描量

- Spark配置优化:

查询加速方案

- 物化视图策略:

- 预计算TOP100报表数据

- 构建中间结果缓存表

- 索引优化:

- Z序索引加速范围查询

- Bitmap索引处理低基数字段

- 冷热数据分离:

- 热数据:SSD存储+LRU缓存策略

- 冷数据:HDD存储+异步加载机制

- 物化视图策略:

典型应用场景实践

电商数仓建设案例

- 数据规模:日均处理10TB交易数据+20TB日志

- 核心模型:

- 用户行为宽表:整合浏览/点击/加购事件

- 商品主题域:SKU属性+价格历史+库存快照

- GMV分析立方体:时间+地域+品类多维模型

- 优化成果:

| 指标 | 优化前 | 优化后 | 提升幅度 |

|—————-|———–|———–|———-|

| ETL耗时 | 4小时 | 1.5小时 | 62.5% |

| 查询响应 | 30秒 | 5秒 | 83% |

| 存储成本 | $12k/月 | $8k/月 | 33% |

实时数仓实现路径

- 架构演进:

- 阶段1:Kafka+Spark Streaming处理实时流

- 阶段2:Flink SQL实现流批一体处理

- 阶段3:Iceberg事务表支持实时+离线融合

- 关键技术:

- 水位线管理:允许迟到数据处理窗口

- 状态后端:RocksDB持久化状态数据

- 精确一次:Checkpoint+二阶段提交

- 架构演进:

常见问题与解决方案

FAQs

问:如何保证分布式环境下的数据一致性?

- 答:采用以下组合方案:

- 使用Iceberg/Hudi支持ACID事务

- 流处理引擎配置Exactly Once语义(Flink Checkpoint)

- 跨分区数据校验:通过MD5校验和+对账机制

- 最终一致性保障:定期执行全量稽核任务

- 答:采用以下组合方案:

问:如何优化数仓建设成本?

答:实施分层成本控制策略:

| 层级 | 优化措施 |

|————|————————————————————————–|

| 存储层 | 启用对象存储生命周期策略,自动转换存储级别;压缩格式采用Snappy+ZSTD混合 |

| 计算层 | 闲时利用Spot实例;设置自动缩容策略 |

| 网络层 | 跨可用区部署使用内网传输;开启智能路由优化 |

| 管理层面 | 建立资源配额制度;实施任务优先级队列