上一篇

光年日志分析工

- 行业动态

- 2025-04-23

- 2029

光年日志分析工是一款高效日志处理工具,支持多格式解析、实时监控与智能告警,可快速定位异常并生成可视化数据报表,助力运维人员精准排查问题、优化系统性能

- 日志采集:负责从各类系统(如服务器、网络设备、应用程序)中收集日志数据,确保数据的完整性与准确性。

- 日志清洗:过滤无效日志(如错误格式、重复数据),提取关键字段(时间戳、IP地址、事件类型等)。

- 数据分析:通过统计、聚类、关联规则等方法,挖掘日志中的异常模式、性能瓶颈或安全威胁。

- 可视化报告:将分析结果转化为图表或仪表盘,供运维、开发或安全团队决策参考。

- 问题定位:协助排查故障根因,例如通过日志追溯故障发生的时间点和操作路径。

核心技能要求

| 技能类别 | 具体要求 |

|---|---|

| 数据分析能力 | 熟悉SQL、Python(Pandas/NumPy)、ELK Stack(Elasticsearch/Logstash/Kibana) |

| 系统知识 | 理解Linux/Windows系统日志、网络协议(HTTP/TCP/UDP)、云平台(AWS/Azure)日志 |

| 编程能力 | 能编写脚本自动化处理日志(如Logstash配置文件、Python日志解析工具) |

| 安全意识 | 识别反面行为日志(如暴力破解、破绽利用),熟悉常见攻击特征库 |

典型工作流程

日志采集与聚合

- 使用Filebeat/Fluentd等工具收集分散的日志文件。

- 通过Logstash或Kafka将日志统一传输至中央存储(如Elasticsearch)。

数据清洗与标准化

- 去除冗余字段(如调试日志)。

- 将不同格式的日志(JSON/Syslog/文本)转换为统一结构。

分析与告警

- 设置阈值告警(如错误率超过5%触发通知)。

- 利用机器学习模型检测异常(如流量突增、登录地点异常)。

问题复盘与优化

- 结合日志与监控数据(如CPU/内存使用率)复现故障场景。

- 提出改进建议(如升级软件版本、调整防火墙规则)。

常用工具与技术

| 工具类型 | 代表工具 | 适用场景 |

|---|---|---|

| 日志管理平台 | ELK Stack、Splunk、Graylog | 大规模日志集中存储与查询 |

| 实时计算框架 | Flink、Spark Streaming | 处理高频实时日志(如交易系统) |

| 可视化工具 | Kibana、Grafana | 生成动态仪表盘(如展示每分钟错误请求数) |

| 安全分析工具 | Wazuh、OSSEC | 检测载入行为或合规性审计 |

挑战与应对策略

数据量过大

- 问题:单日日志量可达TB级,传统工具处理缓慢。

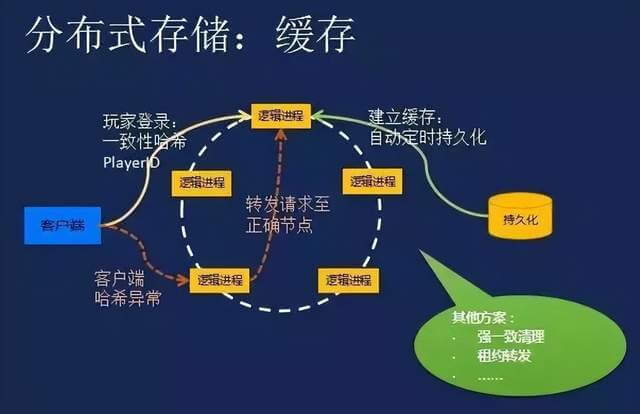

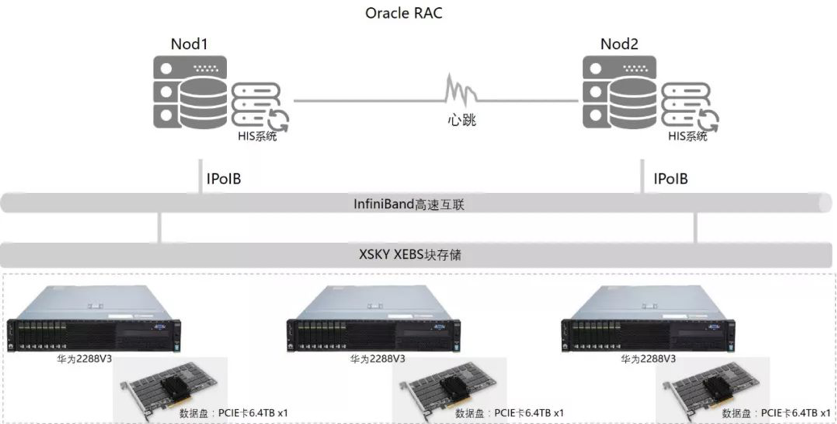

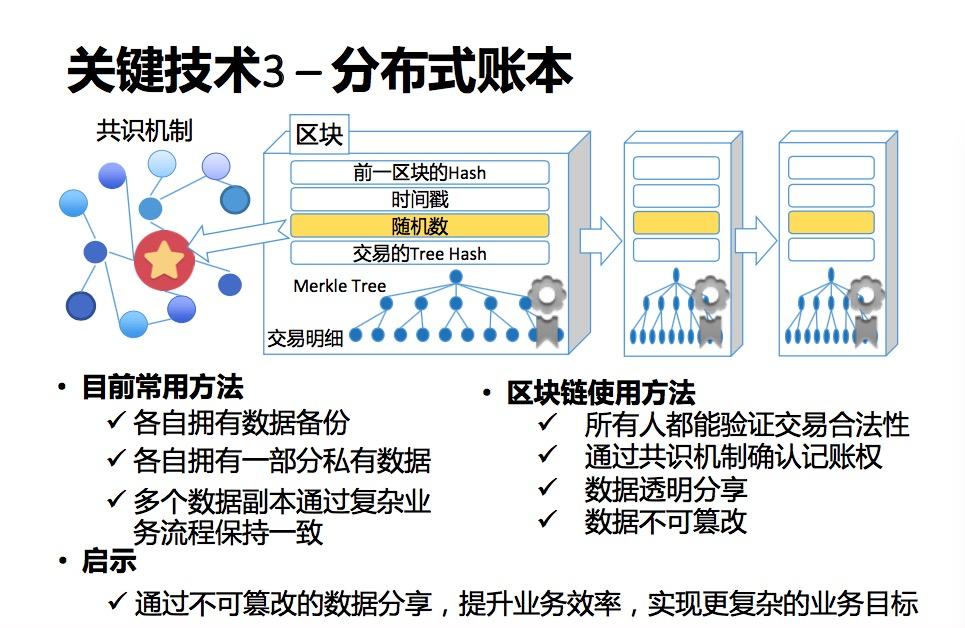

- 解决方案:采用分布式存储(如HDFS)+ 并行计算框架(如Spark)。

日志格式混乱

- 问题:不同系统日志格式差异大,难以统一分析。

- 解决方案:制定企业内部日志规范(如JSON标准化模板)。

实时性要求高

- 问题:故障需在秒级内响应。

- 解决方案:部署边缘计算节点(如EdgeNT)预处理日志。

相关问题与解答

问题1:如何区分正常日志和异常日志?

解答:

- 统计法:计算正常行为的基线值(如每小时请求量均值),超出阈值则标记为异常。

- 规则法:定义特定规则(如连续3次登录失败即视为暴力破解)。

- 机器学习法:训练模型(如Isolation Forest)自动识别偏离常态的模式。

问题2:日志分析如何帮助提升系统性能?

解答:

- 瓶颈定位:通过分析慢查询日志,发现数据库索引缺失问题。

- 资源优化:根据CPU/内存使用日志,调整服务器负载均衡策略。

- 缓存策略:分析频繁访问的静态资源日志,针对性启用CDN