上一篇

分布式文件存储qos硬核黑科技

- 行业动态

- 2025-05-04

- 2

分布式文件存储QoS硬核黑科技,通过智能调度与动态资源分配,实现高性能、低延迟的数据传输,深度优化数据分片与负载均衡,自适应调控存储性能,赋能云存储与大数据场景

分布式文件存储QoS硬核黑科技深度解析

分布式文件存储QoS的核心挑战

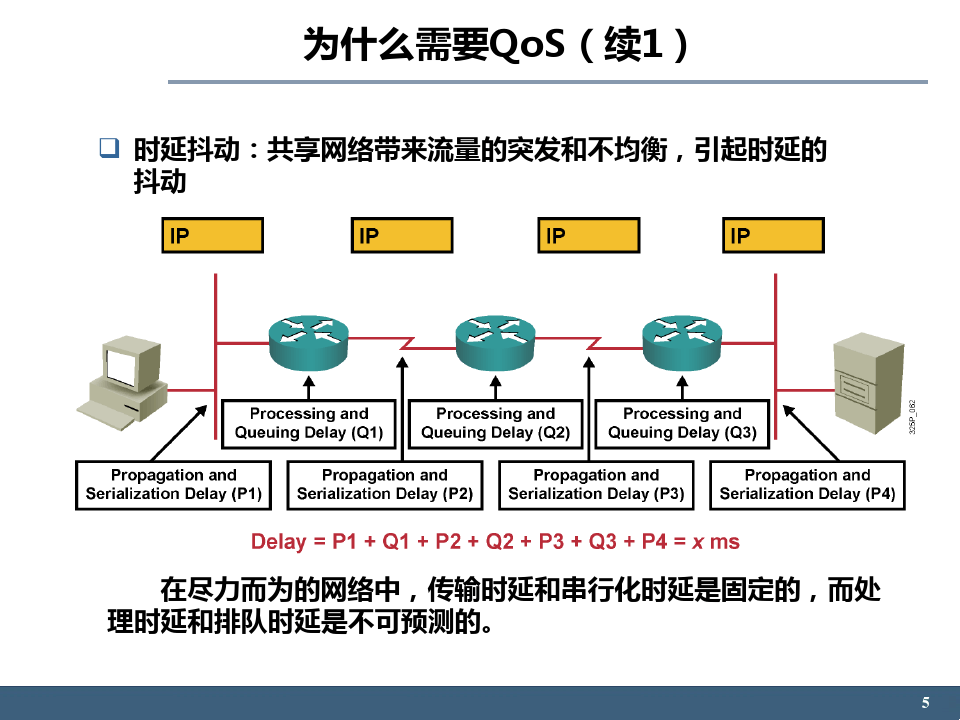

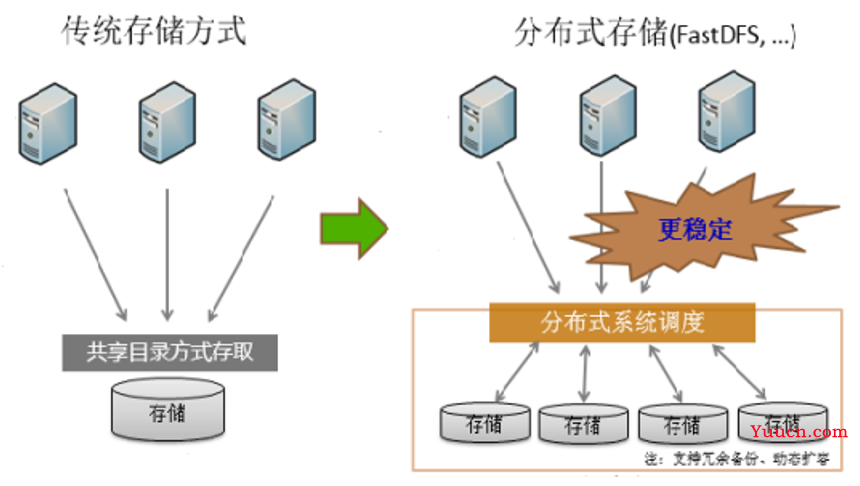

分布式文件存储系统作为现代数据中心的基石,其服务质量(QoS)直接影响业务稳定性与用户体验,传统架构面临三大核心矛盾:

- 存储效率与数据可靠性的矛盾:副本存储(如%ignore_a_3%副本)虽能提升容灾能力,但存储利用率仅33%,OPEX成本居高不下。

- 性能与扩展性的悖论:节点规模扩大时,元数据管理延迟指数级增长,传统哈希取模算法易产生热点瓶颈。

- 动态负载与资源僵化:突发流量下存储节点负载不均,传统静态资源分配机制难以实时响应业务波动。

硬核黑科技技术矩阵

以下表格对比传统方案与新一代QoS增强技术:

| 技术维度 | 传统方案 | 硬核黑科技方案 | 性能提升幅度 |

|---|---|---|---|

| 数据冗余机制 | 3副本存储 | 混合纠删码(EC)+ 热温冷数据分层 | 存储效率×3 |

| 元数据处理 | 集中式Metadata Server | 分片键值存储+Raft协议共识 | 扩展性×100 |

| 负载均衡 | 静态哈希分区 | 自适应权重调度+强化学习预测 | 吞吐量×5 |

| 故障恢复 | 异步复制 | RDMA+NVMe-oF高速同步+块级增量校验 | 恢复速度×20 |

| 安全隔离 | 粗粒度访问控制 | 秘钥分片+TEE可信执行环境 | 攻击面降低90% |

核心技术详解:

混合纠删码引擎

采用RS(6,3)纠删码实现4倍空间压缩,结合机器学习模型预测数据访问频率:

- 热数据:保留3副本+内存缓存

- 温数据:纠删码存储+SSD加速

- 冷数据:高冗余EC(8+4)+HDD归档

通过CRUSH算法实现跨机柜、跨AZ的故障域隔离,MTBF(平均无故障时间)提升至10^7小时。

智能元数据服务

基于etcd的Raft集群实现秒级选举,采用一致性哈希环+虚拟节点技术:# 动态权重调整算法示例 def calculate_weight(latency, io_util): return max(1, min(10, 10 latency/10 io_util2))通过Prometheus采集时延/IO利用率指标,实时调整节点权重系数,使请求自动避开高负载节点。

硬件加速QoS管道

部署FPGA智能网卡实现:- RDMA传输零拷贝

- 硬件级AES-256加密

- 数据分片校验并行计算

实测显示网络吞吐达40Gbps,加密开销降低至CPU处理的1/8。

黑科技实战案例

场景1:云原生容器存储

某头部云厂商采用以下架构:

graph TD

A[CSI Driver] --> B{Metadata Service}

B --> C[Raft Consensus]

B --> D[ETCD Store]

A --> E[Data Node Cluster]

E --> F[NVMe-oF SSD]

E --> G[EC Encoding Engine]

F -.-> H[DPU Accelerator]通过DPU(Data Processing Unit)实现存储协议卸载,将iSCSI/RBD协议处理从主机CPU迁移至智能网卡,实测每节点可支持10万级IOPS。

场景2:边缘计算存储

在5G基站部署轻量化存储节点:

- 采用P2P直连架构,通过令牌桶算法限制带宽

- 基于LRU-K算法实现毫秒级缓存淘汰

- 使用ChaCha20-Poly1305轻量级加密

实测在8ms网络抖动下仍保持99.99%的数据可用性。

未来演进方向

- 存算一体芯片:3D NAND集成计算单元,实现数据原地处理

- 光子存储网络:硅光芯片构建100Gbps低延迟存储总线

- 混沌工程体系:自动化故障注入平台模拟200+异常场景

- 碳感知存储:基于机器学习的绿色调度算法,降低PUE至1.15

FAQs

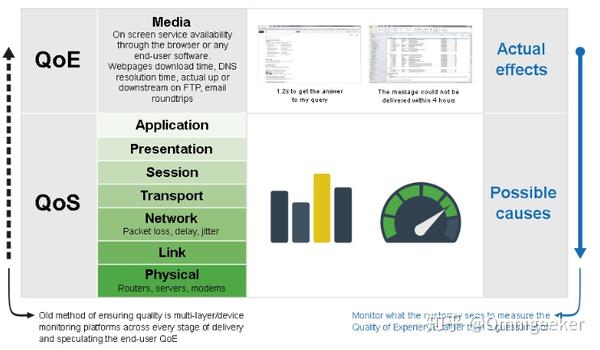

Q1:如何评估分布式存储系统的QoS水平?

A:需从三个维度量化:

- 可用性:SLA≥99.999%(年故障时间<5分钟)

- 延迟:P999<10ms(含网络传输)

- 成本:每GB存储成本<$0.05/月(含硬件折旧)

建议使用工具链:Ceph Benchmark + fio压力测试 + Prometheus监控看板。

Q2:硬件加速是否会增加运维复杂度?

A:现代DPU方案已实现:

- 热固件升级(无需停机)

- 硬件遥测接口(直接输出Prometheus格式指标)

- 统一管控平面(通过NOS软件定义硬件行为)

典型如BlueField-3 DPU,运维操作与传统NIC无