上一篇

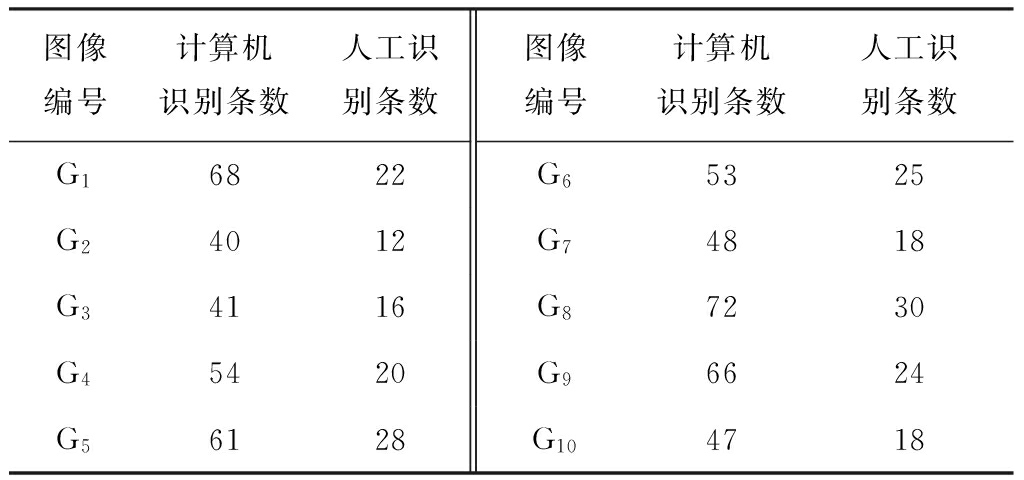

安卓图像识别软件开发

- 行业动态

- 2025-04-24

- 2868

安卓图像识别软件开发需整合TensorFlow Lite等框架,通过模型训练实现物体检测/人脸识别功能,结合OpenCV处理图像数据,适配移动端算力进行模型轻量化,最终集成至Android应用实现实时识别与交互

技术选型与方案设计

图像识别技术框架选择

| 框架类型 | 代表技术 | 适用场景 | 优势 |

|---|---|---|---|

| 移动端推理引擎 | TensorFlow Lite (TFLite) | 轻量级设备上的实时识别 | 跨平台支持、模型量化压缩 |

| 云服务集成 | Firebase ML Kit | 快速接入多种API(文本、人脸等) | 无需本地模型训练、云端更新 |

| 计算机视觉库 | OpenCV Android | 图像预处理与特征提取 | 成熟算法实现、多平台兼容 |

| 混合方案 | TFLite + ML Kit + OpenCV | 复杂场景下的高性能需求 | 结合本地推理与云端能力 |

模型选择策略

- 预训练模型:直接使用ImageNet/COCO数据集训练的分类模型(如MobileNetV3)

- 自定义训练:通过TensorFlow/PyTorch训练专用模型,导出.tflite格式

- 迁移学习:在预训练模型基础上微调(适合细分领域场景)

开发环境搭建

基础配置要求

# build.gradle (Module: app)

dependencies {

implementation 'org.tensorflow:tensorflow-lite:2.9.0'

implementation 'org.tensorflow:tensorflow-lite-gpu:2.9.0' // GPU加速

implementation 'org.tensorflow:tensorflow-lite-support:0.4.0' // 任务库

implementation 'androidx.camera:camera-core:1.1.0-alpha05' // CameraX

}权限配置

<!-AndroidManifest.xml --> <uses-permission android:name="android.permission.CAMERA" /> <uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE" /> <uses-feature android:name="android.hardware.camera" required="true" />

核心功能实现

相机数据采集

// CameraX 初始化示例

val cameraProviderFuture = ProcessCameraProvider.getInstance(this)

cameraProviderFuture.addListener({

val cameraProvider = cameraProviderFuture.get()

val preview = Preview.Builder().build()

val cameraSelector = CameraSelector.DEFAULT_BACK_CAMERA

cameraProvider.bindToLifecycle(this, cameraSelector, preview)

}, ContextCompat.getMainExecutor(this))图像预处理流程

| 步骤 | 方法 | 作用 |

|---|---|---|

| 尺寸调整 | Bitmap.createScaledBitmap() | 统一输入尺寸(如224×224) |

| 归一化 | normalize(mean, std) | 像素值缩放到[0,1]范围 |

| 通道转换 | OpenCV.cvtColor() | BGR→RGB或单通道灰度图 |

| 数据类型转换 | floatArrayOf() | 转换为模型输入要求的float数组 |

模型推理实现

// TFLite推理示例

val interpreter = Interpreter(model)

val input = Array(1) { Array(224) { Array(224) { FloatArray(3) } } } // 形状[1,224,224,3]

val output = Array(1) { FloatArray(1008) } // 根据模型输出调整

interpreter.run(input, output)

val result = output[0].indexOf(output[0].maxOrNull())性能优化方案

| 优化方向 | 实施方法 |

|---|---|

| 模型压缩 | 后训练量化(Full Integer Quantization)、剪枝(Pruning) |

| 硬件加速 | 启用GPU delegate Interpreter(model, Interpreter.Options().addDelegate(GpuDelegate())) |

| 多线程处理 | 异步推理 interpreter.runForMultipleInputsOutputsAsync(inputs, outputs) |

| 内存优化 | 复用输入/输出数组,避免频繁GC |

典型问题排查

相机启动失败

- 原因:权限未动态申请、硬件被占用、CameraX版本不兼容

- 解决方案:

// 动态权限申请 if (ContextCompat.checkSelfPermission(this, Manifest.permission.CAMERA) != PackageManager.PERMISSION_GRANTED) { ActivityCompat.requestPermissions(this, arrayOf(Manifest.permission.CAMERA), CAMERA_REQUEST_CODE) }

模型推理延迟高

- 优化路径:

- 检查是否启用GPU加速

- 使用

nnapi.NnApiDelegate()替代默认CPU - 将模型转换为量化INT8格式

- 减少输入图像分辨率

测试与发布准备

| 测试类型 | |

|---|---|

| 功能测试 | 不同光照/角度/距离下的识别准确率 |

| 性能测试 | 帧率(FPS)、内存占用、功耗 |

| 兼容性测试 | 主流机型适配(如Pixel/Samsung/Huawei)、Android版本覆盖 |

| 异常测试 | 相机被占用、存储权限拒绝、大模型OOM |

相关问题与解答

Q1:如何选择适合移动端的图像识别模型?

A:需综合考虑以下因素:

- 计算复杂度:优先选择MobileNet/EfficientNet等轻量架构

- 模型尺寸:控制在10-50MB范围内(可通过netron工具可视化结构)

- 量化支持:选择支持INT8量化的模型(比浮点运算快2-8倍)

- 任务匹配度:根据场景选择分类/检测/分割模型(如只用分类则选更轻量模型)

- 实际测试:在目标设备上进行FPS和内存占用测试

Q2:如何处理不同分辨率的输入图像?

A:标准化流程如下:

- 保持比例缩放:使用

Bitmap.createScaledBitmap()保持宽高比缩放 - 中心裁剪:通过

Matrix变换截取目标区域(如224×224) - 填充边框:对非正方形区域补灰条(需记录填充位置用于还原)

- 统一通道数:转换为RGB或灰度图(根据模型输入要求)

- 归一化处理:将像素值从[0,255]映射到[0,1]或[−1,1]区间

示例代码:

// 保持比例缩放并填充

fun preprocessImage(bitmap: Bitmap): Bitmap {

val targetSize = 224

val width = bitmap.width

val height = bitmap.height

val ratio = min(width.toFloat()/targetSize, height.toFloat()/targetSize)

val newWidth = (width / ratio).toInt()

val newHeight = (height / ratio).toInt()

// 缩放并填充

val scaled = Bitmap.createScaledBitmap(bitmap, newWidth, newHeight, true)

val marginX = (newWidth targetSize)/2

val marginY = (newHeight targetSize)/2

val finalBitmap = Bitmap.createBitmap(targetSize, targetSize, bitmap.config)

val canvas = Canvas(finalBitmap)

canvas.drawColor(Color.GRAY) // 填充灰色背景

canvas.drawBitmap(scaled, marginX, marginY, null)

return finalBitmap

}