上一篇

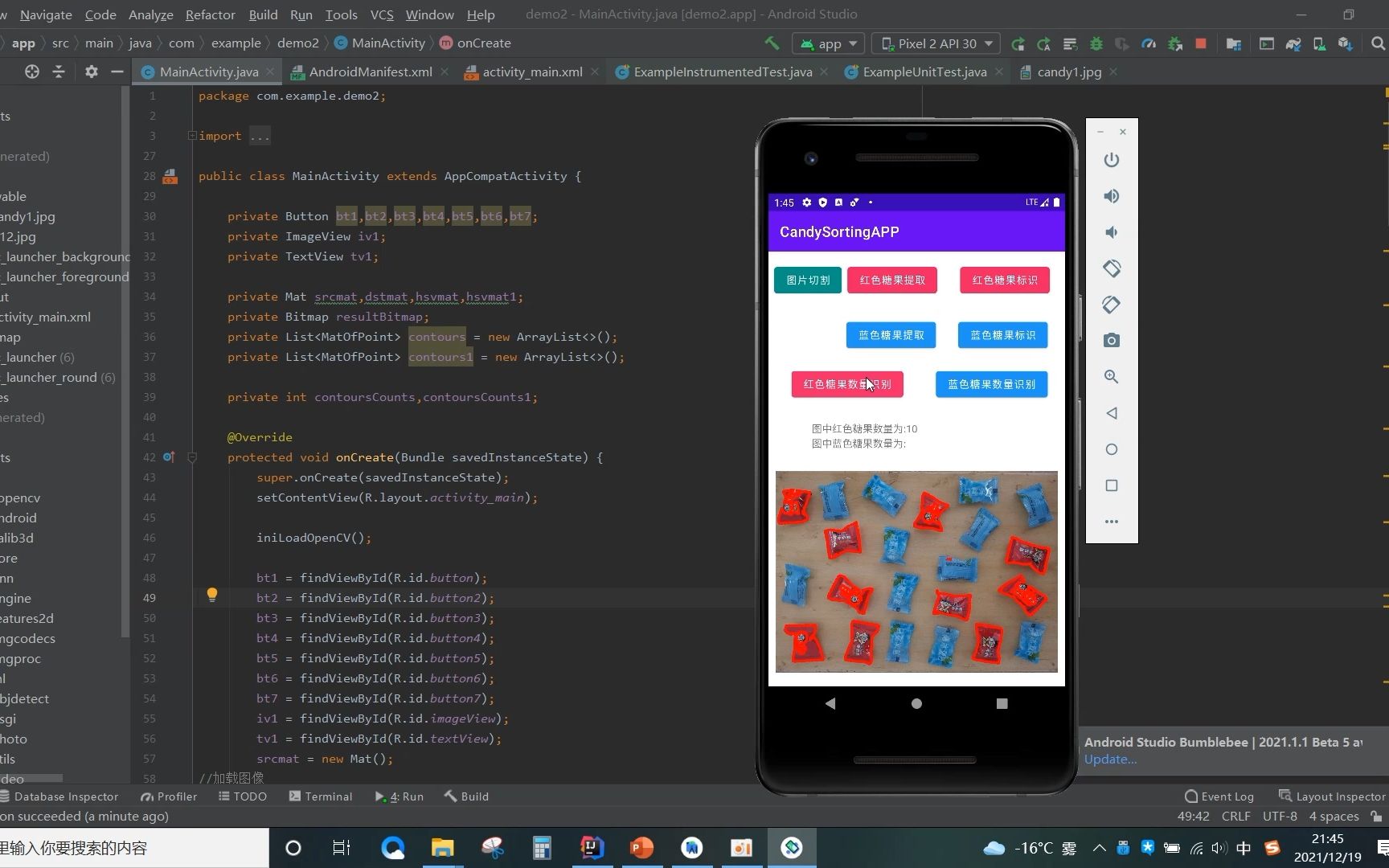

安卓图像识别源码

- 行业动态

- 2025-04-23

- 3329

基于TensorFlow Lite实现,含模型加载、预处理及实时识别,适用于Android物体检测

技术选型与环境搭建

主流图像识别框架对比

| 框架 | 特点 | 适用场景 |

|---|---|---|

| TensorFlow Lite | 轻量级TF模型部署 | 移动端推理加速 |

| ML Kit | Google官方解决方案 | 快速集成基础功能 |

| OpenCV + DNN | 传统图像处理+深度学习 | 自定义算法开发 |

| MediaPipe | 多模态处理框架 | 复杂流水线集成 |

开发环境配置

- Android Studio:4.2+版本(支持CameraX)

- NDK:ABI需匹配目标设备

- 依赖库:

implementation 'org.tensorflow:tensorflow-lite:2.9.0' implementation 'org.tensorflow:tensorflow-lite-gpu:2.9.0' implementation 'org.tensorflow:tensorflow-lite-support:0.4.0'

- 权限配置:

<uses-permission android:name="android.permission.CAMERA" /> <uses-feature android:name="android.hardware.camera" />

核心实现流程

摄像头数据采集

// CameraX初始化示例

val cameraProviderFuture = ProcessCameraProvider.getInstance(this)

cameraProviderFuture.addListener({

val cameraProvider = cameraProviderFuture.get()

val preview = Preview.Builder().build()

val imageAnalysis = ImageAnalysis.Builder()

.setBackpressureStrategy(STRATEGY_KEEP_ONLY_LATEST)

.build()

imageAnalysis.setAnalyzer(Executors.newSingleThreadExecutor(), { imageProxy ->

// 图像处理逻辑

imageProxy.close()

})

val cameraSelector = CameraSelector.DEFAULT_BACK_CAMERA

cameraProvider.bindToLifecycle(this, cameraSelector, preview, imageAnalysis)

}, ContextCompat.getMainExecutor(this))模型推理流程

// TensorFlow Lite推理示例

val interpreter = Interpreter(model)

val input = Array(1) { Array(224) { Array(224) { FloatArray(3) } } } // 根据模型调整尺寸

val output = Array(1) { FloatArray(1001) } // 根据模型输出调整

fun analyzeImage(bitmap: Bitmap) {

val resized = Bitmap.createScaledBitmap(bitmap, 224, 224, true)

val inputData = convertBitmapToFloatArray(resized)

interpreter.run(inputData, output)

val result = output[0].indexOfFirst { it > 0.5 } // 阈值判断

}结果可视化

// Canvas绘制识别框

val paint = Paint().apply {

color = Color.RED

strokeWidth = 5f

}

canvas.drawRect(rect, paint) // rect为模型输出坐标

canvas.drawText("Label: $label", x, y, paint)模型优化策略

| 优化方向 | 实施方案 |

|---|---|

| 模型压缩 | 知识蒸馏、量化(FP16/INT8) |

| 硬件加速 | GPU delegate、NNAPI |

| 内存优化 | 输入数据复用、Bitmap重用 |

| 延迟控制 | 异步处理、帧率控制 |

常见问题与解决方案

Q1:不同设备兼容性问题

解决方案:

- 动态检测CPU特性(如NEON指令集)

- 使用

Interpreter.Options设置不同Delegate:val options = Interpreter.Options() options.addDelegate(GpuDelegate()) // 自动启用GPU加速

- 提供多架构模型文件(arm/x86/arm64)

Q2:实时性不足(>300ms/帧)

优化方案:

- 模型层面:

- 替换为MobileNetV3等轻量模型

- 使用TensorFlow Lite Model Maker进行量化

- 代码层面:

- 启用多线程处理(

ExecutorService) - 降低图像分辨率(224→128px)

- 跳帧处理(每3帧分析1次)

- 启用多线程处理(

- 系统层面:

- 申请高优先级线程组

- 关闭不必要的UI渲染

相关问题与解答

Q1:如何提升复杂场景下的识别准确率?

A:可采用以下策略:

- 数据增强:在训练阶段添加旋转/缩放/光照变化

- 多模型融合:集成多个专项模型(如物体检测+分类)

- 后处理优化:使用非极大值抑制(NMS)过滤冗余框

- 上下文感知:结合地理位置、时间等辅助信息

Q2:如何处理动态输入尺寸的图像?

A:推荐两种方案:

- 统一预处理:所有输入图像resize到模型要求尺寸(如224×224),保持比例填充:

val aspectRatio = bitmap.width.toFloat() / bitmap.height val targetWidth = if (aspectRatio > 1) 224 else 112aspectRatio val targetHeight = if (aspectRatio < 1) 224 else 112/aspectRatio

- Onnx自适应模型:使用支持动态输入的模型格式(如ONNX),通过

TensorFlow Lite的dynamic_dimension参数配置:# 转换时设置动态维度 converter.set_dynamic_input_shapes({'input': [1, None, None, 3]})