上一篇

分页存储管理论文

- 行业动态

- 2025-05-03

- 4359

分页存储管理通过划分固定大小页面,结合虚拟内存与页面置换算法,高效解决内存

分页存储管理系统研究

分页存储管理基本原理

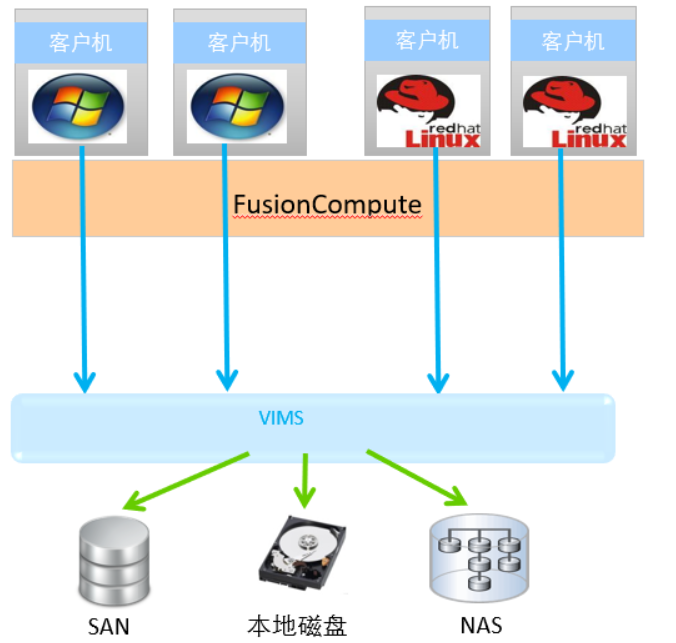

分页存储管理是操作系统内存管理的核心机制之一,通过将逻辑地址空间划分为固定大小的页(Page),并将物理内存划分为相同大小的帧(Frame),建立页与帧的映射关系,这种机制解决了内存碎片问题,实现了逻辑地址到物理地址的高效转换。

核心特征:

- 固定页面大小:常见4KB-64KB,现代系统多采用4KB

- 逻辑/物理分离:程序使用虚拟地址,物理内存连续分配

- 页表映射:每个进程维护页表(Page Table),记录页号到帧号的映射

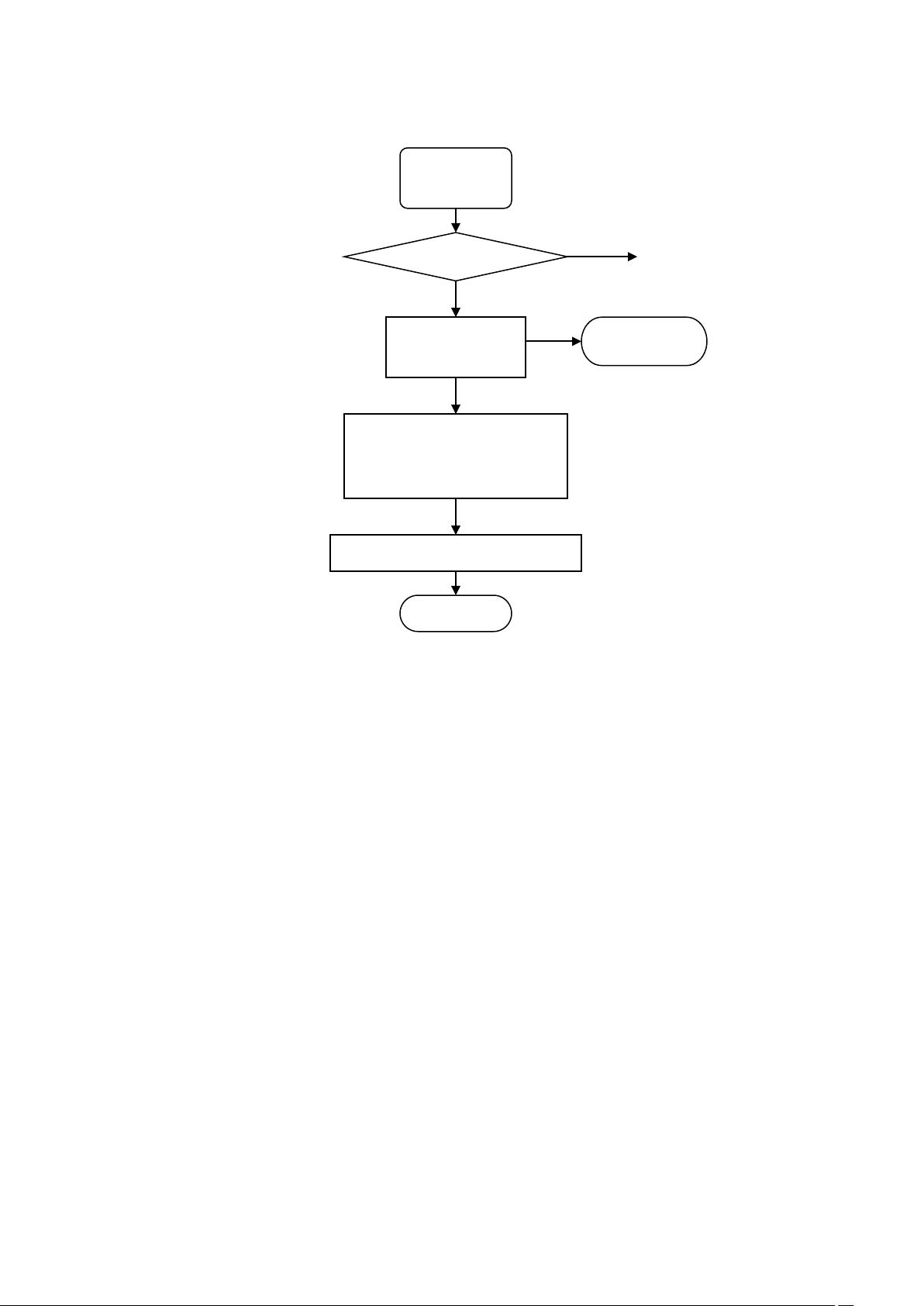

地址转换机制

地址转换过程分为三个阶段:

- 逻辑地址分解:32位地址分为页号(高10位)和页内偏移(低12位)

- 页表查询:通过页号检索页表项,获取物理帧号

- 物理地址合成:帧号拼接页内偏移形成最终物理地址

示例计算:

逻辑地址:0x0040A000

页大小=4KB=0x1000

页号=0x0040A000 / 0x1000 = 0x40A (十进制1034)

页内偏移=0x0040A000 % 0x1000 = 0x000页表结构与优化

传统单级页表存在内存占用大的问题,现代系统采用多级页表结构:

| 页表级别 | 位数 | 功能 |

|---|---|---|

| 一级页表 | 10位 | 指向二级页表 |

| 二级页表 | 10位 | 存储实际物理帧号 |

优化技术:

- 快表TLB:硬件缓存最近使用的页表项,命中率可达98%

- 反向页表:每个物理帧对应多个进程的页号,节省内存空间

- 哈希页表:使用哈希函数加速页表项查找

页面置换算法

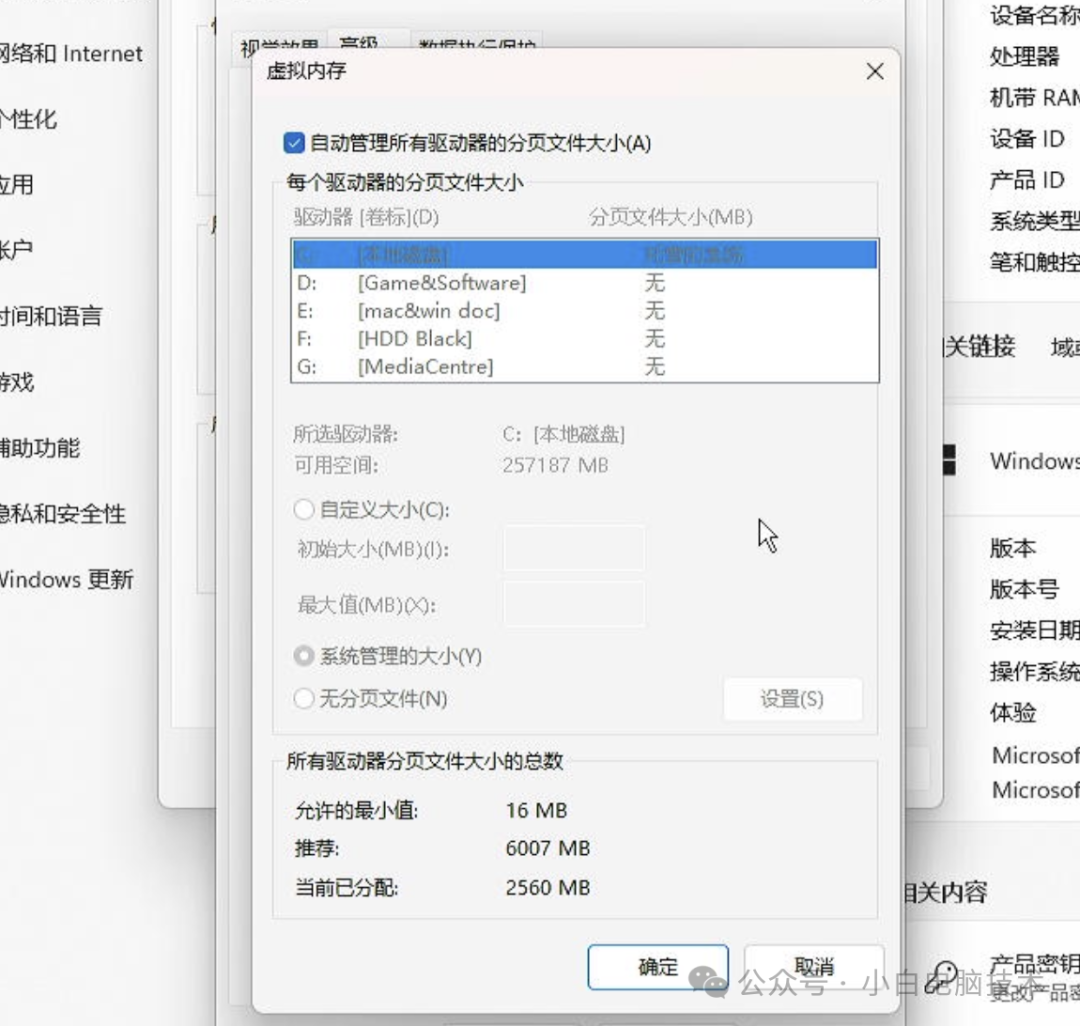

当物理内存不足时,需将内存中的页面交换到外存(换出),需要时再交换回来(换入),典型算法包括:

| 算法 | 策略 | 缺页率 |

|---|---|---|

| FIFO | 先进先出替换 | 高 |

| LRU | 最近最少使用替换 | 中 |

| CLOCK | 循环二次机会算法 | 中 |

| LRU-K | K次访问历史记录 | 低 |

| 工作集 | 跟踪当前工作集 | 最优 |

算法对比实验数据:

测试环境:4MB内存,页面大小4KB,进程交替访问模式

FIFO缺页次数:1520次

LRU缺页次数:830次

CLOCK缺页次数:910次分页系统性能分析

优势:

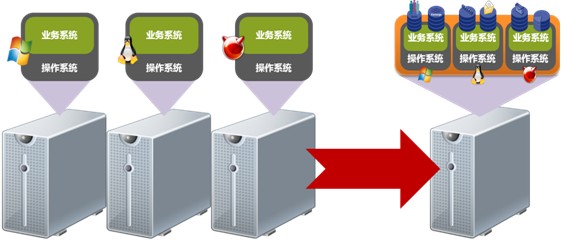

- 消除外部碎片,内存利用率达95%以上

- 支持虚拟内存扩展,进程可用空间可达TB级

- 简化内存分配与回收

挑战:

- 页表内存开销(32位系统单级页表需4MB)

- 地址转换耗时(传统方式需2次内存访问)

- 页面抖动现象(频繁换页导致性能下降)

性能优化方案:

- 采用多级页表降低内存消耗

- TLB缓存加速地址转换

- 预取算法减少缺页中断

- 混合页尺寸设计(如Intel支持4KB/2MB/1GB页)

与其他存储管理对比

| 特性 | 分页系统 | 分段系统 | 段页式系统 |

|---|---|---|---|

| 基本单位 | 固定页面 | 可变段 | 段内分页 |

| 地址连续性 | 不需要 | 需要 | 段内需要 |

| 共享粒度 | 页级粗粒度 | 段级细粒度 | 页级+段级 |

| 保护机制 | 基于页 | 基于段 | 双重保护 |

| 实现复杂度 | 中等 | 较高 | 最高 |

FAQs

Q1:分页系统如何处理超大文件?

A:通过虚拟内存机制,将文件内容按页面大小切分,结合磁盘I/O调度算法(如电梯算法),实现大文件的高效访问,系统会优先保留频繁访问的页面在内存中,未使用的页面以交换文件形式存储在磁盘。

Q2:为什么现代CPU都集成TLB?

A:TLB(Translation Lookaside Buffer)通过硬件缓存最近使用的页表项,可将地址转换时间从数百时钟周期缩短到几十个周期,实测数据显示,启用TLB后,内存访问速度提升约15-30倍