hadoop生态圈大数据

- 行业动态

- 2025-05-13

- 1

Hadoop生态圈作为大数据领域的核心技术体系,构建了从数据存储、计算到分析的完整解决方案,其发展历程经历了从单一框架到多元化组件的演进,形成了覆盖数据采集、处理、分析、可视化的全链路技术栈,以下从技术架构、核心组件、生态扩展三个维度进行系统性解析。

Hadoop技术架构解析

Hadoop采用分布式系统架构,通过模块化设计实现高扩展性,其核心包含HDFS(分布式文件系统)、YARN(资源调度系统)、MapReduce(计算模型)三大支柱组件。

| 组件 | 功能定位 | 技术特性 |

|---|---|---|

| HDFS | 海量数据存储 | 主从架构、块存储、副本机制、流式数据访问 |

| YARN | 集群资源管理 | 动态资源分配、容器化任务管理、多租户支持 |

| MapReduce | 离线批处理计算 | 分而治之思想、任务阶段划分(Map+Reduce)、数据本地化优化 |

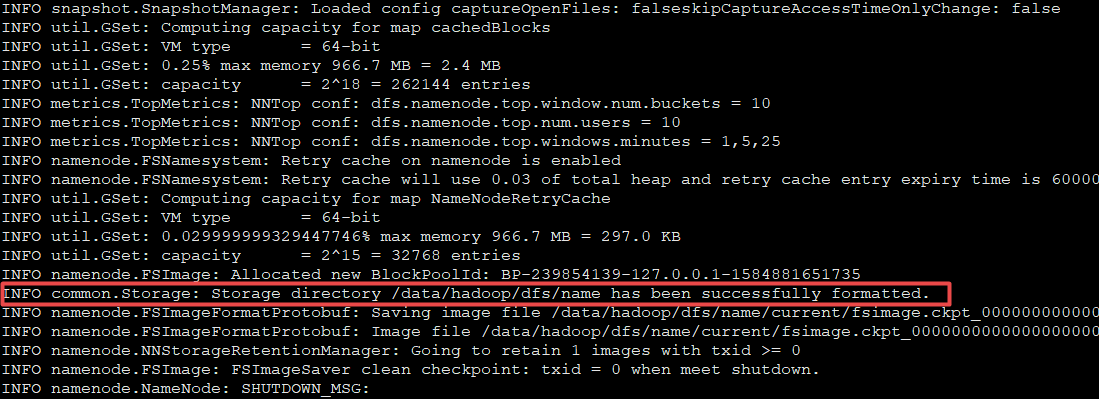

HDFS通过将数据分块存储(默认128MB/块),采用三副本策略保证数据可靠性,NameNode负责元数据管理,DataNode执行实际存储操作,YARN引入ResourceManager进行全局资源调度,NodeManager负责节点资源监控,相比早期Hadoop 1.x的静态资源分配,YARN可实现CPU、内存等资源的动态分配。

核心组件深度解析

- HDFS存储系统

- 写入流程:客户端将文件切分为数据块→向NameNode获取存储位置→通过Pipeline机制将块分发至DataNode→完成三次副本存储

- 读取优化:数据块就近读取原则,优先选择本地DataNode,减少跨节点传输

- 容错机制:心跳检测(每3秒发送)、副本数自动恢复(默认3副本)、机架感知策略

- MapReduce计算模型

- 执行流程:作业拆分→TaskTracker分配任务→Map阶段数据预处理→Shuffle&Sort阶段数据交换→Reduce阶段聚合计算

- 性能优化:Combiner预合并、数据倾斜处理、推测执行(Speculative Execution)

- 典型应用场景:日志分析(PV/UV统计)、数据ETL、大规模文本处理

- YARN资源调度

- 调度策略:FIFO(默认)、FairScheduler(公平调度)、Capacity Scheduler(容量调度)

- 容器化管理:每个任务封装为Container,包含CPU、内存等资源配额

- 多框架支持:除MapReduce外,可运行Spark、Flink等计算引擎

生态扩展组件矩阵

Hadoop生态圈通过集成多种专业工具,构建了完整的大数据处理体系:

| 领域 | 代表组件 | 核心功能 |

|---|---|---|

| 数据存储 | HBase | 实时NoSQL数据库,支持随机读写 |

| Cassandra | 分布式宽表存储,高可用架构 | |

| 数据计算 | Spark | 内存计算框架,提升迭代式计算效率 |

| Flink | 流批一体引擎,支持事件驱动型处理 | |

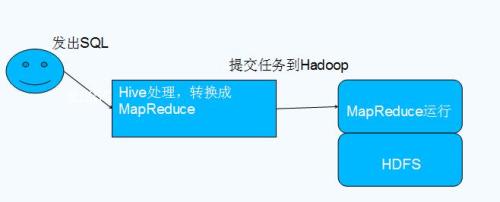

| 数据治理 | Apache Hive | SQL-on-Hadoop,提供类SQL查询接口 |

| Apache Pig | 数据流脚本语言,简化复杂数据处理流程 | |

| 任务调度 | Oozie | 工作流调度,支持定时任务和依赖管理 |

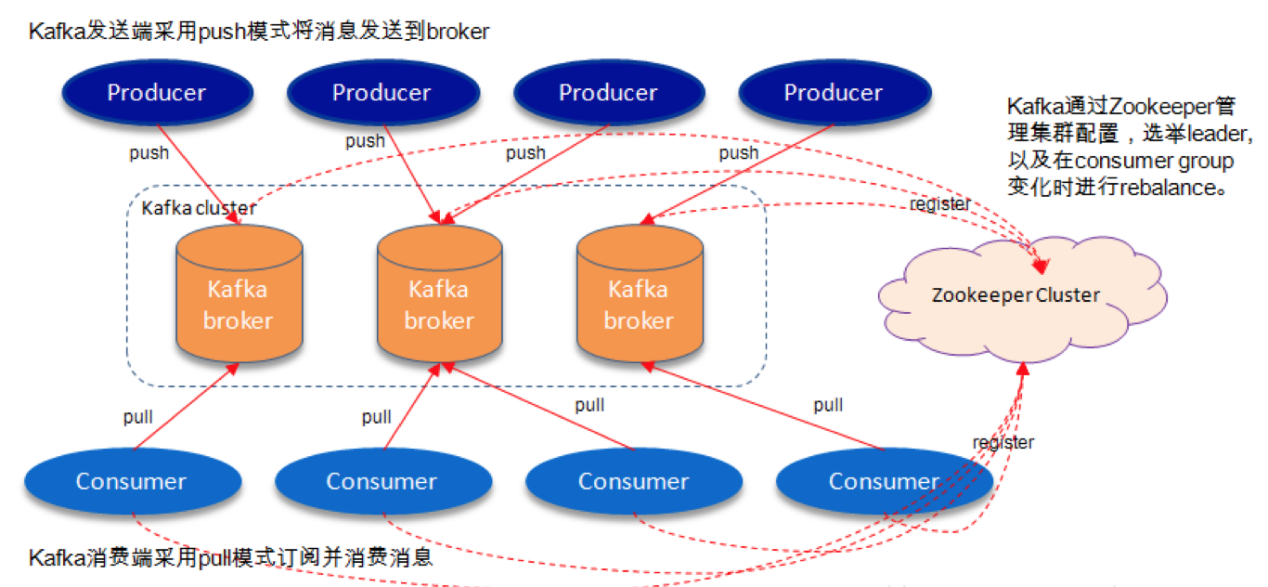

| 数据同步 | Flume/Kafka | 日志采集与实时数据传输 |

| 元数据管理 | HCatalog | 统一数据目录服务,支持表级元数据管理 |

典型组件技术对比

Hive vs Impala

| 指标 | Hive | Impala |

|——————–|—————–|——————–|

| 计算模式 | MppReduce批处理 | Mpp实时查询 |

| 适用场景 | 离线数据分析 | 即时交互式查询 |

| 性能优势 | SQL兼容性好 | 亚秒级响应 |

| 架构特点 | 依赖HDFS | 直接访问HDFS |

HBase vs Traditional RDBMS

| 特性 | HBase | 传统关系数据库 |

|——————–|——————|———————|

| 数据模型 | 稀疏列存储 | 结构化表 |

| 扩展性 | 水平扩展 | 垂直扩展 |

| 事务支持 | 行级锁 | ACID事务 |

| 查询语言 | API/Shell | SQL |

企业级应用实践

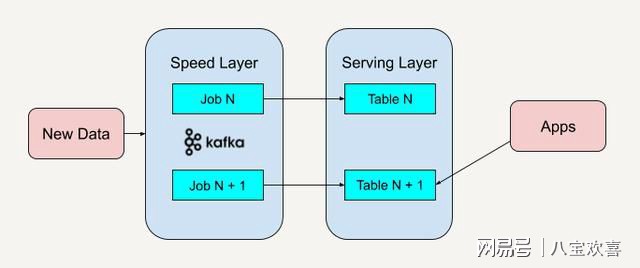

- Lambda架构实施

- 实时层:Kafka+Spark Streaming处理即时数据

- 批处理层:MapReduce进行历史数据清洗

- 服务层:Impala提供混合查询接口

- 存储层:HDFS作为统一数据湖

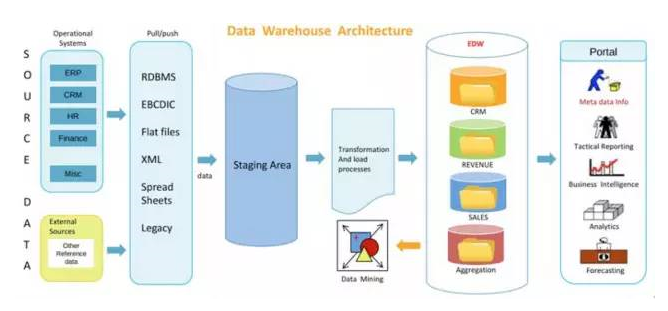

- 数据仓库建设

- 使用Hive创建分区表优化查询

- 通过Tez引擎加速复杂SQL执行

- 结合ORCFile格式提升存储效率

- 配置Ranger实现细粒度权限控制

- 机器学习场景

- Spark MLlib构建训练模型

- Hadoop集群作为数据源和计算平台

- 特征工程使用Hive进行预处理

- 模型评估通过Spark进行交叉验证

技术挑战与优化策略

- 性能瓶颈突破

- Shuffle过程优化:压缩传输(LZO/Snappy)、增加Reducer数量

- JVM调优:调整堆内存大小(-Xmx参数)、合理设置GC策略

- 小文件问题:通过CombineFileInputFormat合并处理

- 安全机制强化

- Kerberos认证:实现组件间安全通信

- Ranger授权:细粒度数据访问控制

- Audit日志:记录所有敏感操作轨迹

- TDE加密:HDFS透明数据加密

- 运维监控体系

- 部署Ambari管理界面:集群状态可视化

- 集成Ganglia监控系统:实时资源使用追踪

- 配置Nagios报警:自动触发故障通知

- 日志聚合分析:ELK栈收集处理日志信息

未来技术演进方向

- 计算存储分离架构

- 借鉴云计算理念,实现计算节点与存储节点解耦

- 通过Alluxio等中间层加速数据访问

- 支持混合云部署模式

- 智能资源调度

- 基于机器学习预测任务负载

- 动态调整资源分配策略

- 实现多优先级任务混部

- 边缘计算融合

- 在IoT设备端部署轻量级Hadoop客户端

- 构建”云-边-端”协同计算体系

- 优化小数据集处理效率

- AI原生支持

- 增强TensorFlowOnSpark等框架集成

- 提供深度学习专用算子库

- 优化GPU集群调度算法

FAQs常见问题解答

Q1:Hadoop集群出现DataNode频繁离线如何解决?

A1:需从网络连通性、磁盘IO性能、JVM稳定性三方面排查:

- 检查/etc/hosts配置是否正确,防火墙是否开放必要端口(默认50010-50020)

- 使用iostat命令检测磁盘利用率,建议预留20%空闲空间,启用DiskChecker插件

- 调整DataNode的JVM参数,增大堆外内存(-XX:MaxDirectMemorySize=2g)

- 查看hadoop-hdfs-datanode.log日志,排查具体错误码(如DNS解析失败、版本不匹配等)

Q2:如何选择合适的Hadoop发行版?

A2:主流发行版对比如下:

| 发行版 | 适用场景 | 核心优势 |

|————–|———————————–|—————————————–|

| Apache原版 | 技术研究/教学环境 | 完全开源,更新及时,社区活跃 |

| CDH | 企业级生产环境 | 完善的管理工具(CM/CDP),长线支持 |

| HDP | 混合云部署 | ISV认证丰富,支持AWS/Azure集成 |

| MapR | 高可靠性要求场景 | 增强版NMR(Non-Stop NameNode),商业支持 |

选择时需考虑:现有IT架构兼容性、运维能力水平、商业支持需求、特定功能需求(如容器化部署