上一篇

hadoop及大数据专家

- 行业动态

- 2025-05-08

- 3987

Hadoop及大数据专家精通分布式存储计算,擅数据分析治理,主导

Hadoop及大数据专家深度解析

Hadoop技术体系

Hadoop作为分布式计算领域的开源框架,其核心优势在于通过集群化部署实现海量数据的存储与计算,该框架由三大核心组件构成:

| 组件 | 功能定位 | 关键技术特征 |

|---|---|---|

| HDFS | 分布式文件系统 | 块存储、主从架构、副本机制 |

| MapReduce | 分布式计算模型 | 分而治之、任务调度、容错处理 |

| YARN | 资源管理系统 | 动态资源分配、多租户支持 |

技术特性对比表:

| 维度 | 传统数据库 | Hadoop生态系统 |

|---|---|---|

| 数据规模 | GB-TB级 | PB-EB级 |

| 扩展方式 | 纵向扩展(Scale-up) | 横向扩展(Scale-out) |

| 硬件成本 | 高端服务器依赖 | 廉价PC服务器集群 |

| 计算模式 | 结构化查询 | 批处理/流处理混合模式 |

| 容错机制 | RAID阵列等被动防护 | 数据副本+主动任务重调度 |

大数据专家能力矩阵

大数据领域专家需具备多维度技术能力,形成完整的知识体系:

核心能力金字塔:

|

| 业务理解与数据建模

|

|━━━━━━━━━━━━━━━━━━

| 分布式系统原理

|━━━━━━━━━━━━━━━━━━

| 数据工程与架构设计

|━━━━━━━━━━━━━━━━━━

└─数据算法与编程实现

(Hadoop/Spark生态)关键技能分类:

- 基础设施层:Hadoop集群部署调优、容器化部署(Docker/K8s)、网络拓扑优化

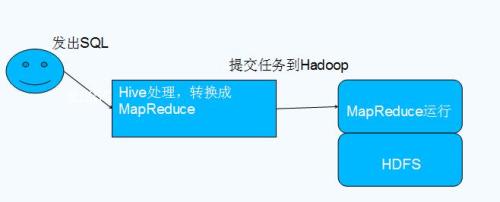

- 数据处理层:MapReduce/Spark编程、数据清洗ETL、机器学习算法实现

- 存储管理层:HDFS优化、HBase/Hive应用、数据生命周期管理

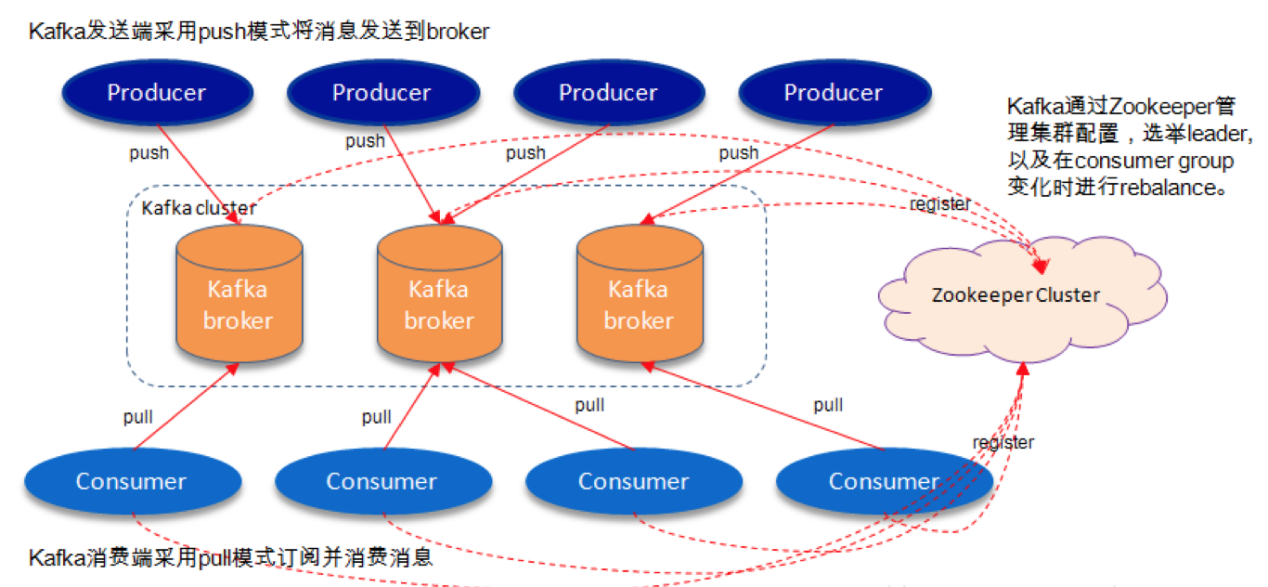

- 运维监控层:ZooKeeper协调、Ambari管理、Prometheus监控告警

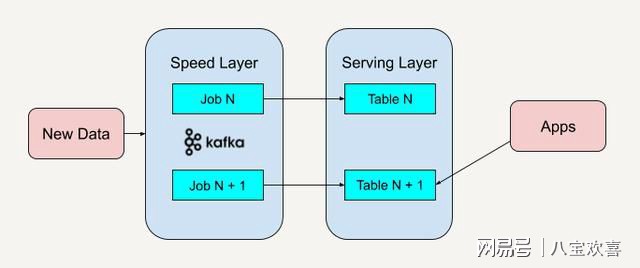

- 架构设计层:Lambda/Kappa架构选择、冷热数据分层、成本优化方案

技术演进与职业发展路径

技术演进图谱:

Hadoop 1.x → Hadoop 2.x(YARN) → Hadoop 3.x(云原生)

↓ ↓ ↓

MapReduce → Spark → Flink/Beam → Serverless架构职业发展阶段:

| 阶段 | 能力要求 | 典型岗位 |

|————|———————————–|———————————–|

| 初级工程师 | 集群部署、基础编程 | Hadoop管理员、ETL开发工程师 |

| 中级工程师 | 性能调优、组件二次开发 | 大数据架构师、平台开发工程师 |

| 高级专家 | 全链路优化、技术选型决策 | 首席数据官、大数据解决方案总监 |

| 顶尖专家 | 技术前瞻、行业标准制定 | 开源项目Committer、技术委员会成员 |

行业应用场景分析

典型应用场景矩阵:

| 应用领域 | 业务场景 | 技术实现要点 |

|---|---|---|

| 互联网 | 用户行为分析、推荐系统 | 实时流处理+离线计算混合架构 |

| 金融 | 风控模型训练、交易数据分析 | 数据脱敏、图计算引擎应用 |

| 物联网 | 设备日志采集、时序数据分析 | 边缘计算+中心化存储协同 |

| 医疗健康 | 基因组学研究、临床数据挖掘 | HIPAA合规性设计、多模态数据融合 |

| 智能制造 | 设备预测性维护、生产质量分析 | 时序数据库集成、特征工程优化 |

技术挑战与应对策略

当前主要挑战:

- 数据治理难题:元数据管理、数据血缘追踪、质量校验自动化

- 实时性要求:亚秒级延迟需求推动流计算技术升级(Flink/Structured Streaming)

- 多云环境适配:跨云平台数据迁移、混合云存储成本优化

- AI融合瓶颈:深度学习模型与大数据处理管道的无缝衔接

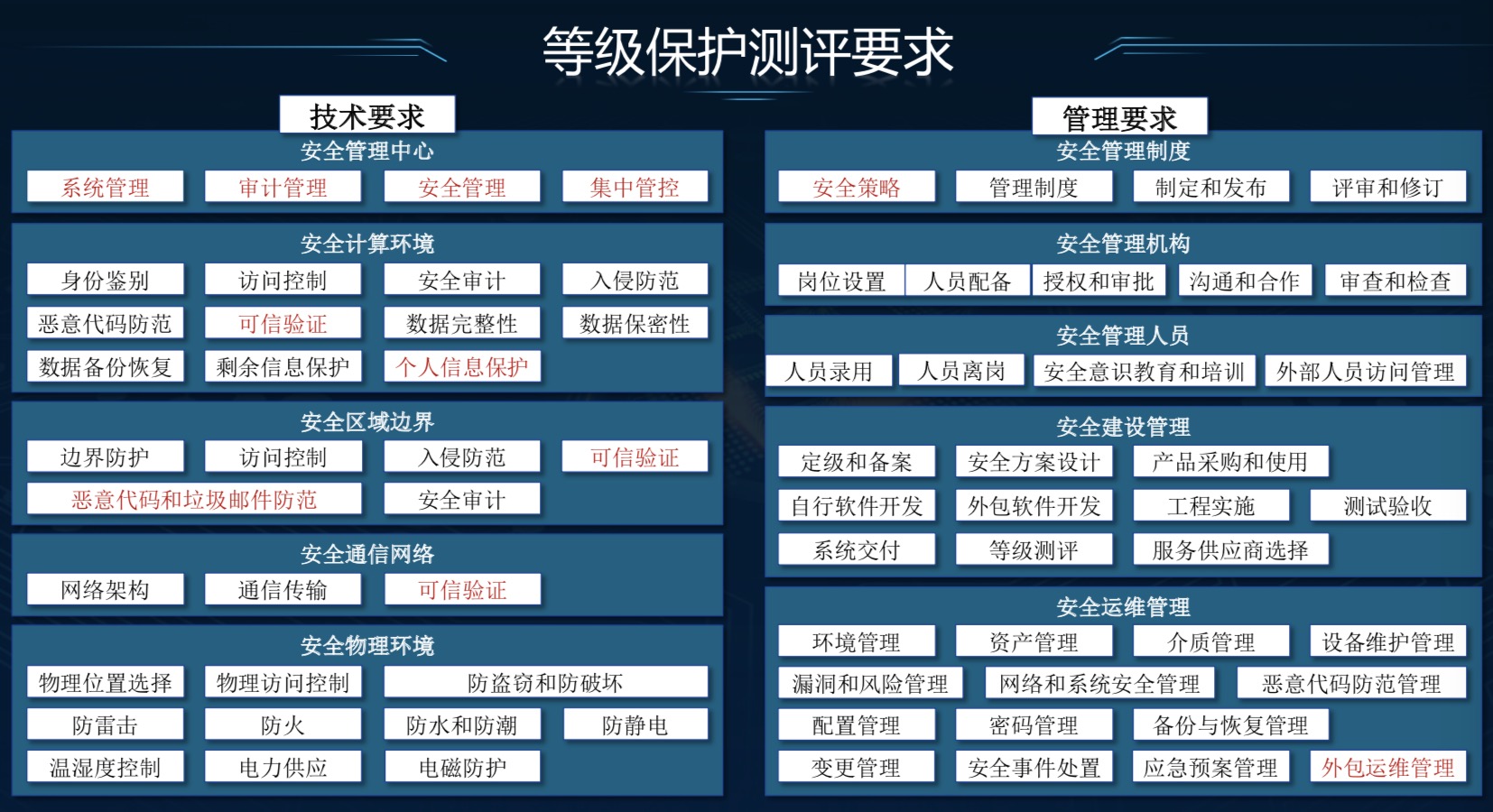

- 安全合规压力:GDPR/CCPA等法规下的隐私保护机制设计

应对技术路线:

- 采用Data Catalog实现元数据统一管理

- 构建湖仓一体架构提升查询效率

- 引入Serverless计算降低运维成本

- 应用联邦学习解决数据孤岛问题

- 部署区块链实现数据溯源审计

相关问答FAQs

Q1:Hadoop与Spark的核心区别是什么?

A1:两者主要差异体现在计算模型和资源利用方式:

- Hadoop MapReduce采用磁盘IO驱动的批量处理,适合超大规模数据集的离线计算

- Spark基于内存计算,通过RDD弹性分布式数据集实现迭代计算优化,适合机器学习等迭代式算法场景

- 资源管理方面,Hadoop使用YARN进行粗粒度资源分配,而Spark支持细粒度任务调度

Q2:如何规划大数据专家的成长路径?

A2:建议分四步递进:

- 基础建设期:掌握Hadoop生态组件原理,获得Cloudera/Hortonworks认证

- 能力拓展期:学习Spark/Flink流处理,参与实际数据仓库项目

- 架构设计期:深入研究云原生大数据服务(如AWS EMR),主导架构设计

- 战略发展期:关注数据中台、AI融合等前沿方向,参与行业标准