上一篇

分布式存储系统怎么玩

- 行业动态

- 2025-05-13

- 10

分布式存储通过数据分片、多副本冗余实现高可用,依赖一致性协议保障数据正确,横向扩展支撑海量数据,结合负载均衡优化性能

分布式存储系统的核心原理

分布式存储系统通过将数据分散存储在多个节点上,结合冗余机制和分布式协议,实现数据的高可用性、可扩展性和容错能力,其核心目标在于打破传统存储的性能瓶颈,解决单点故障问题。

数据分片与分布

- 分片策略:将数据拆分为多个块(Shard),采用哈希取模或范围划分的方式分配到不同节点,哈希分片适合随机读写,范围分片适合顺序扫描。

- 示例:

假设文件大小为100MB,分片为10MB/块,系统会将其拆分为10个块,分别存储在不同节点。

数据冗余与容错

- 副本机制:每个数据块存储多份副本(如3份),分布在不同机架或数据中心,防止节点故障导致数据丢失。

- 纠删码:通过编码算法(如Reed-Solomon)将数据转换为冗余编码,减少存储空间占用(例如存储100GB数据只需110GB空间,容忍2个节点故障)。

一致性与分布式协议

CAP定理权衡:

| 特性 | 描述 | 典型场景 |

|————|————————–|————————-|

| 一致性(C) | 所有节点数据完全一致 | 金融交易、订单系统 |

| 可用性(A) | 服务始终可用 | 电商网站、社交媒体 |

| 分区容灾(P)| 网络分区时仍能正常工作 | 跨地域数据中心 |

一致性协议:

- Paxos/Raft:用于元数据管理(如选举主节点)。

- Quorum NWR:通过读写多数派(如N=5, W=3, R=3)平衡性能与一致性。

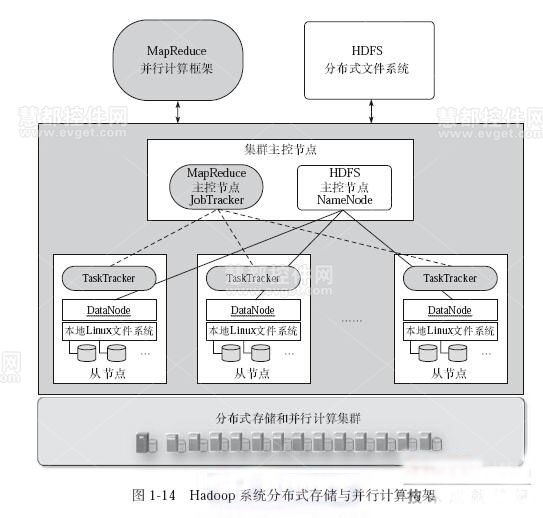

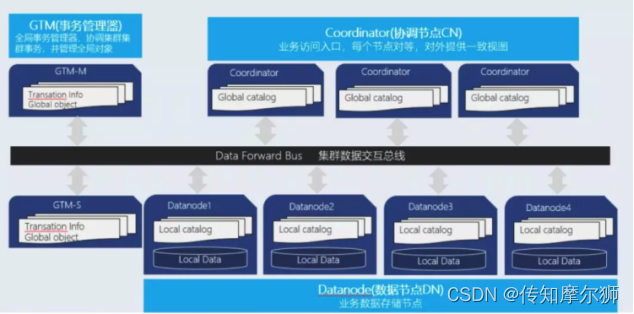

分布式存储系统的架构设计

典型架构组件

| 组件 | 功能 |

|---|---|

| 客户端 | 发起读写请求,负责数据分片、路由和合并结果 |

| 元数据服务 | 管理文件目录、分片位置、权限等(如HDFS的NameNode、Ceph的MON) |

| 存储节点 | 实际存储数据块,处理读写操作(如HDFS的DataNode、Ceph的OSD) |

| 监控模块 | 实时监测节点状态、负载均衡、故障恢复(如Prometheus+Grafana) |

数据流转示例

- 写入流程:

客户端 → 元数据服务(获取分片位置) → 存储节点(写入数据块) → 确认持久化。 - 读取流程:

客户端 → 元数据服务(查询分片位置) → 存储节点(并行读取数据块) → 合并返回。

关键技术与主流方案对比

核心技术对比

| 技术类型 | 副本机制 | 纠删码 | 适用场景 |

|---|---|---|---|

| 冗余方式 | 简单易实现,高存储成本 | 存储效率高,计算复杂 | 对存储成本敏感的场景 |

| 一致性保障 | 依赖强一致性协议 | 需结合校验机制 | 实时性要求高的业务 |

主流分布式存储系统

| 系统名称 | 架构特点 | 数据模型 | 典型应用 |

|---|---|---|---|

| Ceph | 统一存储(对象+块+文件) | RADOS底层 | 云存储、虚拟化 |

| HDFS | 主从架构(NameNode+DataNode) | 块存储 | 大数据离线计算(Hadoop) |

| MinIO | 兼容S3协议,轻量级部署 | 对象存储 | 私有云、备份归档 |

实践场景与优化策略

典型应用场景

- 云计算对象存储:AWS S3、阿里云OSS,支持海量非结构化数据。

- 大数据存储:HDFS支撑Hadoop生态,提供高吞吐顺序读写。

- 数据库分布式存储:TiDB、Cassandra通过分片实现水平扩展。

性能优化方向

- 冷热数据分层:高频访问数据用SSD,低频数据用HDD或冷存储。

- 缓存加速:客户端本地缓存(如LRU算法)或部署边缘缓存节点。

- 负载均衡:动态调整分片分布,避免热点节点(如CRUSH算法)。

相关问答FAQs

Q1:分布式存储系统如何应对节点故障?

A:通过冗余机制(副本或纠删码)保证数据可用性,若某个存储节点故障,系统会自动从其他副本或纠删码冗余中恢复数据,同时触发故障转移机制,将流量切换至健康节点,心跳检测和自动修复策略(如Ceph的PG自动修复)可进一步缩短恢复时间。

Q2:如何选择适合业务的分布式存储系统?

A:需综合考虑以下因素:

- 数据类型:非结构化数据(如图片、视频)选对象存储(如MinIO),结构化数据选数据库分片(如TiDB)。

- 一致性要求:强一致性需求(如订单系统)优先选择支持Paxos/Raft协议的系统。

- 成本与性能:纠删码可降低存储成本,但计算开销高;副本机制简单但存储效率低。

- 扩展性:需支持动态扩缩容,避免停机维护(如Ceph的无单点故障设计)。