上一篇

分布式存储试用

- 行业动态

- 2025-05-13

- 7

分布式存储试用需关注数据冗余、负载均衡及容错性,验证其弹性扩展与读写性能,确保适配业务

从入门到实践

分布式存储试用

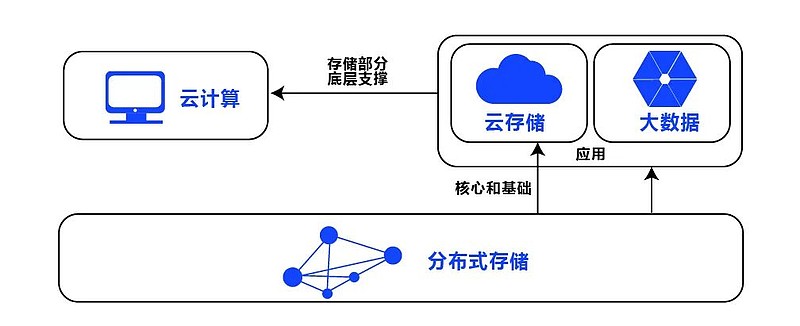

分布式存储系统通过将数据分散存储在多个节点上,实现数据的冗余备份、负载均衡和横向扩展能力,试用分布式存储系统可以帮助企业评估其性能、可靠性及与业务场景的适配性,以下内容将从环境准备、功能测试、性能评估等方面展开详细说明。

分布式存储的核心优势

| 特性 | 说明 |

|---|---|

| 高可用性 | 数据多副本存储,节点故障时自动切换,保障服务连续性 |

| 横向扩展 | 通过增加节点提升容量和性能,避免单点瓶颈 |

| 成本优化 | 支持普通PC服务器集群,降低硬件依赖成本 |

| 地理分布 | 支持跨数据中心部署,实现灾难恢复和低延迟访问 |

试用前准备工作

硬件环境要求

- 最低配置:3台及以上服务器(CPU≥4核,内存≥8GB,磁盘≥500GB)

- 网络:千兆以太网或更高,节点间延迟<10ms(局域网环境)

- 操作系统:Linux发行版(如CentOS/Ubuntu)或Windows Server

软件环境要求

- 分布式存储软件(如Ceph、MinIO、FastDFS等)

- 依赖组件:SSH远程管理工具、NTP时间同步服务

数据准备

- 模拟业务数据:建议准备10GB~1TB的测试数据(文件/数据库/日志等)

- 数据类型:结构化(MySQL/CSV)、非结构化(图片/视频)、半结构化(JSON/XML)

部署与配置步骤

本地环境快速部署(以Ceph为例)

# 安装Ceph集群(3节点示例) sudo apt update && sudo apt install ceph-deploy -y ceph-deploy new node1 node2 node3 # 初始化节点 ceph-deploy mon create-initial # 创建监控节点 ceph-deploy osd create node1:/dev/sdb node2:/dev/sdb node3:/dev/sdb # 创建存储池 ceph-deploy mgr create node1 # 部署管理节点

云环境部署(以AWS S3兼容存储为例)

- 选择开源工具:MinIO(单节点试用)或Rook+Ceph(Kubernetes环境)

- 配置步骤:

- 创建EC2实例(推荐t3.medium以上规格)

- 挂载EBS卷(GP3类型,容量≥500GB)

- 通过Helm Chart部署MinIO:

helm repo add minio-repo https://charts.min.io/ helm install minio minio-repo/minio --set accessKey=admin,secretKey=admin123

容器化部署(Docker Compose示例)

version: '3'

services:

minio1:

image: quay.io/minio/MINIO

command: server /data

volumes: [./data1:/data]

ports: [9001:9000]

minio2:

image: quay.io/minio/MINIO

command: server /data

volumes: [./data2:/data]

ports: [9002:9000]功能测试与验证

基础功能测试

| 测试项 | 操作步骤 | 预期结果 |

|---|---|---|

| 文件上传/下载 | 通过客户端上传1GB文件,验证MD5一致性 | 上传成功率≥99%,下载速度接近带宽上限 |

| 目录管理 | 创建多层目录结构,验证路径兼容性 | 支持POSIX标准路径(如/dir1/dir2/file) |

| 权限控制 | 设置用户读写权限,尝试越权访问 | 未授权操作应返回403错误 |

数据一致性验证

- 强一致性场景:通过Ceph CRUSH算法验证数据分布,执行节点宕机后检查数据完整性

- 最终一致性场景:在MinIO中启用版本控制,模拟高并发写入后校验数据版本

扩展性压力测试

- 工具:使用

fio或dd生成负载,模拟千级并发请求 - 目标:验证扩容后IOPS和吞吐量变化(如从3节点扩至5节点,性能提升≥50%)

性能评估指标

| 指标 | 测试方法 | 优化建议 |

|---|---|---|

| 吞吐量 | 使用iperf测试网络带宽,hdparm测试磁盘IO | 启用SSD缓存,调整RAID策略 |

| 延迟 | 通过latency-test工具测量读写响应时间 | 优化网络拓扑,减少跨机房传输 |

| 可靠性 | 随机关闭节点,检查数据恢复时间 | 增加副本数(如EC 4/6编码策略) |

常见问题与解决方案

问题1:集群节点无法通信

- 原因:防火墙未开放端口(如Ceph默认6789/6790)

- 解决:配置

iptables规则或安全组策略

问题2:存储空间不足

- 原因:未正确识别磁盘或容量分配不合理

- 解决:检查

/etc/fstab挂载点,使用ceph-volume工具管理逻辑卷

试用归纳与选型建议

| 场景 | 推荐方案 | 适用规模 |

|---|---|---|

| 小规模开发测试 | MinIO(单节点/Docker模式) | <10TB数据量 |

| 企业级生产环境 | Ceph(多节点+RBD块存储) | ≥100TB数据量,高可用要求 |

| 混合云架构 | JuiceFS(对象存储+POSIX兼容) | 需要跨云数据共享的场景 |

FAQs(常见问题解答)

Q1:如何将试用环境的数据迁移到生产环境?

A1:建议分阶段迁移:

- 使用

rsync或distcp工具全量复制数据 - 在生产环境重建索引并验证元数据一致性

- 逐步切换业务流量,观察监控指标(如Prometheus+Grafana)

Q2:开源分布式存储与商业版有什么区别?

A2:核心差异包括:

| 维度 | 开源方案 | 商业版方案 |

|—————-|———————————-|———————————-|

| 技术支持 | 社区论坛/GitHub Issue | 7×24小时企业级支持 |

| 功能特性 | 基础功能完善,高级功能需DIY | 内置数据压缩、自动分层存储 |

| 安全性 | 需自行配置SSL/TLS | 提供国密算法支持和合规审计模块