上一篇

Hadoop中构建数据仓库的

- 行业动态

- 2025-05-12

- 8

Hadoop通过HDFS实现海量数据分布式存储,结合MapReduce/Spark完成ETL处理,利用Hive/Pig进行数据建模与整合,构建分层数据仓库架构,支持OLAP分析及实时查询(如Impala/Presto

Hadoop中构建数据仓库的详细实践指南

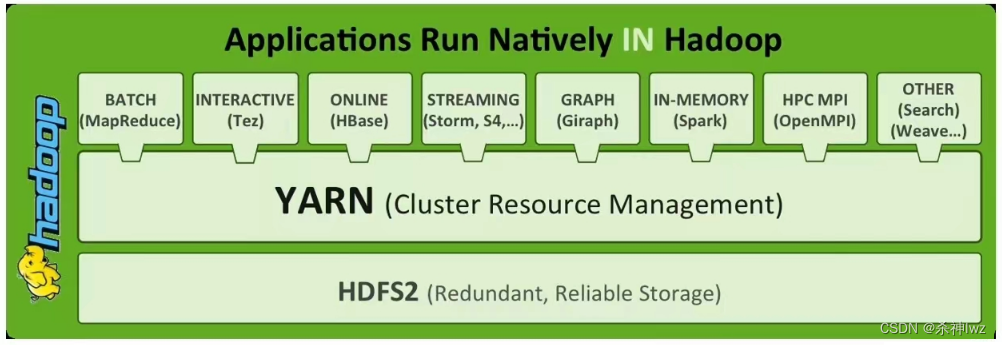

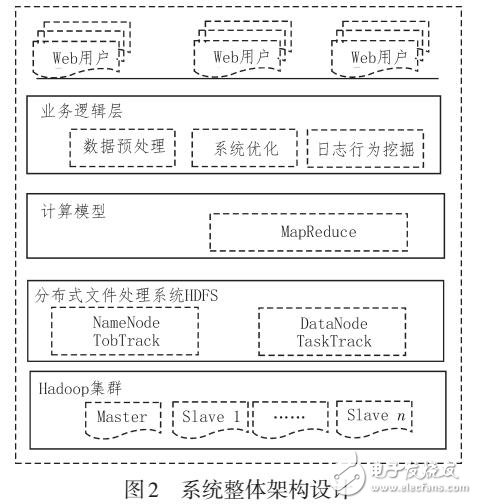

Hadoop数据仓库架构设计

在Hadoop生态中构建数据仓库需要结合分布式存储、计算引擎和数据管理工具,典型的架构包含以下层级:

| 层级 | 功能描述 | 典型工具 |

|---|---|---|

| 数据源层 | 接收多源异构数据(日志、数据库、传感器等) | Flume、Sqoop、Kafka |

| 存储层 | 分布式存储原始数据与加工后数据集 | HDFS、Hive、HBase |

| 处理层 | 执行ETL清洗、转换、聚合操作 | MapReduce、Spark、Flink |

| 服务层 | 提供SQL查询、实时分析、机器学习等服务 | Hive、Impala、Spark SQL |

| 应用层 | BI报表、数据可视化、用户自定义分析 | Zeppelin、Tableau |

核心优势:

- 弹性扩展能力(PB级数据处理)

- 高容错性(副本机制保障数据安全)

- 低成本存储(普通PC服务器集群)

关键组件选型与配置

存储格式选择

| 格式类型 | 适用场景 | 性能特点 | 压缩效率 |

|---|---|---|---|

| Text | 日志采集、临时数据 | 低读写性能 | 无 |

| Parquet | 列式存储分析型业务 | 高压缩比、列式查询加速 | 高(Snappy) |

| ORC | 复杂分析场景(Hive最佳实践) | 优化复杂查询、支持索引 | 高(Zlib) |

| Avro | 实时流处理 | 轻量级Schema演进支持 | 中 |

推荐实践:

- 热数据采用ORC格式存储(Hive表默认)

- 冷数据归档使用Parquet格式

- 日志类数据保留Text格式配合GZIP压缩

ETL流程设计

| 阶段 | 工具选择 | 关键参数 |

|---|---|---|

| 数据采集 | Flume/Sqoop/Kafka | 并发数、批处理大小 |

| 数据清洗 | Spark(DataFrame API) | 内存溢出阈值、Checkpoint频率 |

| 数据转换 | Hive UDF/Spark Transform | 正则表达式缓存、广播变量优化 |

| 数据加载 | Insert Overwrite + Dynamic Partition | 分区粒度、文件合并策略 |

性能优化技巧:

- 使用

INSERT OVERWRITE替代INSERT INTO避免小文件堆积 - 设置

mapreduce.job.reduces为分区数×1.5 - 开启中间数据压缩(

spark.sql.shuffle.compress=true)

元数据管理体系

建议采用三级元数据管理:

- 技术元数据:存储于Hive Metastore/Atlas,记录表结构、血缘关系

- 业务元数据:通过Apache Atlas进行资产目录管理

- 操作元数据:集成Airflow记录作业调度日志

血缘分析示例:

SELECT FROM lineage() WHERE target_table = 'dw.fact_sales' AND direction = 'SOURCE';

性能调优策略

资源分配优化

| 参数 | 调优方向 | 建议值范围 |

|---|---|---|

| yarn.nodemanager.vmem-pmem-ratio | 容器虚拟内存占比 | 4-8(根据机型调整) |

| spark.executor.memory | 执行器内存分配 | 4-8GB/Executor |

| hive.exec.parallel | 并行执行度 | CPU核心数×1.2 |

数据倾斜解决方案

- 预处理阶段:添加随机前缀打散Key分布

- 计算阶段:启用

spark.sql.adaptive.enabled=true动态优化 - 参数调整:设置

mapreduce.job.split.metainfo.maxsize控制Split大小

典型应用场景实现

星型模型构建

-事实表(销售数据) CREATE TABLE dw.fact_sales ( transaction_id BIGINT, product_id STRING, customer_id STRING, store_id STRING, sales_amount DECIMAL(12,2), transaction_date DATE ) STORED AS ORC; -维度表(产品信息) CREATE TABLE dim.product ( product_id STRING, category STRING, brand STRING, price DECIMAL(10,2) ) STORED AS PARQUET;

窗口函数分析

SELECT customer_id, SUM(sales_amount) OVER (PARTITION BY customer_id ORDER BY transaction_date RANGE BETWEEN INTERVAL '30' DAY PRECEDING AND CURRENT ROW) AS rolling_30d_sales FROM dw.fact_sales;

监控与运维体系

建议部署以下监控组件:

- 集群健康:Ambari/Cloudera Manager

- 作业监控:Yarn ResourceManager UI + Spark History Server

- 数据质量:Great Expectations框架

- 日志分析:ELK Stack集成

FAQs

Q1:Hadoop数据仓库与传统数仓的核心区别是什么?

A:主要差异体现在:

- 存储成本:Hadoop使用廉价PC服务器,传统数仓依赖专用硬件

- 扩展方式:Hadoop横向扩展线性增长,传统数仓垂直扩展存在瓶颈

- 计算模式:Hadoop支持批处理+流处理混合架构,传统数仓以批处理为主

- 数据类型:Hadoop可处理结构化/半结构化/非结构化数据,传统数仓主要面向结构化数据

Q2:如何处理Hadoop中的小文件问题?

A:解决方案包括:

- 合并小文件:使用Hadoop CombineFileInputFormat或Spark的repartition()

- 序列化存储:将小文件打包成SequenceFile或Avro容器文件

- 延迟加载:通过Hive的ORC文件格式支持的Index加载机制

- 存储策略调整:将小文件集中存储在特定节点,配置HDFS短回路访问