上一篇

hadoop支持数据库

- 行业动态

- 2025-05-10

- 9

Hadoop通过Hive、HBase等组件支持数据库功能,可集成MySQL等传统数据库,实现大数据存储与SQL

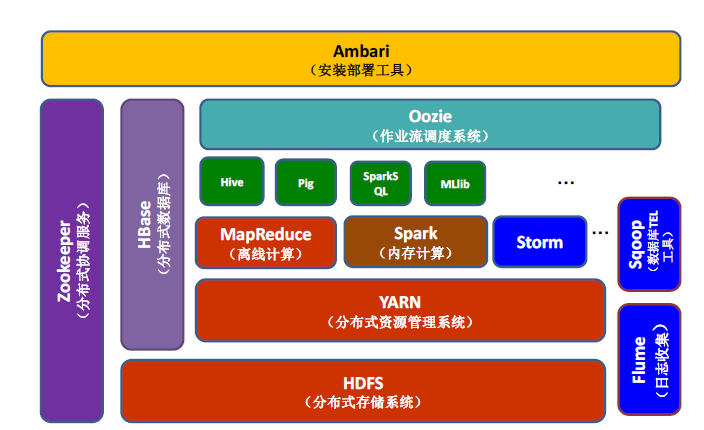

Hadoop生态系统通过其分布式存储(HDFS)和计算框架(MapReduce/YARN)为多种数据库提供了强大的支持能力,这些数据库既包含传统关系型数据库,也包含专为大数据设计的NoSQL、NewSQL以及数据仓库工具,以下是Hadoop支持的数据库类型及其集成方式的详细说明:

Hadoop支持的数据库分类

| 数据库类型 | 代表产品 | 集成方式 | 典型应用场景 |

|---|---|---|---|

| 关系型数据库(RDBMS) | MySQL、PostgreSQL、Oracle、SQL Server | Sqoop导入导出、JDBC/ODBC连接 | 传统业务数据迁移、ETL处理、事务性数据存储 |

| NoSQL数据库 | HBase(Hadoop原生)、Cassandra、MongoDB、Couchbase、Redis | HBase直接部署在HDFS上;其他通过API或连接器 | 高并发写入、半结构化/非结构化数据存储、实时数据分析 |

| NewSQL数据库 | Google Spanner、CockroachDB、TiDB | 基于Hadoop的存储层扩展或独立部署 | 高扩展性事务处理、混合负载场景 |

| 列式存储数据库 | Hive(基于HDFS)、Apache Kudu、ClickHouse | 直接存储于HDFS或通过Impala/Presto查询 | 大规模OLAP分析、数据仓库、批量处理 |

| 搜索引擎 | Elasticsearch、Solr | Logstash/Flume数据采集、自定义脚本导入 | 日志分析、全文检索、实时监控 |

| 图数据库 | Neo4j、Apache TinkerPop(通过Hadoop集群扩展) | 结合Spark图计算(GraphX)或专用连接器 | 社交网络分析、关联关系挖掘、知识图谱构建 |

| 数据仓库工具 | Amazon Redshift、Google BigQuery、Snowflake(通过Hadoop连接器) | 使用专用Connector或Sqoop导入数据 | PB级数据集成、多源数据联邦查询、BI报表生成 |

Hadoop与数据库的集成技术

数据导入导出工具

- Sqoop:用于在Hadoop(HDFS/Hive/HBase)与传统关系型数据库(如MySQL、Oracle)之间传输数据,支持增量导入和全量导出。

- Flume:实时采集日志或流式数据,可对接Kafka、Elasticsearch等实时处理系统。

- 自定义连接器:例如通过JDBC/ODBC连接PostgreSQL,或使用MongoDB的Hadoop Connector。

计算框架适配

- Hive:基于Hadoop的数据仓库,支持SQL查询,底层依赖HDFS存储,常用于离线分析。

- Impala/Presto:提供对Hive数据的实时交互式查询,适合OLAP场景。

- Spark SQL:支持直接查询Hive表、Cassandra、Elasticsearch等异构数据源。

存储层兼容

- HBase:直接运行在HDFS上,提供低延迟随机读写能力,适合实时应用。

- Kudu:结合HDFS的列式存储引擎,支持快速更新和分析,填补了HBase与Hive之间的空白。

- ICEBERG/HUDI:开源数据湖管理框架,支持ACID事务和近实时数据处理。

典型场景与数据库选择建议

场景1:传统数据仓库迁移

- 需求:将Oracle/SQL Server中的TB级数据迁移至Hadoop,并保留SQL查询能力。

- 方案:使用Sqoop导入数据至Hive,通过Impala或Spark SQL加速查询。

场景2:实时日志分析

- 需求:处理每秒百万级的日志数据,支持实时过滤和聚合。

- 方案:Logstash采集日志 → Kafka传输 → Elasticsearch存储 + Kibana可视化。

场景3:混合负载处理

- 需求:同时支持高并发写入(如设备传感器数据)和复杂分析(如机器学习)。

- 方案:HBase存储实时数据,Spark进行批处理,Kudu支持更新操作。

Hadoop生态中的数据库对比

| 特性 | Hive | HBase | Elasticsearch | Cassandra |

|---|---|---|---|---|

| 数据模型 | 列式存储(类似SQL) | 键值存储(LSM树) | 文档型(JSON) | 宽列存储(QLDB) |

| 延迟 | 高(分钟级) | 低(毫秒级) | 低(毫秒级) | 中等(亚秒级) |

| 扩展性 | 横向扩展(依赖HDFS) | 横向扩展(RegionServer) | 横向扩展(分片) | 横向扩展(节点增加) |

| 适用场景 | 离线批处理、OLAP | 实时读写、随机访问 | 全文检索、日志分析 | 高写入吞吐量、跨DC |

常见问题与优化策略

数据倾斜问题

- 原因:Hive/Spark作业中某些Key对应的数据量过大。

- 优化:启用Map端聚合(MAPJOIN)、调整分区策略或使用Salting技术。

小文件过多

- 影响:HDFS存储效率下降,MapReduce任务启动时间增加。

- 解决方案:使用CombineTextInputFormat合并小文件,或通过Hive动态分区控制文件数量。

FAQs

Q1:Hadoop自带的数据库有哪些?

A1:Hadoop核心组件中内置的数据库包括:

- HBase:分布式NoSQL数据库,依赖HDFS存储。

- Hive Metastore:管理Hive表的元数据(存储于关系型数据库如MySQL中)。

- Oozie/Falcon:工作流调度系统,依赖轻量级数据库(如Derby或MySQL)。

Q2:如何将MySQL数据导入Hadoop?

A2:步骤如下:

- 使用Sqoop命令将MySQL表导入HDFS或Hive:

sqoop import --connect jdbc:mysql://host:port/db --username user --password pass --table table_name --target-dir /user/hive/warehouse/table_name

- 在Hive中创建外部表关联导入的数据:

CREATE EXTERNAL TABLE table_name STORED AS PARQUET LOCATION '/user/hive/warehouse/table_name';

- 通过Impala或