上一篇

分布式数据库系统存储

- 行业动态

- 2025-05-10

- 7

分布式数据库系统存储通过数据分片与多副本复制实现扩展性与高可用,采用一致性协议处理分区问题,结合容错与负载均衡保障性能及数据

分布式数据库系统存储详解

分布式数据库存储架构基础

分布式数据库系统的存储设计核心目标是解决数据规模扩展、高可用性和性能优化之间的矛盾,其存储架构通常包含以下关键组件:

| 组件 | 功能描述 |

|---|---|

| 数据分片层 | 将数据划分为多个独立片段,分散存储到不同节点 |

| 复制管理层 | 通过数据副本保障高可用性,处理节点故障时的数据切换 |

| 事务协调层 | 维护跨节点事务的ACID特性,处理分布式锁与一致性协议 |

| 元信息管理层 | 存储分片规则、路由表、节点状态等全局元数据 |

| 存储引擎层 | 具体实现数据持久化(如LSM-Tree、B+Tree)和本地存储优化 |

数据分片策略与实现

数据分片是分布式存储的核心机制,主要分两类:

水平分片(Sharding)

- 原理:按行拆分数据,每个分片包含全表的部分行

- 示例:用户表按

user_id哈希取模分片,分片0存储user_id为0-999的用户数据 - 优势:扩展性好,单个分片数据量可控

- 挑战:跨分片查询需分布式SQL引擎支持

垂直分片(Vertical Partitioning)

- 原理:按列拆分数据表,不同节点存储不同列族

- 示例:订单表将基础信息(订单ID、时间)与详情信息(商品列表)分开存储

- 适用场景:宽表结构且访问模式具有列倾向性

分片策略对比表

| 维度 | 水平分片 | 垂直分片 |

|——————-|——————————|——————————|

| 切分粒度 | 行级别 | 列级别 |

| 查询效率 | 跨分片查询成本高 | 单分片查询性能好 |

| 扩展难度 | 容易水平扩展 | 受业务逻辑限制 |

| 适用场景 | 海量记录型数据 | 固定结构宽表 |

数据复制机制

分布式数据库通过多副本机制保证数据可靠性,主流实现方式:

主从复制(Master-Slave Replication)

- 同步流程:主节点处理写操作,异步同步到从节点

- 特点:读写分离,写性能高但存在理论数据丢失风险(异步模式下)

- 典型应用:MySQL主从架构、MongoDB副本集

多主复制(Multi-Master Replication)

- 冲突解决:采用版本向量(如Google Spanner)、时间戳或应用层协调

- 优势:无单点写瓶颈,但实现复杂度高

- 代表系统:CockroachDB、TiDB

Paxos/Raft共识协议

- 作用:在分布式环境下实现日志复制的一致性

- 差异对比:

- Paxos:理论最优但实现复杂

- Raft:通过选举简化流程,工程实现更友好

- 应用案例:Etcd使用Raft保证配置数据强一致

一致性模型选择

分布式存储面临CAP定理的约束,需根据业务需求选择一致性模型:

| 模型类型 | 强一致性 | 最终一致性 | 因果一致性 |

|---|---|---|---|

| 保证级别 | 线性化(Linearizability) | 放松实时性要求 | 保持操作顺序 |

| 实现代价 | 高(需共识协议) | 低(允许临时不一致) | 中等(依赖时钟同步) |

| 典型应用 | 金融交易 | 社交媒体 | 日志系统 |

典型案例:

- Amazon DynamoDB:默认最终一致性,可选强一致读

- Google Spanner:全球范围强一致性,依赖原子钟同步

- Cassandra:Tunable Consistency模型,可配置QUORUM参数

容错与恢复机制

分布式存储系统通过以下技术实现故障自愈:

数据冗余策略

- 副本数配置:通常3个副本(如HDFS)或动态副本(如Azure Cosmos DB)

- 跨机房部署:避免单地域故障(如阿里云PolarDB)

故障检测与恢复

- 心跳机制:节点间定期发送健康检查信号

- 自动故障转移:主节点失效时触发Raft选举(如etcd)

- 数据重建:新节点加入时自动同步全量数据

数据修复技术

- 校验和机制:检测静默数据损坏(如HDFS的CRC校验)

- 反熵协议:定期比对副本差异(如Riak)

- 纠删码编码:将k个数据块编码为n个校验块(如Ceph)

存储优化策略

提升分布式存储性能的关键优化手段:

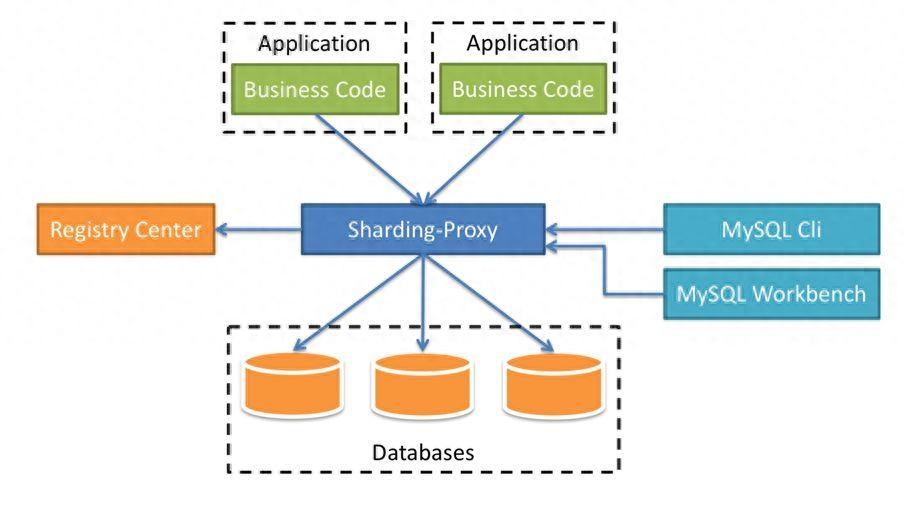

负载均衡技术

- 动态分片调整:基于热点数据自动迁移(如ShardingSphere)

- 虚拟节点映射:Hash槽位分配避免数据倾斜(如Redis Cluster)

索引优化

- 局部索引:每个分片独立构建二级索引

- 全局索引:跨分片建立跳表(如Elasticsearch)

- 倒排索引:适合全文检索场景(如Solr)

数据压缩与编码

- 列式存储压缩:Run-Length Encoding、字典编码(如Parquet格式)

- 混合编码:结合LZ4/ZSTD压缩算法(如ClickHouse)

- 前缀压缩:适用于时间序列数据(如InfluxDB)

典型场景挑战与解决方案

| 挑战场景 | 问题表现 | 解决方案 |

|---|---|---|

| 数据倾斜 | 部分节点负载过高 | 动态分片、哈希取模优化、热点数据单独处理 |

| 网络分区 | 节点间通信中断 | 使用Raft协议保证多数派决策、引入哨兵节点监控 |

| 脑裂问题 | 同一节点存在多个主副本 | 仲裁机制(Quorum)、心跳超时阈值优化 |

| 大规模写入延迟 | 写操作堆积导致延迟升高 | 批量写入、WAL预写日志优化、SSD缓存加速 |

| 异地多活部署 | 跨地域数据同步延迟大 | 异步复制+就近写入、基于时区的冲突检测 |

未来演进趋势

- 存算分离架构:计算节点与存储节点解耦(如AWS Redshift Spectrum)

- 新型硬件适配:NVMe SSD、持久内存(PMem)的存储引擎优化

- AI辅助管理:机器学习预测数据分布、智能分片调度

- Serverless存储:按需弹性伸缩的存储服务(如FaunaDB)

FAQs

Q1:如何选择水平分片和垂直分片?

A1:优先考虑业务访问模式:

- 水平分片适合高频写操作且数据量大的场景(如电商订单)

- 垂直分片适合读密集型且字段访问差异大的场景(如用户画像系统)

- 混合型应用可采用复合分片(先垂直分片再水平分片)

Q2:CAP定理中为什么不能同时满足三者?

A2:根本原因在于网络分区(Partition Tolerance)时:

- 若保证Consistency,必须放弃Availability(如ZooKeeper)

- 若保证Availability,必须允许临时不一致(如DynamoDB)

- 实践中通过BASE理论、2PC/3PC协议等在不同维度