上一篇

分布式数据库系统透明性的设计与实现

- 行业动态

- 2025-05-07

- 4472

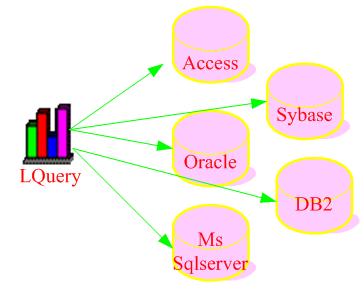

分布式数据库透明性设计通过中间件封装数据分片、位置及复制细节,采用全局事务管理协调操作,实现用户无感知

分布式数据库系统透明性的设计与实现

透明性概念与分类

分布式数据库系统的透明性是指用户和应用程序无需感知数据分布、存储位置及系统内部管理的细节,仍能像使用集中式数据库一样进行操作,其核心目标是通过技术手段屏蔽分布式特性,降低开发复杂度并提升用户体验,主要包含以下四类透明性:

| 透明性类型 | 定义 | 关键目标 |

|---|---|---|

| 数据分片透明 | 用户无需了解数据如何分片存储在不同节点 | 隐藏分片逻辑,统一访问接口 |

| 位置透明 | 用户无需感知数据物理存储位置(如机房、服务器) | 消除地理位置依赖,动态负载均衡 |

| 复制透明 | 用户无需关注数据副本数量及同步机制 | 保证高可用性,隐藏复制复杂度 |

| 故障透明 | 用户无需处理节点故障、网络分区等异常情况 | 自动故障恢复,持续提供服务 |

数据分片透明的设计与实现

分片策略设计

- 水平分片:按主键范围或哈希值划分数据,例如按用户ID哈希取模分配至不同节点。

- 垂直分片:按业务维度拆分表结构,如订单库与用户库分离。

- 混合分片:结合水平与垂直分片,需通过全局元数据管理分片规则。

中间件层实现

- 全局目录服务:维护分片映射表(如ZooKeeper存储分片元数据),客户端通过目录服务解析请求路由。

- SQL层改造:在数据库代理(如ProxySQL)或应用层添加分片逻辑,将

SELECT FROM users重写为SELECT FROM users_shard_1 UNION ALL SELECT FROM users_shard_2。

典型实现案例

- MySQL Cluster:通过

HASH或MOD函数定义分片键,由管理节点(MGM)协调数据分布。 - CockroachDB:采用基于范围的分片(Range-based Sharding),通过

Raft协议动态调整分片边界。

- MySQL Cluster:通过

位置透明的关键技术

全局事务管理

- 两阶段提交(2PC):协调器节点管理事务提交,参与者节点执行本地事务并反馈状态。

- TCC(Try-Confirm-Cancel):预留资源后根据结果确认或回滚,适用于长事务场景。

动态负载均衡

- 一致性哈希:通过虚拟节点(Virtual Node)平滑数据迁移,例如Redis Cluster采用哈希环分配槽位。

- DNS轮询与服务发现:结合Consul或Etcd实现节点动态加入/移除时的自动路由更新。

数据路由优化

- 缓存路由信息:客户端缓存分片元数据,减少目录服务查询开销(如Netflix Dynomite)。

- 智能DNS解析:根据地理位置返回最近节点IP,例如AWS Aurora的读写分离策略。

复制透明的实现机制

数据复制模型

| 模型类型 | 特点 | 适用场景 |

|————–|—————————————|—————————|

| 主从复制 | 单主写入,从库异步/同步复制 | 读多写少的高并发场景 |

| 多主复制 | 允许多个节点并发写入,解决冲突 | 全球化分布式系统 |

| Paxos/Raft | 基于日志复制的强一致性协议 | 金融级高可用数据库 |一致性保障技术

- Quorum机制:多数派节点确认写入(如Amazon DynamoD B的

W=2, R=2配置)。 - 冲突解决策略:采用向量时钟(Vector Clock)或版本号(Versioning)处理并发更新。

- Quorum机制:多数派节点确认写入(如Amazon DynamoD B的

透明性实现工具

- 中间件封装:TiDB通过

PD组件管理副本,客户端只需发起标准SQL请求。 - 存储引擎层抽象:Cassandra的

Replica节点对外暴露统一访问接口,隐藏副本同步细节。

- 中间件封装:TiDB通过

故障透明的容错设计

节点故障检测

- 心跳机制:定期发送存活心跳(如MongoDB的

replica set成员监控)。 - 分布式一致性协议:Raft协议选举领袖节点,自动剔除失效节点。

- 心跳机制:定期发送存活心跳(如MongoDB的

自动故障转移

- 主备切换:当主节点宕机时,从节点通过仲裁晋升为主节点(如MySQL MHA)。

- 多副本动态切换:基于Quorum的多数派决策,例如ETCD在半数以上节点存活时继续提供服务。

数据自愈机制

- 副本校验与修复:定期扫描副本数据一致性(如Apache Kafka的

Unclean Shutdown处理)。 - 纠删码(Erasure Coding):将数据编码为冗余块,允许部分节点丢失(如Ceph存储)。

- 副本校验与修复:定期扫描副本数据一致性(如Apache Kafka的

透明性实现的挑战与优化

| 挑战 | 优化方案 |

|---|---|

| 性能开销(如2PC延迟) | 采用异步复制+补偿机制,或轻量级协议(如Raft替代2PC) |

| 元数据管理复杂度 | 引入分布式缓存(如Redis)加速元数据查询,分片键设计避免热点 |

| 网络分区导致一致性降级 | 结合CAP定理选择合适策略,例如地理隔离场景下启用本地优先模式 |

分布式数据库透明性的实现依赖于多层技术协同:

- 分片与路由层:通过中间件抽象分片逻辑;

- 复制与一致性层:利用分布式协议保障数据可靠;

- 故障恢复层:构建自愈机制降低运维成本。

最终目标是让用户像使用单机数据库一样操作分布式系统,同时获得扩展性、高可用性等优势。

FAQs

Q1:分布式数据库的透明性是否会影响查询性能?

A1:合理设计的透明性机制不会显著降低性能,通过本地缓存分片元数据减少目录服务查询,或采用异步复制减少事务等待时间,但过度追求透明性可能引入额外开销(如全局事务管理),需根据场景权衡,OLTP场景可优先保证低延迟,而OLAP场景更关注吞吐量。

Q2:如何验证分布式数据库是否实现了真正的透明性?

A2:可通过以下测试验证:

- 分片感知测试:修改分片规则后,验证业务逻辑是否无需调整;

- 故障模拟测试:随机关闭节点,观察客户端是否无感知;

- 一致性校验:在多副本环境下注入冲突数据,检查系统能否自动解决并保持数据一致。

使用Chaos Engineering工具(如Liitlefuse)制造网络分区,验证系统是否符合预期行为