上一篇

hive是不是数据库

- 行业动态

- 2025-05-08

- 4929

Hive是基于Hadoop的数据仓库工具,提供类SQL查询(HiveQL),但非传统数据库,其本质为数据管理框架,依赖HDFS存储,适合批量处理,不具备ACID事务特性,与MySQL

Hive是不是数据库?深度解析Hive的本质与定位

Hive的基本定义与核心功能

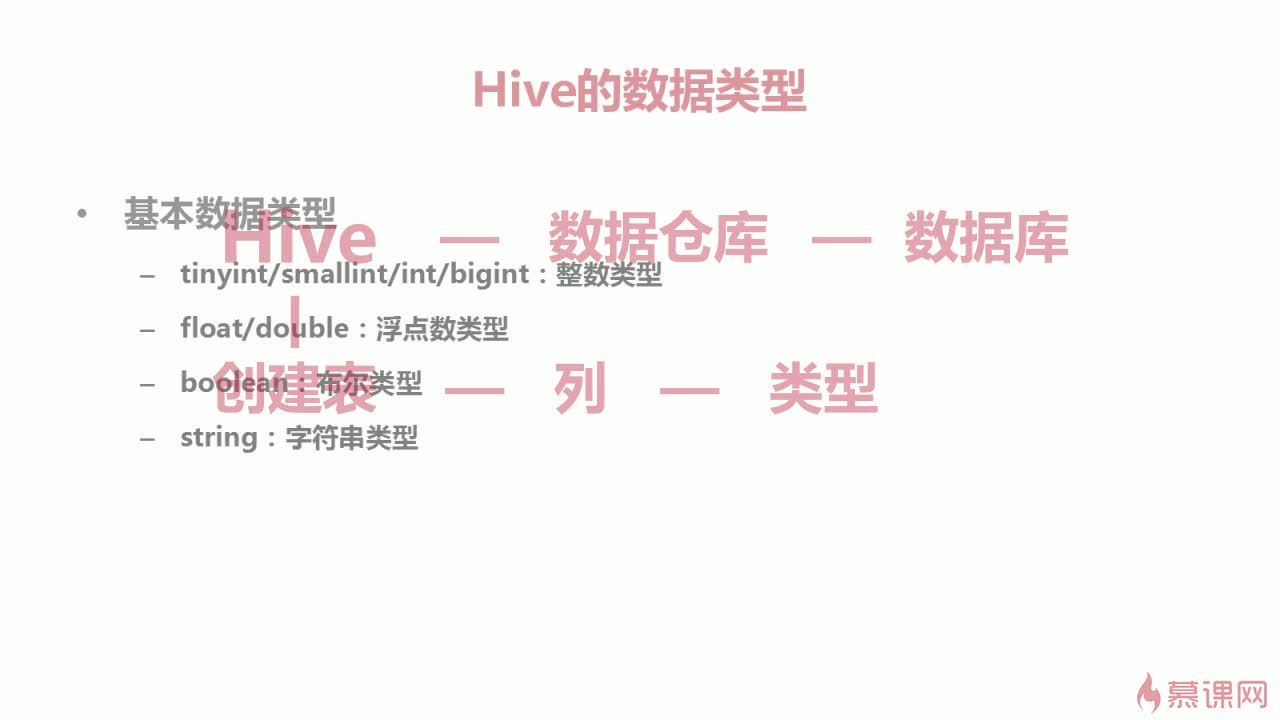

Hive是由Apache基金会开发的一款基于Hadoop生态系统的数据仓库工具,其核心功能是通过类SQL语言(Hive Query Language, HQL)实现对大规模结构化数据的存储、管理和分析,与传统数据库不同,Hive并不直接操作数据,而是将查询任务转化为MapReduce作业提交到Hadoop集群执行,以下是Hive的核心特性:

| 特性 | 描述 |

|---|---|

| 数据存储 | 依赖HDFS(Hadoop Distributed File System)存储数据,支持文本、ORC、Parquet等格式 |

| 查询语言 | 使用HQL(兼容SQL-92标准),支持复杂查询、分组、聚合等操作 |

| 计算引擎 | 默认通过MapReduce处理查询,也可集成Tez、Spark等高性能计算框架 |

| 元数据管理 | 使用关系型数据库(如MySQL、PostgreSQL)存储表结构、分区等元数据 |

| 扩展性 | 横向扩展能力强,适合PB级数据处理 |

Hive与传统数据库的本质区别

尽管Hive常被泛称为”数据库”,但其底层架构和设计目标与传统数据库(如MySQL、Oracle)存在显著差异:

| 对比维度 | 传统数据库 | Hive |

|---|---|---|

| 数据模型 | 支持ACID事务,强一致性 | 最终一致性,无事务支持 |

| 查询延迟 | 毫秒级响应 | 分钟级延迟(依赖MapReduce作业) |

| 数据更新 | 支持INSERT/UPDATE/DELETE | 仅支持批量导入(INSERT OVERWRITE) |

| 存储结构 | 行式存储,优化随机读写 | 列式存储(可选),优化批量扫描 |

| 计算模式 | 面向在线事务处理(OLTP) | 面向离线分析(OLAP) |

| 扩展方式 | 纵向扩展(硬件升级) | 横向扩展(添加节点) |

关键差异说明:

- 事务支持:传统数据库通过锁机制和日志保证ACID特性,而Hive仅支持”一次写入、多次读取”的静态数据模型。

- 实时性:Hive的查询需要启动MapReduce任务,即使简单查询也需数分钟,无法满足实时需求。

- 数据更新:Hive表数据不可原位修改,需通过覆盖写入或删除重写实现”更新”。

Hive的架构与工作原理

Hive的架构设计体现了其作为数据仓库工具的特质:

元数据层:

- 使用关系数据库存储表结构、分区、索引等元数据

- 包含数据库(Database)、表(Table)、存储位置(Location)等核心信息

查询编译层:

- HQL语句通过解析器生成抽象语法树(AST)

- 编译器将AST转换为逻辑执行计划,优化器进行谓词下推、列裁剪等优化

- 最终生成可执行的MapReduce/Tez/Spark作业

执行引擎层:

- 默认使用Hadoop MapReduce框架

- 支持通过

SET hive.execution.engine切换至Tez或Spark提升性能

存储层:

- 数据以HDFS文件形式存储,支持多种文件格式:

- TextFile:通用但无压缩

- ORC:优化列式存储,支持轻量级索引

- Parquet:开源列式存储,跨系统兼容性强

- 数据以HDFS文件形式存储,支持多种文件格式:

典型查询流程:

SELECT department, AVG(salary) FROM employee_data WHERE hire_date > '2020-01-01' GROUP BY department;

- 解析为逻辑计划:过滤→按部门分组→计算平均值

- 优化后生成MapReduce任务:Mapper负责数据过滤和预处理,Reducer执行聚合计算

- 结果写入HDFS临时目录,最终返回给用户

Hive的适用场景与局限性

最佳应用场景:

- 超大规模数据(TB-PB级)的离线分析

- 日志处理与用户行为分析

- 数据仓库ETL管道中的批量处理环节

- 机器学习特征工程的数据处理阶段

明显局限性:

- 实时性缺失:无法处理低延迟查询(需结合Impala、Druid等工具)

- 更新延迟:数据导入后无法实时修改

- 资源消耗:复杂查询可能占用大量集群资源

- 功能限制:不支持存储过程、触发器等高级数据库特性

Hive在大数据生态中的位置

Hive通常与其他工具配合使用,形成完整的数据处理链路:

| 工具类别 | 典型代表 | 与Hive的协同方式 |

|---|---|---|

| 数据采集 | Flume/Kafka | 将实时流数据写入HDFS,供Hive批量处理 |

| 实时查询 | Impala/Presto | 通过Hive Metastore共享元数据,实现混合查询策略 |

| 数据转换 | Apache Sqoop | 将传统数据库数据导入Hive表 |

| 调度系统 | Apache Oozie | 编排Hive作业与其他大数据任务的工作流 |

常见误解澄清

误解1:”Hive是分布式数据库”

澄清:Hive本质是数据仓库工具,不具备事务处理能力,其分布式特性来自底层Hadoop,而非自身架构。

误解2:”Hive可以直接替代MySQL”

澄清:两者定位完全不同:MySQL适合OLTP场景(如网站用户数据),Hive专注OLAP场景(如日志分析)。

技术演进与未来趋势

随着大数据技术的发展,Hive也在不断演进:

- 计算引擎升级:从MapReduce转向Tez/Spark,提升查询性能

- SQL兼容性:支持更多SQL:2003特性(如窗口函数)

- 即时查询优化:通过LLM(Live Logical Plan Management)实现部分查询的快速反馈

- 云原生适配:增加对Kubernetes、Serverless架构的支持

FAQs常见问题解答

Q1:Hive是否支持实时数据分析?

A1:Hive本身设计为批处理系统,查询延迟通常在分钟级,对于实时需求,建议结合Impala(亚秒级响应)或Kafka+Flink流处理框架,可通过Hive管理历史数据,Impala处理实时查询,实现冷热数据分离。

Q2:如何提升Hive查询性能?

A2:可采取以下优化措施:

- 使用ORC/Parquet列式存储格式

- 开启分区(Partitioning)和桶(Bucketing)

- 添加 BloomFilter 减少全表扫描

- 配置Tez/Spark作为执行引擎

- 合理设置并行度参数(如`mapreduce