上一篇

分布式文件存储系统的作用

- 行业动态

- 2025-05-04

- 2574

分布式文件存储系统通过数据分片与冗余保障可靠,支持扩展及并发访问,提升存储效率与可用性

分布式文件存储系统的核心作用与技术解析

分布式文件存储系统(Distributed File System, DFS)是现代数据中心和云计算基础设施的核心技术之一,其设计目标是解决传统集中式存储在容量、性能、可靠性等方面的瓶颈,以下从技术原理、核心功能、应用场景及对比分析等角度,详细阐述其作用。

分布式文件存储系统的核心作用

| 作用维度 | 具体功能与实现方式 | 典型技术案例 |

|---|---|---|

| 数据可靠性 | 通过数据冗余(如副本机制、纠删码)保障硬件故障时的数据可用性。 | HDFS的3副本策略、Ceph的CRUSH算法纠删码 |

| 扩展性 | 支持水平扩展(Scale-Out),通过增加节点动态扩展存储容量和吞吐量,避免单点性能瓶颈。 | Google File System的分片设计、MinIO对象存储 |

| 高可用性 | 元数据服务与数据服务分离,通过主备节点或Paxos/Raft协议实现元数据高可用。 | Ceph的MON集群、GlusterFS的自愈机制 |

| 负载均衡 | 采用哈希分片或一致性哈希分配数据,结合负载感知调度算法优化读写流量。 | HDFS的Block池、Ceph的CRUSH Map |

| 成本优化 | 利用普通PC服务器构建存储集群,降低硬件成本;通过数据去重、压缩减少存储空间浪费。 | OpenStack Swift、Ceph对象存储 |

| 安全与合规 | 支持细粒度访问控制(ACL)、传输加密(TLS/SSL)及审计日志,满足等保与行业合规要求。 | AWS S3的IAM策略、Ceph的RBAC模型 |

关键技术作用深度解析

数据冗余与容错机制

- 副本策略:如HDFS默认将数据块存储3份副本,分别分布在不同机架的节点上,避免单点故障导致数据丢失。

- 纠删码(Erasure Coding):如Ceph采用Reed-Solomon编码,将1份数据拆分为N份数据块和M份校验块,存储效率比副本策略提升50%以上(例如6+3配置可容忍3节点故障)。

- 场景价值:在硬件故障率较高的环境中(如数据中心),冗余机制可将数据持久性提升至99.999%(5个9)。

水平扩展能力

- 容量扩展:通过添加存储节点直接扩充容量,无需停机,一个100节点的Ceph集群可轻松扩展至数千节点。

- 性能扩展:数据分片(Sharding)和并行处理技术(如MapReduce)允许读写操作随节点增加线性提升。

- 对比传统存储:传统SAN/NAS依赖专用硬件,扩展成本高且受控制器性能限制。

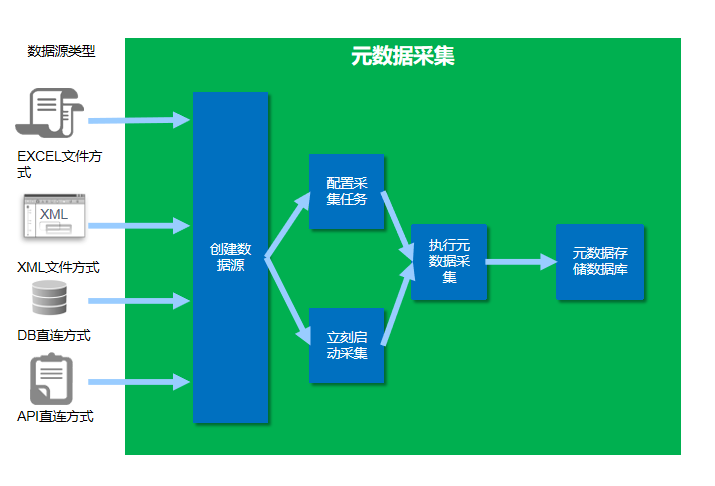

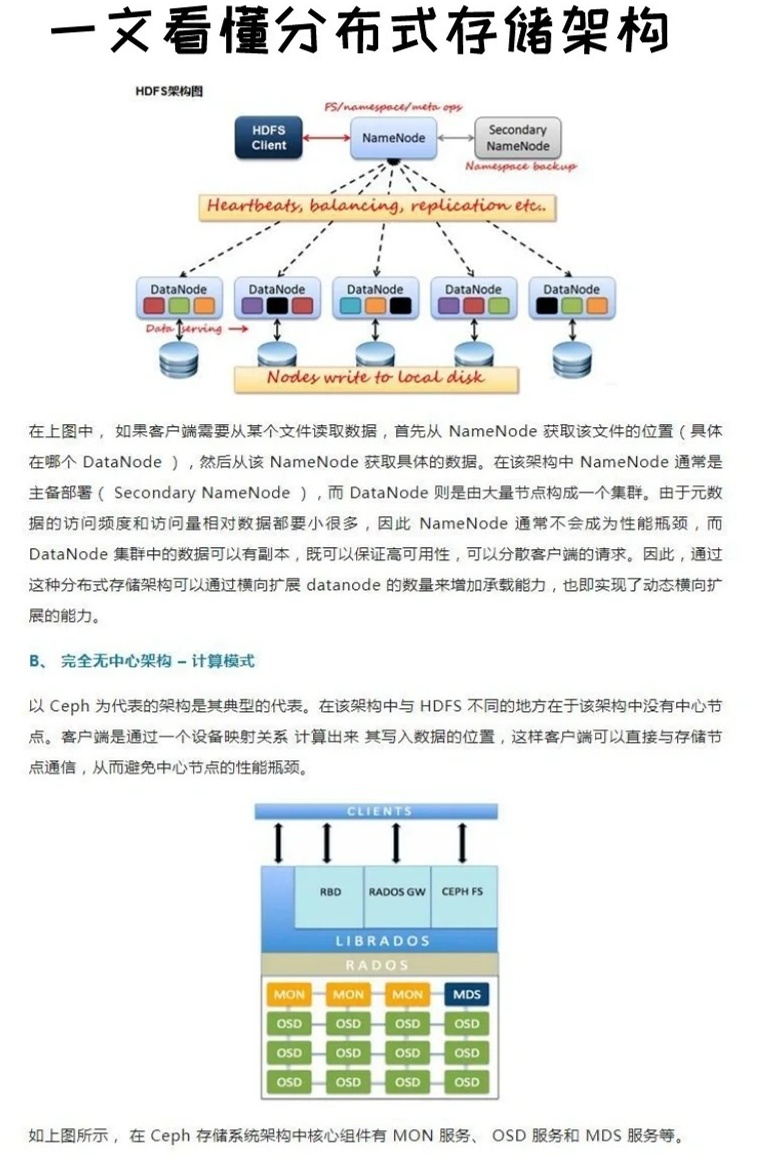

元数据管理与一致性

- 元数据服务分离:如Ceph的MON组件负责维护存储池元数据,客户端直接与OSD(对象存储设备)交互,避免元数据成为瓶颈。

- 一致性协议:基于Raft或Paxos的元数据同步机制(如etcd、ZooKeeper)确保集群状态一致,典型延迟<10ms。

- CAP定理权衡:多数系统选择AP(可用性+分区容忍)或CP(一致性+分区容忍),例如Amazon S3优先保证最终一致性。

负载均衡与流量优化

- 数据分片算法:一致性哈希(如Ceph CRUSH Map)确保数据均匀分布,节点增减时迁移量最小化。

- 动态负载感知:根据节点实时负载(CPU、网络带宽)调整数据流向,例如MinIO的智能调度策略。

- 热点数据处理:通过缓存(如Redis)或分层存储(冷热数据分离)缓解高并发访问压力。

成本与资源效率

- 硬件成本:利用商用服务器(如x86)替代专用存储设备,每TB成本降低70%以上。

- 软件优化:数据去重(Deduplication)可减少50%-90%的存储空间占用;压缩算法(如Zstandard)进一步节省带宽。

- 能源效率:分布式架构支持按需启停节点,相比传统存储节能30%-50%。

典型应用场景与选型建议

| 场景需求 | 推荐方案 | 关键原因 |

|---|---|---|

| 大数据分析(如Hadoop) | HDFS | 原生支持MapReduce,高吞吐顺序写入优化 |

| 云原生应用(容器/微服务) | MinIO、Ceph | 兼容S3 API,支持Kubernetes CSI驱动 |

| 混合云存储 | GlusterFS、Ceph | 支持多站点同步,统一命名空间 |

| 冷数据归档 | Amazon S3 Glacier、OpenStack Swift | 低成本、高耐久性设计 |

相关技术概念延伸

CAP定理与分布式存储设计

- Consistency(一致性):强一致性系统(如Spanner)需牺牲部分可用性,适合金融交易场景。

- Availability(可用性):DynamoDB采用最终一致性,适用于互联网高并发场景。

- Partition Tolerance(分区容忍):分布式存储必须支持网络分区后的服务连续性。

心跳机制与故障检测

- 节点定期发送心跳(如每3秒),若超时则触发数据迁移或副本重建。

- 脑裂问题(Split-Brain)解决方案:通过仲裁节点(如ZooKeeper)选举唯一主节点。

FAQs

Q1:如何选择HDFS、Ceph还是MinIO?

- HDFS:适合Hadoop生态,大文件顺序写入场景(如日志分析),但小文件性能差。

- Ceph:通用性强,支持块、对象、文件存储,适合混合云和多协议需求。

- MinIO:轻量级S3兼容方案,开箱即用,适合云原生应用和DevOps环境。

Q2:分布式存储如何保证数据一致性?

- 强一致性:通过分布式锁或线性化共识协议(如Raft)确保读写顺序,但影响性能。

- 最终一致性:允许短暂数据不一致(如DNS解析),通过版本控制和冲突解决机制修复。

- 权衡选择:金融类应用需强一致性,而社交媒体等场景可接受最终一致性以提升