上一篇

分布式数据管理

- 行业动态

- 2025-05-06

- 2

分布式数据管理通过多节点协同实现数据分片、复制与同步,依托一致性协议保障数据完整性,结合容错机制与负载均衡提升系统高可用

分布式数据管理:核心概念与实践解析

分布式数据管理是现代大规模系统中的核心技术,旨在解决数据存储、访问、一致性及高可用性等问题,随着云计算、物联网和大数据技术的普及,企业对分布式数据管理的需求日益增长,以下从核心目标、关键技术、挑战与解决方案等维度展开分析。

分布式数据管理的核心目标

| 目标 | 定义与意义 |

|---|---|

| 数据一致性 | 确保不同节点间的数据副本保持同步,避免读写冲突或数据错误。 |

| 高可用性 | 通过冗余设计实现故障自动切换,保证系统持续提供服务(如99.99% SLA)。 |

| 横向扩展性 | 支持通过增加节点提升存储和计算能力,无需停机重构。 |

| 容错性 | 在部分节点故障时仍能正常运作,依赖数据副本和自愈机制。 |

| 低延迟访问 | 优化数据分布策略,减少跨节点通信开销,提升读写性能。 |

关键技术与实现方案

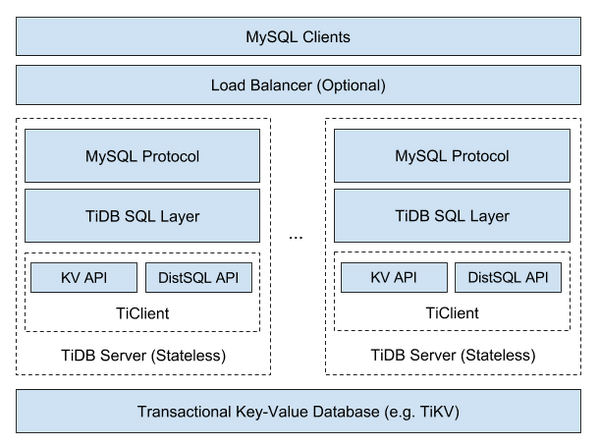

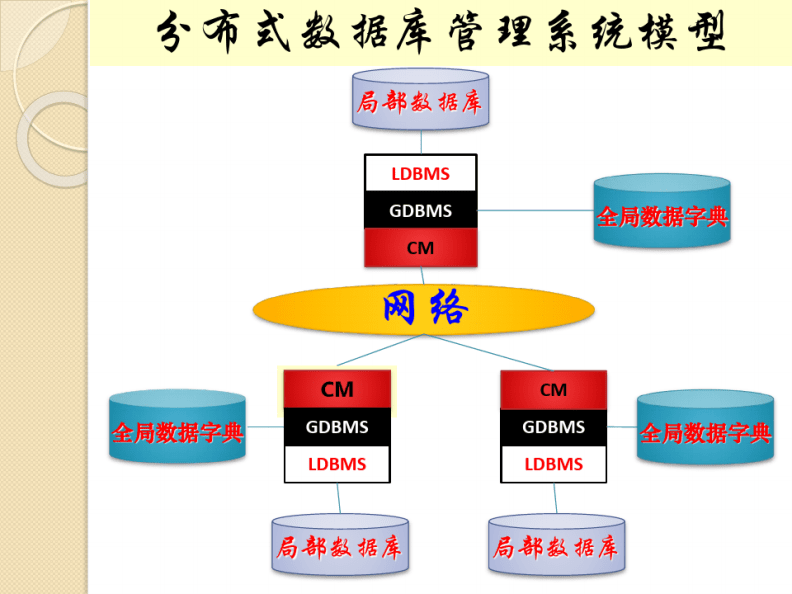

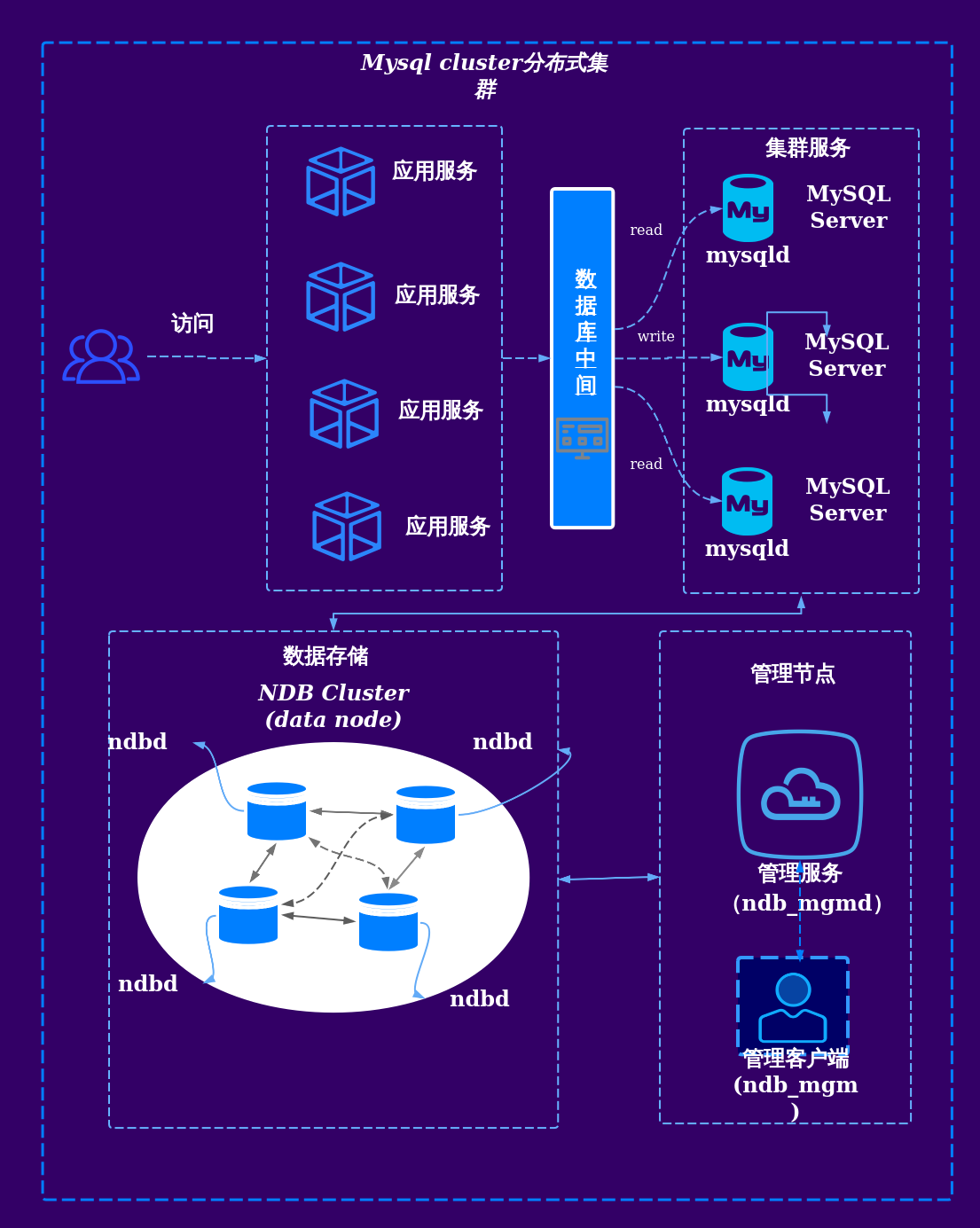

分布式存储系统

- 典型架构:如HDFS(Hadoop)、Ceph、Cassandra,采用“无中心化”设计,数据分片存储。

- 数据副本机制:通过多副本(如3副本)保证容错,结合一致性协议(如Raft)同步数据。

- 示例:Cassandra使用“环形哈希”分区数据,支持跨数据中心部署。

共识算法与一致性模型

- 强一致性:依赖Paxos/Raft算法,需多数节点确认写入(如ETCD、ZooKeeper)。

- 最终一致性:允许短期数据不一致,通过异步复制提升性能(如DynamoDB、Riak)。

- 冲突解决:采用版本向量(Vector Clocks)或时间戳标记解决并发冲突。

数据分区与负载均衡

- 分区策略:

| 策略 | 适用场景 | 缺点 |

|—————-|———————————-|——————————|

| 哈希分区 | 均匀分布数据,避免热点 | 范围查询效率低 |

| 范围分区 | 按时间/ID范围划分,支持高效检索 | 易出现数据倾斜 |

| 混合分区 | 结合哈希与范围(如HBase) | 复杂度高 | - 动态负载均衡:通过一致性哈希或虚拟节点技术,在节点扩容/缩容时最小化数据迁移。

- 分区策略:

索引与查询优化

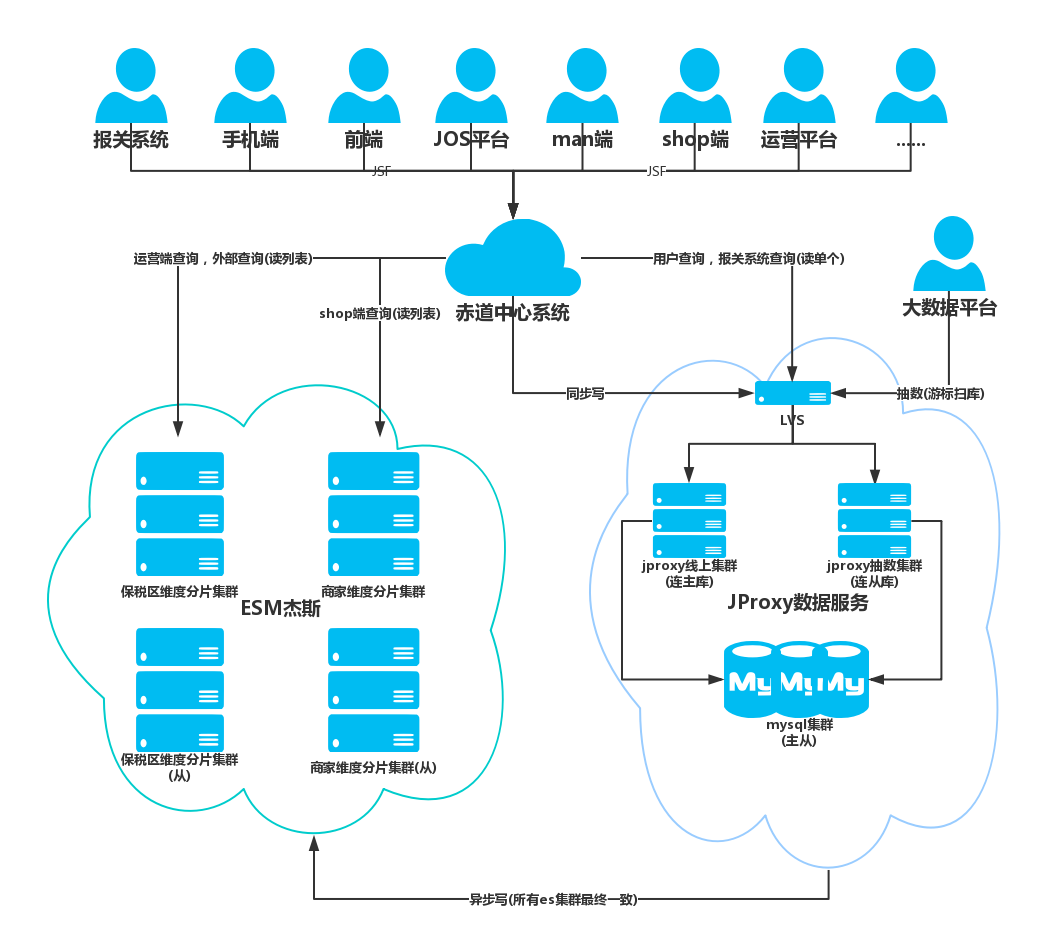

- 分布式索引:如Elasticsearch倒排索引,支持全文搜索;HBase的RowKey设计优化范围查询。

- 本地化计算:数据与计算任务就近分配(如Spark RDD),减少网络传输开销。

核心挑战与应对策略

CAP定理的权衡

- 问题:无法同时满足一致性(Consistency)、可用性(Availability)、分区容忍(Partition Tolerance)。

- 解决方案:

- CP优先:金融场景选择强一致性(如Raft协议),牺牲部分可用性。

- AP优先:社交应用允许短暂不一致,通过异步复制提升可用性。

数据倾斜与热点问题

- 原因:某些分区数据量过大或访问频率过高(如明星用户数据)。

- 缓解方法:

- 动态拆分热点分区(如Redis集群的槽位迁移)。

- 引入缓存层(如Memcached)分散读压力。

网络延迟与带宽瓶颈

- 优化手段:

- 数据就近存储(如阿里云的地域节点部署)。

- 压缩数据传输(如Protobuf序列化)。

- 批量处理请求(如Kafka的日志聚合)。

- 优化手段:

与传统数据管理的关键差异

| 对比维度 | 传统集中式数据库 | 分布式数据管理 |

|---|---|---|

| 架构 | 单节点部署,垂直扩展 | 多节点集群,水平扩展 |

| 一致性保障 | 依赖事务日志(如ACID) | 基于分布式协议(如Raft/Paxos) |

| 故障恢复 | 备份与还原耗时较长 | 自动故障转移,秒级自愈 |

| 适用场景 | 小规模、低延迟要求业务 | 海量数据处理、高并发互联网服务 |

典型应用场景

- 电商订单系统:通过分库分表(如MySQL Sharding)处理亿级订单数据。

- 社交网络:使用Cassandra存储用户动态,支持全球多活部署。

- 物联网平台:采用TimescaleDB时序数据库管理设备传感器数据。

FAQs

Q1:如何选择分布式数据的一致性模型?

A:根据业务需求权衡:

- 强一致性:适用于金融交易、订单系统等对数据准确性要求极高的场景。

- 最终一致性:适合社交、日志分析等允许短暂延迟的场景,可提升性能。

Q2:如何优化分布式系统的查询效率?

A:关键措施包括:

- 设计合理的分区键,避免全表扫描。

- 利用本地索引(如HBase的RowKey优化)。

- 结合内存缓存(如Redis)加速热点数据访问。

- 采用异步批处理框架(如Flink)减少实时计算压力。