上一篇

分布式数据管理如何看配置

- 行业动态

- 2025-05-05

- 2

通过系统自带工具(如Hadoop fsck)、配置文件路径(如YAML/XML)、管理控制台及日志监控查看配置,需关注节点一致性、版本兼容与参数调优

分布式数据管理配置解析与实践指南

在分布式系统中,数据管理的配置直接影响系统性能、可靠性和可扩展性,如何正确查看和理解配置参数,是保障系统稳定运行的关键,本文将从配置核心要素、查看方法、优化策略及工具实践四个维度展开分析。

分布式数据管理的核心配置要素

分布式数据管理的配置涉及数据存储、计算、网络等多个层面,需关注以下关键模块:

| 配置类别 | 典型参数 | 作用说明 |

|---|---|---|

| 数据分片策略 | 分片键(Shard Key)、分片数量 | 决定数据分布方式,影响负载均衡与查询效率 |

| 副本机制 | 副本因子(Replication Factor)、主从同步策略 | 保障数据高可用,控制存储成本 |

| 一致性协议 | Paxos/Raft算法选择、超时时间 | 决定数据一致性强度(强一致/最终一致) |

| 网络通信 | 心跳间隔、RPC超时阈值 | 影响节点故障检测速度与跨节点调用稳定性 |

| 存储引擎 | 内存缓存比例、压缩算法 | 优化存储空间利用率与读写性能 |

| 容错机制 | 自动故障转移阈值、数据修复策略 | 定义系统自愈能力与人工干预边界 |

如何查看分布式系统的配置

静态配置查看

- 配置文件解析:大多数分布式系统(如HBase、Cassandra)通过

config.yaml或application.properties文件定义参数,可直接查看文件内容。 - 命令行工具:使用

kubectl describe(K8s环境)或nodetool status(Cassandra)获取运行时配置。 - 管理控制台:云服务(如AWS DynamoDB、Azure Cosmos DB)提供可视化配置面板。

- 配置文件解析:大多数分布式系统(如HBase、Cassandra)通过

动态配置监控

- 指标采集系统:Prometheus+Grafana可实时采集配置变更数据(如分片迁移次数、副本延迟)。

- 日志分析:通过ELK栈检索

ERROR级别日志,定位配置错误(如”Replication factor exceeds node count”)。 - 分布式追踪:Jaeger工具链可跟踪配置不当引发的性能瓶颈(如跨数据中心同步延迟)。

版本对比工具

- 使用

diff命令对比新旧配置文件差异。 - Git版本控制系统回滚错误配置变更。

- 使用

配置优化实战策略

分片策略调优

- 热点分片检测:通过统计各分片QPS,对访问频率高的分片进行二次拆分。

- 哈希算法选择:MurmurHash比MD5更快,但可能增加分片倾斜风险。

副本因子平衡

- 成本公式:

存储成本 = 数据量 × 副本因子 / 节点数量,需结合业务SLA调整。 - 跨机房部署:采用”2本机房+1异地”策略,兼顾灾备与性能。

- 成本公式:

一致性级别动态调整

- 读操作:允许最终一致的场景(如日志分析)可降级为

QUORUM模式。 - 写操作:金融交易类场景需保持

STRICT一致性,但会牺牲吞吐量。

- 读操作:允许最终一致的场景(如日志分析)可降级为

网络参数微调

- 心跳间隔:设为RTT(往返时延)的2-3倍,避免频繁触发故障转移。

- RPC超时:根据网络质量动态调整,公式:

超时时间 = 基础延迟 × (1 + 波动系数)。

主流工具配置实践

| 工具/框架 | 核心配置项 | 查看命令 | 优化建议 |

|---|---|---|---|

| Apache Kafka | num.partitions、replication.factor | kafka-topics.sh --describe | 分区数=机器数×3,副本因子不超过节点数 |

| MongoDB Sharding | chunkSize、migrationThreshold | sh.status() | 64MB chunk适合高频小文档,256MB适合大文档 |

| Redis Cluster | cluster-enabled、hash-slots | CLUSTER NODES | 16384槽位分配需均匀,避免单点过热 |

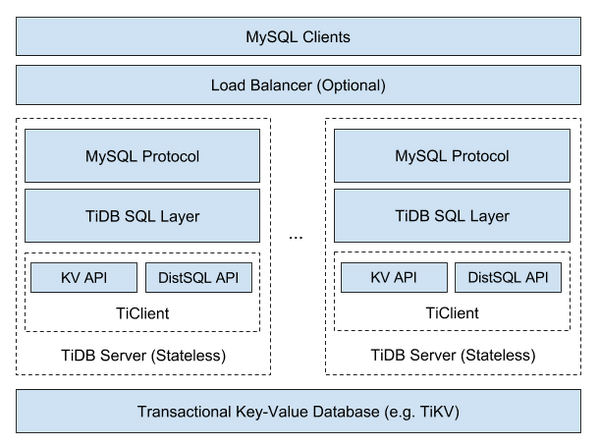

| TiDB | placement-rule、leader-count | SHOW CONFIG | 设置leader-count=3实现多活架构 |

常见问题与解决方案

Q1:发现数据分片严重不均衡怎么办?

- 诊断方法:使用

pd.store.region()(TiDB)或COLLECT LOCAL(MongoDB)统计各分片数据量。 - 解决步骤:

- 启用动态分片平衡(如Cassandra的

ALLOW COMPACTION) - 调整哈希函数或增加虚拟节点

- 手动迁移热点数据(需暂停写入)

- 启用动态分片平衡(如Cassandra的

Q2:副本同步延迟过高如何排查?

- 检查路径:

- 网络层:

ping延迟 >50ms需优化路由 - 磁盘IO:

iostat查看磁盘利用率是否饱和 - 配置项:检查

write_quorum是否设置过严

- 网络层:

- 优化方案:

- 开启增量复制(如Bulk Log Shipping)

- 分离日志存储与数据存储(使用SSD加速WAL)

- 调整

read_repair_delay参数延长修复窗口

配置管理最佳实践

- 版本化控制:所有配置变更需提交到版本库并标注变更原因。

- 灰度发布:新配置先在少量节点验证,再全集群生效。

- 自动化巡检:编写脚本定期检查

max_memory、disk_usage等关键指标。 - 配置基线管理:建立标准模板(如开发/测试/生产环境差异化配置清单)。

FAQs

Q1:分布式数据库出现脑裂问题,如何通过配置解决?

A:脑裂通常由网络分区导致,可通过以下配置缓解:

- 设置合理的

failure_detector_timeout(如15秒→30秒) - 启用

read_index隔离级别避免幻读 - 部署仲裁节点(如3节点集群增加第4个见证节点)

Q2:如何评估当前配置是否达到性能瓶颈?

A:通过以下维度分析:

- 硬件利用率:CPU>85%、磁盘IO>90%视为瓶颈

- 延迟分布:P99延迟超过业务SLA需优化

- 错误率:持续出现

TimeoutException表明网络配置需调整 - 分片状态:不平衡度>30%需