上一篇

分布式数据管理宕机的原因

- 行业动态

- 2025-05-05

- 7

分布式数据管理宕机主因包括硬件故障、网络分区、软件缺陷、负载过高及数据不一致,导致服务中断

分布式数据管理宕机的核心原因分析

分布式数据管理系统因其高可用性和扩展性被广泛应用,但在实际运行中仍可能因多种因素导致宕机,以下是导致分布式数据管理宕机的核心原因分类及具体分析:

网络问题

| 类别 | 具体原因 | 示例 | 解决方案 |

|---|---|---|---|

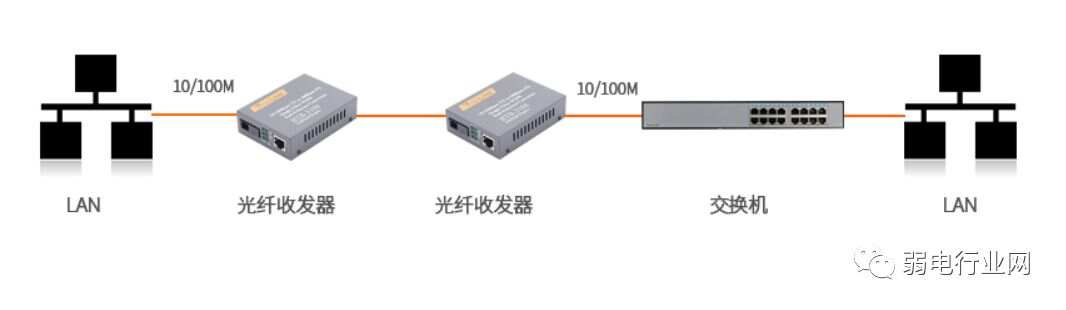

| 网络分区 | 节点间通信中断 | 数据中心光纤损坏导致区域间失联 | 部署多数据中心冗余、使用分布式一致性协议(如Raft/Paxos)实现故障转移 |

| 高延迟/抖动 | 跨地域传输延迟过高 | 跨国数据传输超时触发心跳检测失败 | 优化路由策略、部署边缘节点、采用异步复制机制 |

| 带宽瓶颈 | 突发流量超出网络承载能力 | 大规模数据同步时网络拥塞 | 限流策略、压缩数据传输、分级存储(热数据本地化) |

硬件故障

| 类别 | 具体原因 | 示例 | 解决方案 |

|---|---|---|---|

| 存储设备 | 磁盘损坏或SSD寿命耗尽 | RAID阵列中一块磁盘坏道导致数据不可读 | 定期健康检查(SMART监控)、多副本存储(如HDFS的3副本策略) |

| 服务器节点 | CPU/内存过载或电源故障 | 单节点因高温宕机导致集群任务分配失衡 | 冗余部署(如主从备份)、动态负载均衡、电源冗余(双路供电) |

| 网络设备 | 交换机/路由器硬件故障 | 核心交换机宕机引发全集群通信中断 | 网络设备冗余(如Spine-Leaf架构)、BGP协议自动切换路径 |

软件缺陷

| 类别 | 具体原因 | 示例 | 解决方案 |

|---|---|---|---|

| 代码破绽 | 未处理的异常或死锁 | 分布式事务并发冲突导致数据库锁死 | 代码审查、混沌工程测试、超时熔断机制 |

| 依赖库问题 | 第三方组件版本兼容性缺陷 | 升级后消息队列客户端与服务器协议不匹配 | 依赖冻结(Lock Dependencies)、容器化隔离(如Docker镜像固定版本) |

| 配置错误 | 参数设置不当(如内存分配过大) | Redis集群因maxmemory设置过低触发持久化失败 | 配置模板化、自动化校验工具(如Ansible Playbooks验证) |

数据一致性危机

| 类别 | 具体原因 | 示例 | 解决方案 |

|---|---|---|---|

| CAP定理限制 | 网络分区时一致性与可用性矛盾 | GEPARD算法在分区时放弃写入导致业务中断 | 根据业务场景选择CP或AP模式(如支付系统强一致性、日志系统弱一致性) |

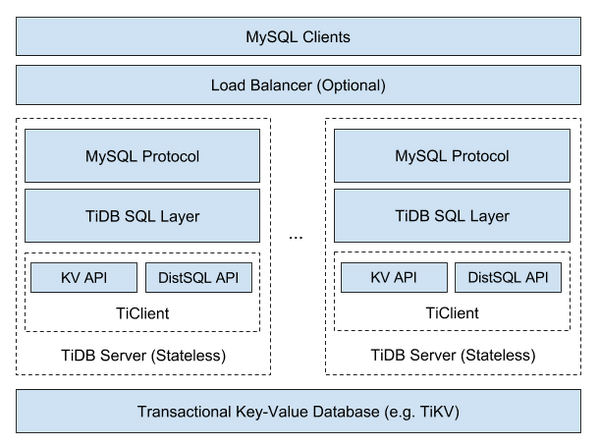

| 分布式事务失败 | 两阶段提交(2PC)超时 | 跨库更新因协调者宕机导致全局事务回滚 | 改用补偿事务(TCC)、基于消息队列的最终一致性方案 |

| 数据冲突 | 多主复制中的写入冲突 | MongoDB多节点并行修改同一文档导致版本覆盖 | 版本向量(Vector Clocks)、冲突解决策略(如Last Write Wins) |

负载与资源耗尽

| 类别 | 具体原因 | 示例 | 解决方案 |

|---|---|---|---|

| 流量激增 | 突发请求超过系统承载能力 | 电商大促期间分片数据库连接池耗尽 | 自动弹性扩容(如Kubernetes HPA)、请求排队与限流(Rate Limiting) |

| 内存泄漏 | 长时间运行服务未释放无用对象 | Kafka消费者进程因内存溢出导致宕机 | 内存监控(Prometheus+Grafana)、容器重启策略(如Pod重启内存限制) |

| 磁盘IO饱和 | 高并发写操作导致存储延迟 | Elasticsearch索引写入压力过大触发熔断 | 分片策略优化、冷热数据分层(如将冷数据迁移至对象存储) |

安全与攻击

| 类别 | 具体原因 | 示例 | 解决方案 |

|---|---|---|---|

| DDoS攻击 | 反面流量占用带宽/计算资源 | UDP洪水导致API网关瘫痪 | 流量清洗(如AWS Shield)、IP黑名单、验证码防护 |

| 数据改动 | 未授权访问或反面代码注入 | 破解改动配置文件导致集群元数据损坏 | 最小权限原则(RBAC)、审计日志(Audit Log)、代码签名验证 |

FAQs

Q1:如何预防分布式数据管理宕机?

A1:需从以下维度入手:

- 冗余设计:关键组件部署多副本(如ETCD集群至少3个节点)。

- 监控体系:实时监控网络延迟、磁盘IO、内存使用(如Prometheus+Alertmanager)。

- 自动恢复:通过Kubernetes探针(Liveness/Readiness Probe)自动重启故障容器。

- 容灾演练:定期模拟网络分区、节点宕机等场景,验证故障转移流程。

Q2:宕机后如何快速恢复数据?

A2:恢复策略包括:

- 数据重建:利用副本重新同步(如HDFS的Block Recovery机制)。

- 日志回放:通过WAL(Write-Ahead Logging)重放未完成的操作(如MySQL Binlog)。

- 流量切换:启用备用集群(如异地多活架构中的冷备节点)。

- 一致性校验:使用Hash校验或CRC校验确保数据完整性(如Ceph的Scrub