上一篇

分布式文件存储系统背景

- 行业动态

- 2025-05-04

- 2258

随数据量激增,传统集中式存储现扩展瓶颈,分布式文件存储通过分片、冗余、负载均衡等技术实现海量数据可靠

分布式文件存储系统背景解析

传统存储系统的局限性

在信息技术发展的早期阶段,企业主要依赖本地化存储方案(如单机硬盘、NAS设备或传统SAN存储阵列),这类集中式存储存在显著缺陷:

- 容量瓶颈:单台服务器存储上限受硬件限制,扩展需停机升级

- 性能天花板:并发访问时易产生IO瓶颈,难以水平扩展

- 可靠性风险:单点故障可能导致数据丢失(如RAID阵列仍存在整柜故障风险)

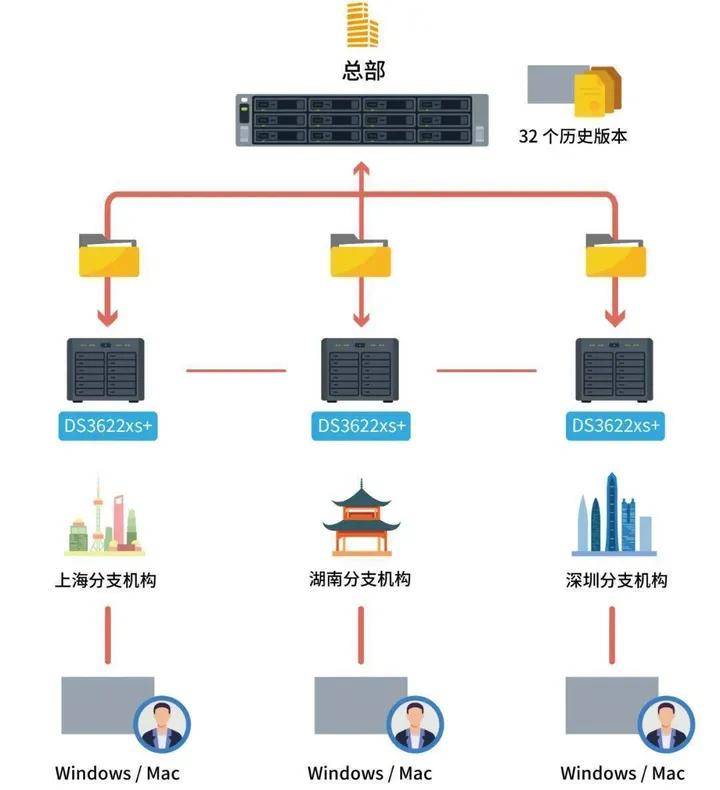

- 地理限制:数据访问受限于物理位置,多分支机构协作困难

| 对比维度 | 传统集中式存储 | 分布式文件存储 |

|---|---|---|

| 扩展方式 | 纵向扩容(硬件升级) | 横向扩展(增加节点) |

| 容错能力 | 依赖RAID等本地冗余 | 跨节点冗余(副本/纠删码) |

| 访问延迟 | 局域网内低延迟 | 支持跨地域访问(延迟可控) |

| 管理复杂度 | 中心化管理相对简单 | 需处理元数据同步/负载均衡 |

技术演进驱动因素

- 数据爆炸增长:IDC统计显示全球数据量每2年翻番,传统存储扩容成本指数级上升

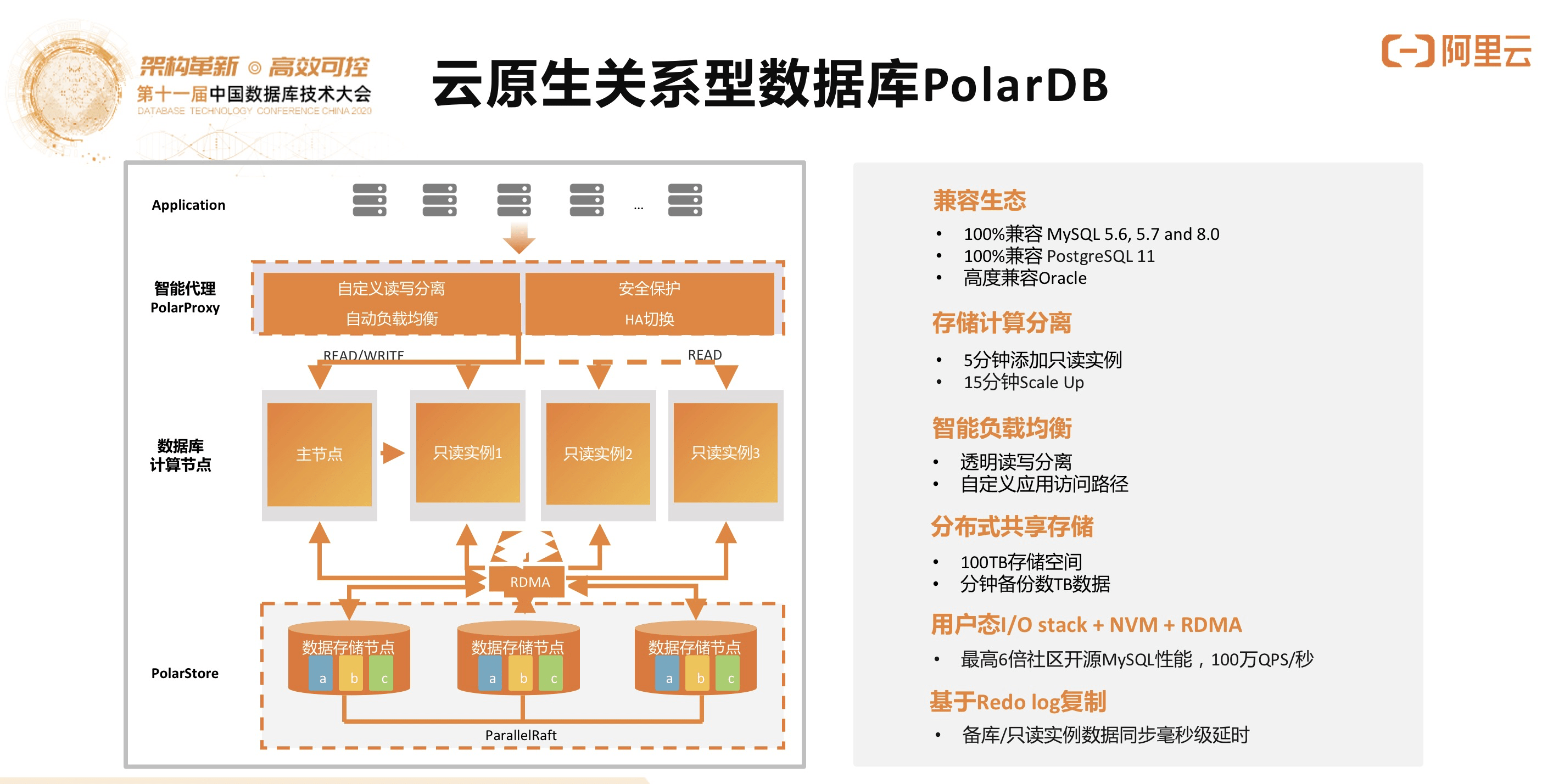

- 云计算兴起:AWS S3等对象存储证明分布式架构的可行性,推动块存储/文件存储革新

- 开源技术突破:Google GFS论文(2003)揭示分布式文件系统设计原理,Ceph(2006)、HDFS等项目相继诞生

- 硬件成本优化:普通PC服务器组成集群的成本效益远超专用存储设备

核心架构设计原理

数据分片机制

- 固定大小分块(如HDFS的128MB块)

- 动态自适应分块(如Ceph的CRUSH算法)

- 哈希取模分配(保证负载均衡)

冗余保护策略

| 冗余类型 | 特点 | 适用场景 |

|—————-|——————————-|—————————|

| 副本机制 | 简单可靠,读效率高 | 实时性要求高的场景 |

| 纠删码 | 存储效率提升(如RF=6/3) | 冷数据/成本敏感场景 |

| 混合模式 | 热数据用副本,冷数据用纠删码 | 分层存储系统 |元数据管理

- 集中式架构(如Ceph MON):存在单点瓶颈但实现简单

- 分布式架构(如GlusterFS):采用环形拓扑避免单点故障

- 新型方案(如Ceph的CRUSH map):通过算法实现动态分布

一致性模型

- 强一致性(如Quobyte):适用于数据库存储场景

- 最终一致性(如Amazon S3):适合非关键型应用

- 因果一致性(如Ceph RBD):平衡性能与数据完整性

典型应用场景

- 大数据分析平台:Hadoop生态依赖HDFS实现TB级数据处理

- 云存储服务:阿里云OSS、酷盾安全COS底层均采用分布式架构

- 分发:视频网站使用分布式存储应对高并发读写

- 备份容灾系统:金融行业通过多地冗余保障数据安全

- AI训练存储:参数服务器架构需要低延迟分布式存储支撑

关键技术挑战与解决方案

数据倾斜问题

- 现象:热点数据导致部分节点过载

- 解决方案:动态负载均衡算法(如Ceph的rebalancer模块)

元数据瓶颈

- 优化策略:

- 缓存机制(客户端缓存目录结构)

- 分级存储(Hot/Warm/Cold数据分层)

- 索引优化(B+树/LSM树结构改进)

- 优化策略:

网络带宽压力

- 缓解措施:

- 数据本地化策略(HDFS的rack-aware placement)

- 压缩传输(Ceph的RBD块压缩)

- 增量同步协议(如Rsync算法应用)

- 缓解措施:

硬件异构性

- 适配方案:

- 抽象存储层(Ceph的统一存储接口)

- 自动检测硬件特性(SSD/HDD混布优化)

- 质量感知调度(QoS-aware data placement)

- 适配方案:

发展趋势展望

- 智能存储:AI驱动的数据分类/预热/清理自动化

- 混合云存储:跨私有云/公有云的统一命名空间

- 存算一体化:近数据处理(near-data computing)架构

- 新型介质支持:针对NVMe SSD/Optane持久内存的优化

- 安全增强:零知识证明、同态加密等技术的应用

FAQs

Q1:如何选择合适的分布式文件存储系统?

A:需综合考虑以下维度:

- 数据特征:结构化/非结构化、冷热数据比例

- 性能需求:IOPS要求、延迟敏感度

- 扩展性:预期容量增长率、节点扩展方式

- 成本预算:硬件投入、运维复杂度

- 生态兼容:与现有大数据/AI平台的集成能力

建议进行POC测试,重点验证元数据性能和故障恢复能力。

Q2:分布式存储中的数据一致性如何保障?

A:主要通过三种机制:

- 版本控制:为每个数据块维护版本号/时间戳

- 冲突检测:使用分布式锁或乐观并发控制

- 日志同步:采用WAL(Write-Ahead Logging)确保操作顺序

例如Ceph通过OSD Map版本号和PG(Placement Group)日志保证强一致性,而Amazon S3则采用最终