上一篇

html网站整站抓取工具

- 行业动态

- 2025-04-28

- 3493

HTML网站整站抓取工具可自动下载网页HTML、CSS、JS及资源文件,支持完整网站镜像,适用于离线浏览、数据备份或开发测试,具备多线程爬取与链接解析能力,兼容

整站抓取工具

HTML网站整站抓取工具是指能够自动下载并保存网站所有页面(包括HTML、CSS、JS、图片等资源)的软件或脚本,其核心功能是递归爬取网页链接,构建本地镜像,适用于网站备份、数据采集、离线浏览等场景。

主流工具分类与对比

| 工具类型 | 代表工具 | 特点 |

|---|---|---|

| 桌面软件 | HTTrack、WebCopy | 可视化操作,支持多线程下载,适合新手 |

| 命令行工具 | wget、curl | 轻量级,需手动配置参数,适合批量任务 |

| 浏览器插件 | Save Page WE, SingleFile | 一键保存单页,不支持全站递归抓取 |

| 编程库/框架 | Scrapy(Python)、BeautifulSoup | 高度可定制,需编码,适合复杂抓取需求 |

核心功能对比表

| 功能项 | HTTrack | Wget | Scrapy | Octoparse |

|---|---|---|---|---|

| 协议支持 | HTTP/HTTPS | HTTP/HTTPS | HTTP/HTTPS | HTTP/HTTPS |

| 爬取深度控制 | 可设置层级 | 无 | 可自定义 | 可视化设置 |

| 动态页面处理 | 不支持 | 不支持 | 需配合Selenium | 内置浏览器渲染 |

| 导出格式 | 完整网站结构 | 原始文件 | JSON/CSV | 多种格式 |

| 反爬虫规避 | 基础模拟 | 无 | 可扩展 | 内置代理池 |

| 调度策略 | 广度优先 | 无 | 自定义 | 可视化流程 |

使用步骤(以HTTrack为例)

分析目标网站

- 检查网站地图(sitemap.xml)

- 确认需排除的链接(如外部跳转、重复内容)

配置抓取参数

- 设置域名限制(避免爬取外部链接)

- 调整线程数(默认3-5,可根据带宽调整)

- 启用Cookie/登录模拟(如需抓取登录后内容)

执行抓取

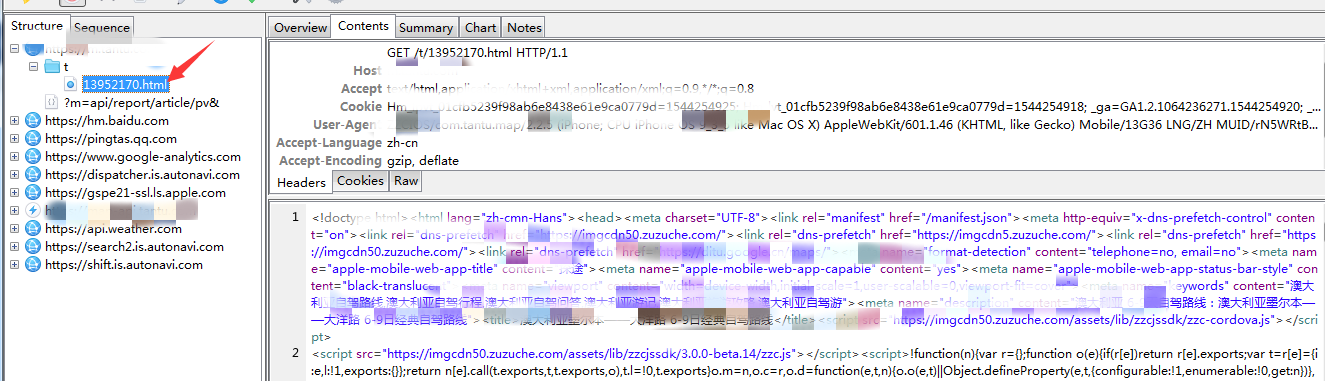

httrack "https://example.com" -O output_folder -"-" -"+.css;+.js;+.png"

处理动态内容

- 对AJAX/JS生成的内容,需结合Selenium录制浏览器操作

- 使用正则表达式过滤动态参数(如

?t=1234)

数据存储与清洗

- 按文件类型分类存储(HTML/CSS/Images分离)

- 删除冗余文件(如临时缓存、广告代码)

常见问题与解决方案

如何判断抓取深度?

- 答案:通过网站结构分析,若平均页面链接数≤5,建议设置3-4层;若链接数>10,需限制层级或设置URL正则过滤(如

^https?://(www.)?example.com/.$)。

遇到反爬虫机制如何处理?

- 答案:

- IP限制:使用代理池(如Scrapy-Proxy)或ADSL拨号

- User-Agent检测:随机生成UA(如

fake_useragent库) - 验证码/登录验证:集成OCR识别(如Tesseract)或人工打码平台

- 请求频率限制:添加随机延迟(

time.sleep(random.uniform(1,3)))

注意事项

- 法律合规性:抓取前需确认

robots.txt规则,避免侵犯版权或隐私 - 动态资源处理:CSS/JS文件中的绝对路径需转换为相对路径

- 性能优化:并发数建议控制在5-10,避免服务器封禁IP

- 数据去重:使用哈希算法(