上一篇

hdfs可以存储那些数据

- 行业动态

- 2025-05-15

- 5

HDFS适合存储大规模、流式、二进制及非结构化数据,如日志、监控数据、音视频、传感器数据、科学计算数据(基因组、气象等),但不适用于小文件或低延迟场景

HDFS(Hadoop Distributed File System)作为大数据领域的核心存储系统,其设计目标是为了处理海量非结构化或半结构化数据,以下是关于HDFS可存储数据类型的详细分析,涵盖数据格式、结构、访问模式及最佳实践。

HDFS支持的数据类型与格式

HDFS以块(Block)为单位存储数据,每个块默认128MB(可配置),适合处理大规模数据集,以下是典型支持的数据类型:

| 数据类别 | 具体格式 | 存储特点 |

|---|---|---|

| 非结构化数据 | 日志文件(Log) 视频/音频文件(MP4, WAV, etc.) 传感器数据(二进制) 图像文件(JPEG, PNG) | 直接存储原始文件,支持流式读取;适合批量处理 |

| 半结构化数据 | JSON XML AVRO CSV(逗号分隔值) | 需结合序列化工具(如Avro、Protobuf)优化存储;支持Schema演进 |

| 结构化数据 | 数据库导出文件(如MySQL .sqldump) 列式存储(Parquet, ORC) | 依赖外部工具(如Spark)进行解析;适合批处理分析 |

| 二进制数据 | 序列化文件(Protocol Buffers, Thrift) 压缩文件(ZIP, GZIP, BZIP2) | 支持透明存储;需应用层解压缩或反序列化 |

| 特殊格式 | 文本文件(.txt) Hadoop Sequence Files(Key-Value格式) | 文本文件可直接存储;Sequence Files需通过API读写 |

关键特性支持:

- 大文件优化:HDFS擅长存储GB/TB级大文件(如日志聚合、视频流),小文件因元数据开销大需合并处理。

- 容错性:通过块副本机制(默认3副本)保证数据高可用,适合存储关键业务数据。

- 可扩展性:支持横向扩展,单集群可存储PB级数据,适合企业级数据湖。

HDFS不适用的数据场景

| 场景 | 原因 |

|---|---|

| 低延迟随机读写 | HDFS为高吞吐设计,随机读写性能差(需结合HBase等组件) |

| 事务型数据库数据 | 不支持ACID特性,无法存储需要频繁更新的结构化数据(如OLTP数据库) |

| 实时流数据 | 原生HDFS延迟较高(秒级),需结合Kafka或Flume实现近实时采集 |

| 极小文件(KB级) | NameNode内存限制导致元数据压力过大,需通过合并(如Hadoop Archive)优化 |

数据存储结构与访问模式

文件存储结构

- 平面文件(Flat Files):如CSV、JSON,直接存储于HDFS,需MapReduce或Spark解析。

- 分区表:按时间、业务维度划分目录(如

/data/year=2023/month=09/),提升查询效率。 - 列式存储:Parquet/ORC格式优化压缩和查询性能,适合OLAP分析。

典型访问模式

| 场景 | 推荐工具链 |

|---|---|

| 批处理分析 | HDFS + MapReduce/Spark(离线计算) |

| 实时分析 | HDFS + Kafka(流式摄入) + Flink/Spark Streaming |

| 交互式查询 | HDFS + Presto/Impala(MPP SQL引擎) |

| 机器学习训练 | HDFS存储原始数据,配合Spark MLlib或TensorFlow On Spark |

最佳实践与优化建议

数据写入优化

- 合并小文件:使用

CombineFileInputFormat或Hadoop Archive(HAR)减少块浪费。 - 压缩存储:启用Block压缩(如LZO、Snappy)降低磁盘和网络IO。

- 分区策略:按业务逻辑(如日期、用户ID)分区,避免全局扫描。

数据管理规范

| 操作 | 建议 |

|---|---|

| 目录结构 | 采用扁平化层级(如/raw_data/、/clean_data/)避免过深路径 |

| 文件命名 | 包含时间戳和业务标识(如user_log_20230930.txt) |

| 元数据维护 | 使用Apache Atlas或Hive Metastore管理数据血缘和Schema信息 |

性能调优

- 调整块大小:大文件(如视频)可设为256MB,小文件合并后设为64MB。

- 副本策略:冷数据副本数降为2,热数据保持3副本。

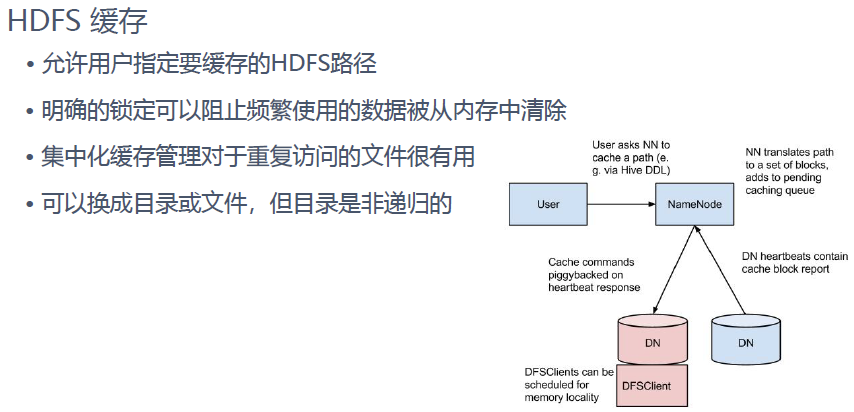

- 缓存加速:启用HDFS缓存(Client-side Cache)加速高频访问文件。

相关问答FAQs

Q1:HDFS是否支持存储小文件(如KB级日志)?

A:原生HDFS不推荐存储极小文件,因每个文件占用NameNode内存(约150字节/文件),解决方案:

- 使用

Hadoop Archive合并小文件为大归档包。 - 预聚合日志(如按小时合并)。

- 结合HBase存储随机写入的小文件。

Q2:如何实现HDFS数据的实时处理?

A:HDFS本身延迟较高(写入需等待Block上报),需结合以下方案:

- Kafka+Flume:Kafka接收实时流,Flume定时将数据批量导入HDFS。

- Flink Checkpoint:流计算结果周期性写入HDFS。

- Delta Lake/Hudi:支持流批一体,提供近实时湖存储能力。

HDFS是海量数据的可靠存储基石,适用于大文件、批处理场景,需结合生态工具(如Hive、Spark)发挥最大价值,理解其数据适配边界,可有效构建高效的大数据存储架构