hive导入hdfs数据库

- 行业动态

- 2025-05-14

- 1

将本地数据上传至HDFS后,通过 Hive执行

LOAD DATA命令加载HDFS路径数据到表,或创建外部表直接映射HDFS数据源,实现Hive与

Hive导入HDFS数据库的详细操作指南

Hive与HDFS的关系

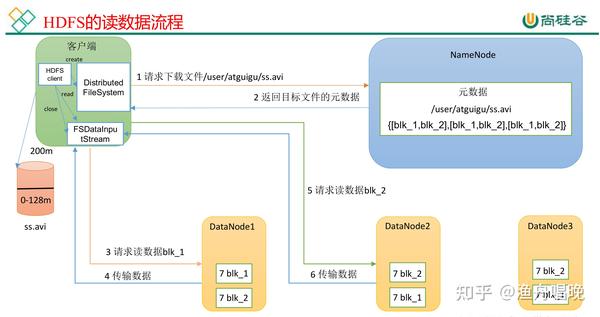

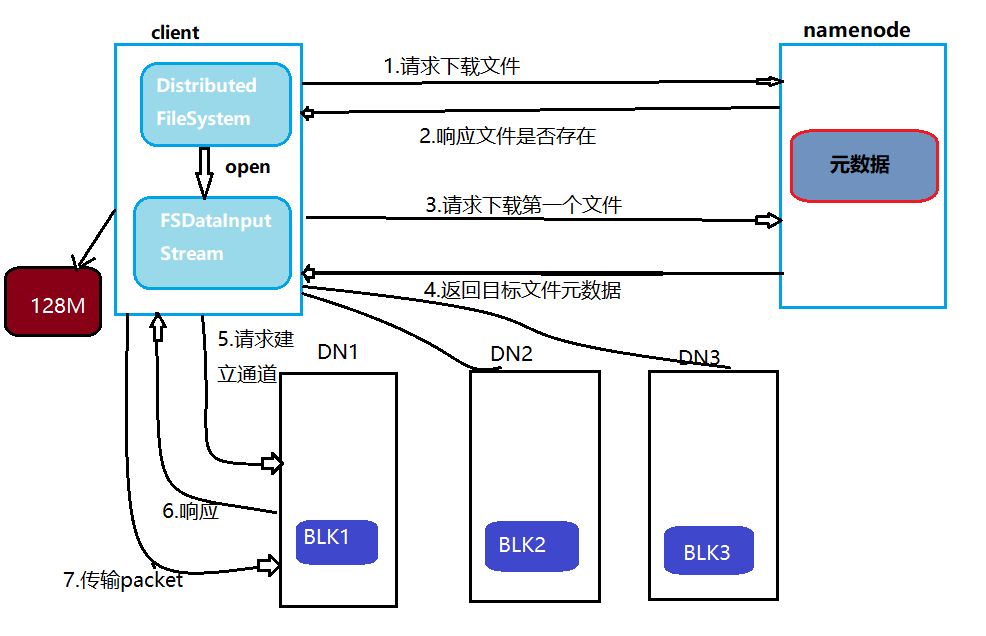

Hive是基于Hadoop生态系统的分布式数据仓库工具,其核心功能是对存储在HDFS(Hadoop Distributed File System)中的数据进行结构化管理和分析,HDFS作为Hadoop的底层存储系统,负责存储海量数据,而Hive通过定义元数据(如表结构、分区信息)实现对HDFS数据的SQL式操作,两者的协同关系如下:

| 组件 | 功能定位 |

|---|---|

| HDFS | 分布式存储系统,存储原始数据文件(如CSV、JSON、Parquet等格式) |

| Hive | 数据仓库层,提供SQL查询接口,管理HDFS中数据的元数据和计算逻辑 |

Hive导入HDFS数据的核心场景

从HDFS加载已有数据到Hive表

适用于HDFS中已存在的数据文件(如日志、业务数据),需通过Hive定义表结构并关联数据。Hive写入数据到HDFS

通过Hive的INSERT或CREATE TABLE语句将处理后的数据存储为HDFS文件。

前置条件准备

环境依赖

- Hadoop集群正常运行,HDFS服务可用

- Hive服务已部署并与HDFS完成集成配置

- 用户具备HDFS和Hive的访问权限

数据兼容性检查

- 确认HDFS中的数据格式(如分隔符、编码、字段顺序)

- 验证数据文件是否支持Hive的存储格式(如Text、Parquet、ORC等)

权限配置

- 确保Hive用户对目标HDFS目录具有读写权限

- 配置Hive的

fs.defaultFS参数指向正确的HDFS地址

Hive导入HDFS数据的操作步骤

创建Hive表并关联HDFS数据

-创建内部表(数据会从HDFS目录移动到Hive默认仓库)

CREATE TABLE user_logs (

uid STRING,

url STRING,

timestamp TIMESTAMP

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY 't'

STORED AS TEXTFILE

LOCATION '/user/hive/warehouse/user_logs'; -指定HDFS路径

-创建外部表(数据保留在原始HDFS路径)

CREATE EXTERNAL TABLE external_user_logs (

uid STRING,

url STRING,

timestamp TIMESTAMP

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY 't'

LOCATION '/data/raw/user_logs'; -原始数据存放位置加载HDFS数据到Hive表

方式1:直接加载现有数据

LOAD DATA INPATH '/data/raw/user_logs/2023-10-01' INTO TABLE user_logs; -适用于内部表或分区表

方式2:通过查询导入

INSERT INTO TABLE user_logs_partitioned SELECT FROM external_user_logs WHERE timestamp >= '2023-10-01';

动态分区表导入(按日期分区示例)

-创建分区表

CREATE TABLE user_logs_partitioned (

uid STRING,

url STRING,

timestamp TIMESTAMP

)

PARTITIONED BY (date STRING)

STORED AS ORC;

-加载数据并自动创建分区

INSERT INTO TABLE user_logs_partitioned PARTITION (date)

SELECT uid, url, timestamp, date_format(timestamp, 'yyyy-MM-dd') as date

FROM external_user_logs;数据格式与存储优化

| 文件格式 | 特点 | 适用场景 |

|---|---|---|

| Text | 纯文本,易兼容但查询效率低 | 小规模数据或临时处理 |

| Parquet | 列式存储,支持压缩和投影优化 | 大数据分析与长期存储 |

| ORC | 专为Hive优化,高压缩比与查询性能 | 复杂查询与生产环境 |

| Avro | 支持Schema演化,适合动态数据结构 | 日志流或半结构化数据 |

优化建议:

- 对大规模数据优先使用列式存储(Parquet/ORC)

- 开启压缩(如Snappy、Zlib)减少存储空间

- 合理设计分区字段(如按日期、地区分区)提升查询效率

常见问题与解决方案

数据加载后无法查询

- 原因:

- 文件格式与表定义不匹配(如分隔符错误)

- HDFS路径权限不足

- 数据文件包含隐藏字符或特殊格式

- 解决:

- 使用

DESCRIBE FORMATTED检查表结构与数据一致性 - 通过

hdfs dfs -ls验证文件权限和路径正确性 - 预处理数据(如去除空格、转换编码)

- 使用

分区表导入失败

- 原因:

- 分区字段未在

PARTITIONED BY中声明 - HDFS目录结构不符合分区规则(如

date=2023-10-01层级缺失)

- 分区字段未在

- 解决:

- 确保分区字段与目录层级严格对应

- 使用

MSCK REPAIR TABLE修复元数据与数据分区的映射

实战案例:电商订单数据导入

场景:将HDFS中的CSV订单数据(/data/orders/)导入Hive分区表,按日期分区。

创建分区表

CREATE TABLE orders_partitioned ( order_id BIGINT, user_id STRING, product_id STRING, amount DOUBLE, order_time TIMESTAMP ) PARTITIONED BY (order_date STRING) STORED AS ORC LOCATION '/data/orders/processed';加载数据并自动分区

INSERT INTO TABLE orders_partitioned PARTITION (order_date) SELECT order_id, user_id, product_id, amount, order_time, date_format(order_time, 'yyyy-MM-dd') as order_date FROM external_orders_raw; -假设原始数据为外部表验证数据

SELECT FROM orders_partitioned WHERE order_date = '2023-10-01' LIMIT 10;

FAQs(常见问题解答)

Q1:如何将非结构化数据(如JSON)导入Hive?

A1:需定义表时指定ROW FORMAT为SERDE,

CREATE TABLE json_logs (

uid STRING,

event STRING,

props MAP<STRING, STRING>

)

ROW FORMAT SERDE 'org.apache.hive.hcatalog.data.JsonSerDe'

LOCATION '/data/json/logs';Hive会自动解析JSON字段,但需确保数据格式规范。

Q2:导入数据后Hive元数据与HDFS数据不一致怎么办?

A2:使用MSCK REPAIR TABLE命令修复元数据:

MSCK REPAIR TABLE orders_partitioned;

该命令会扫描HDFS目录并同步分区信息到Hive元数据库,若数据文件位置错误,需手动移动文件或调整表的LOCATION路径