上一篇

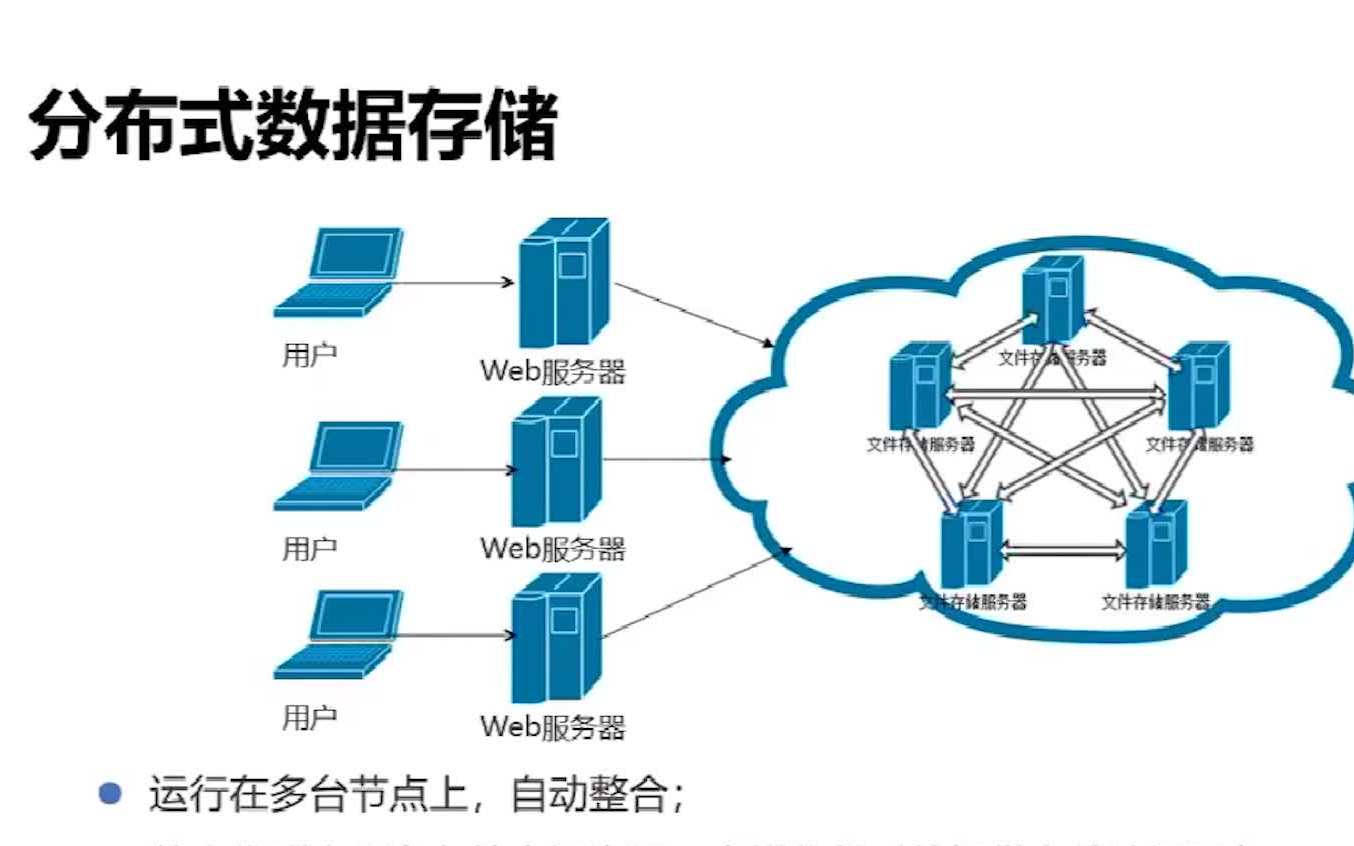

分布式存储系统相关技术

- 行业动态

- 2025-05-14

- 1

分布式存储通过数据分片、复制及一致性哈希,结合冗余编码与分布式文件系统,实现高可用与扩展

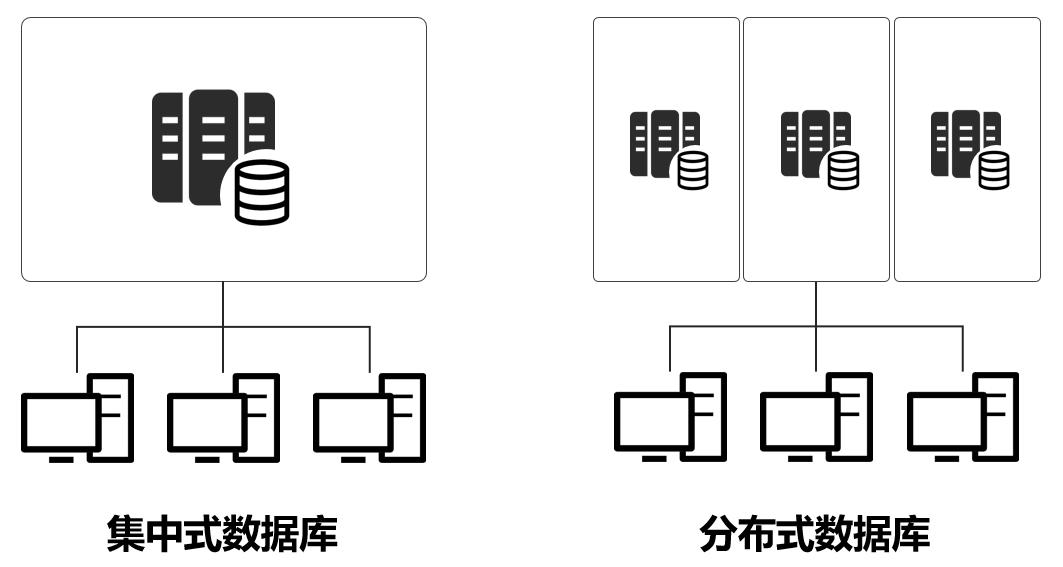

分布式存储架构分类

| 架构类型 | 特点 | 适用场景 |

|---|---|---|

| 集中式元数据 | 单一元数据服务器管理全局元数据,数据分片存储于多个节点 | 小规模集群,低延迟要求场景 |

| 去中心化元数据 | 采用分布式算法(如Raft)管理元数据,无单点故障 | 大规模集群,高可用需求场景 |

| 对象存储 | 基于HTTP协议,存储非结构化数据(如图片、视频),支持扁平化命名空间 | 云存储、大数据分析 |

| 块存储 | 提供原始存储空间,支持精细化权限控制,常用于虚拟机磁盘映射 | 虚拟化平台、数据库底层存储 |

| 文件存储 | 兼容传统文件系统协议(如NFS、SMB),支持目录结构与文件操作 | 企业级文件共享、媒体处理 |

核心技术组件

数据分片(Sharding)

- 哈希分片:通过一致性哈希算法(如Virtual Node)将数据均匀分布到节点,减少扩容时的数据迁移量。

- 范围分片:按数据特征(如时间、ID区间)划分分片,适合范围查询场景。

- 分片策略对比:

| 策略 | 数据均衡性 | 扩容成本 | 查询效率 |

|————|————|———-|—————-|

| 哈希分片 | 高 | 低 | 依赖全表扫描 |

| 范围分片 | 中 | 高 | 支持范围查询 |

数据复制与冗余

- 副本机制:每个分片存储多份副本(如3副本),通过心跳检测实现故障转移。

- 纠删码(Erasure Coding):将数据分割为K个块并生成M个校验块,可容忍M个节点故障,存储效率比副本高(如HDFS采用6+3纠删码)。

- 冷热数据分层:高频访问数据使用SSD存储,低频数据下沉至HDD或对象存储。

一致性协议

- 强一致性:通过Paxos/Raft协议确保写操作在多数节点确认后才返回成功(如etcd、ZooKeeper)。

- 最终一致性:允许短暂数据不一致,通过版本合并(如DynamoDB的Vector Clocks)解决冲突。

- BASE理论:牺牲强一致性以提升可用性,适用于社交媒体等非关键业务。

元数据管理

- 分布式元数据服务:采用Raft协议选举Leader节点,Follower同步元数据变更(如Ceph的MON集群)。

- 元数据加速:引入缓存(如Redis)或本地内存数据库减少元数据访问延迟。

容错与恢复机制

| 故障类型 | 应对策略 |

|---|---|

| 节点故障 | 副本自动切换、触发数据再平衡 |

| 网络分区 | 基于CAP定理选择CP或AP模式(如Consul在网络分区时保持读写可用性) |

| 数据丢失 | 通过校验码或跨机房备份恢复数据 |

| 脑裂问题 | 使用仲裁机制(如Quorum法定多数节点决策)避免双主冲突 |

性能优化技术

- 数据局部性优化:计算任务优先访问本地节点数据,减少跨节点通信(如Hadoop的Data Locality)。

- 并行写入:将大文件拆分为多个Block并行上传,提升吞吐量(如Amazon S3的Multipart Upload)。

- 缓存加速:使用LRU缓存热点数据,或部署边缘缓存节点(如CDN节点)。

- 压缩与去重:对温冷数据进行重删除重复数据(Deduplication)和压缩(如ZFS的可变块压缩)。

典型挑战与解决方案

| 挑战 | 解决方案 |

|---|---|

| CAP定理权衡 | 选择CP模式(如银行交易)或AP模式(如社交平台) |

| 数据倾斜 | 动态分片调整、哈希打散键值分布 |

| 扩缩容一致性 | 增量数据迁移(如MySQL的Online Resharding) |

| 多租户隔离 | 使用命名空间(Namespace)或资源配额(Quota)限制 |

应用场景与代表系统

| 场景 | 代表系统 | 技术亮点 |

|---|---|---|

| 云对象存储 | Amazon S3、MinIO | 扁平化命名空间、RESTful API、无限扩展 |

| 大数据存储 | HDFS、Ceph | 高吞吐顺序写、PB级容量支持 |

| 数据库存储引擎 | Cassandra、TiKV | 水平扩展、低延迟读写、事务支持 |

| 容器存储 | Rook/Ceph、Portworx | 动态卷供给、状态持久化、多集群联邦 |

FAQs

Q1:如何选择强一致性还是最终一致性?

答:关键业务(如金融交易)需强一致性,通过Raft协议保证数据正确性;互联网应用(如点赞计数)可采用最终一致性提升性能,需根据业务容忍度权衡。

Q2:分布式存储扩容时如何处理数据迁移?

答:采用一致性哈希实现最小化迁移(仅影响边缘分片),或使用增量复制技术(如Ceph的OSD Map渐进