上一篇

分布式存储系统管理运维模拟

- 行业动态

- 2025-05-13

- 2

分布式存储系统管理运维模拟通过实时监控资源及故障、保障数据冗余与自动恢复、优化负载并定期

分布式存储系统管理运维模拟详解

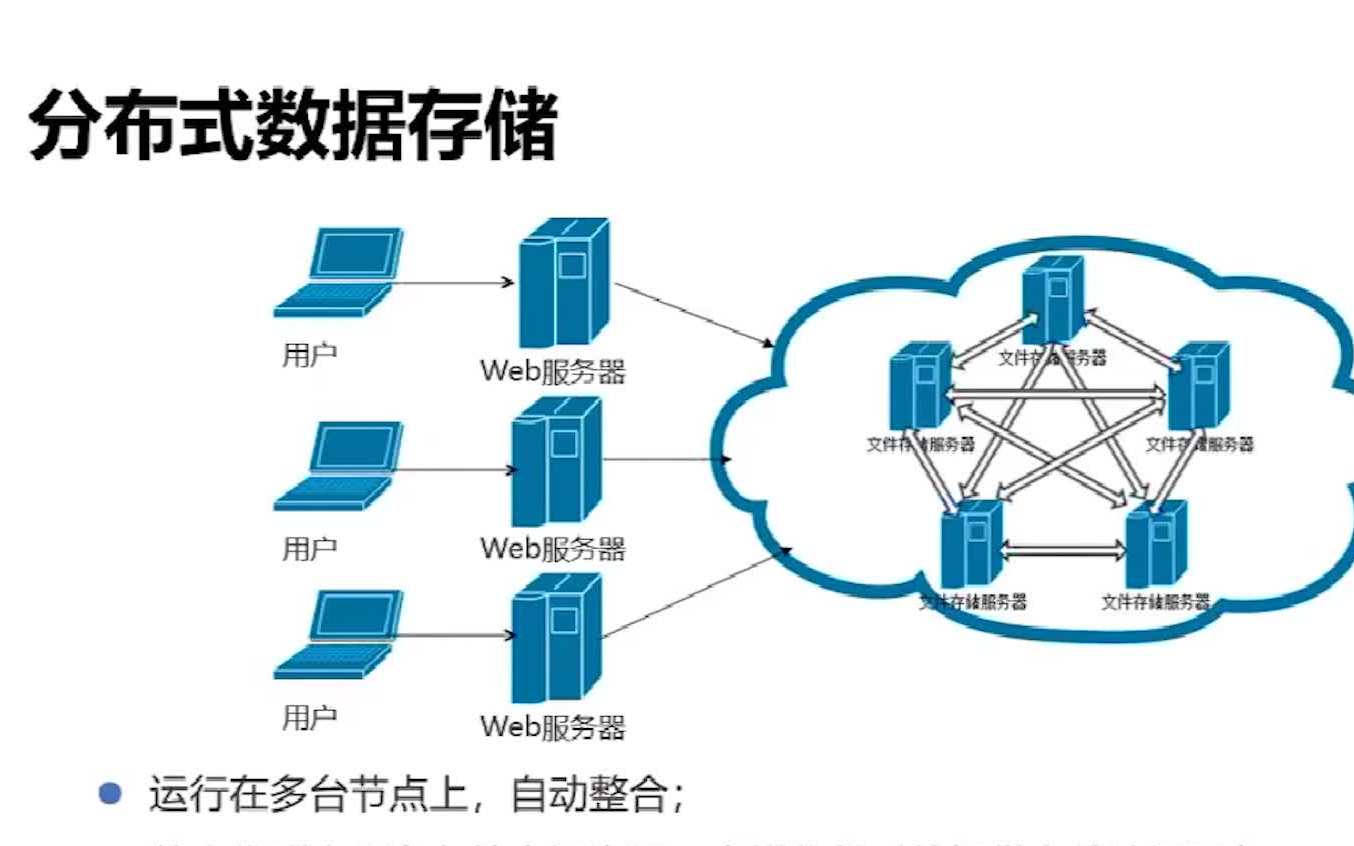

分布式存储系统是现代数据中心的核心基础设施,其管理运维的复杂性远超传统存储架构,通过模拟环境对运维流程进行验证和优化,已成为提升系统可靠性的重要手段,本文将从架构设计、运维挑战、模拟工具三个维度展开分析,并提供可落地的实践方案。

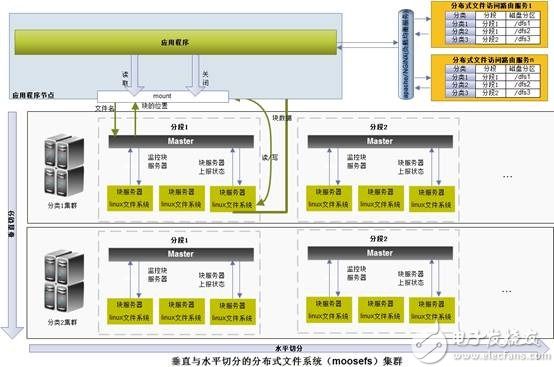

分布式存储系统核心架构

典型的分布式存储系统由以下模块构成:

| 组件类型 | 功能说明 | 模拟要点 |

|---|---|---|

| 存储节点 | 数据分片存储 | 模拟硬盘故障/网络分区 |

| 元数据服务 | 目录索引管理 | 模拟元数据锁争用 |

| 客户端SDK | 数据读写接口 | 模拟高并发访问压力 |

| 监控中心 | 状态采集分析 | 模拟指标异常告警 |

| 协调服务 | 集群状态同步 | 模拟节点选举延迟 |

关键技术特性

- 数据分片机制:采用哈希取模或范围分片算法,需模拟分片不均衡场景

- 副本策略:3副本/纠删码模式切换测试

- 一致性协议:Raft/Paxos算法实现模拟

- 故障检测:心跳间隔、选举超时参数调优

运维模拟关键场景

硬件故障模拟

- 磁盘故障:注入坏道错误(BIT Error)、延迟升高(Latency Injection)

- 网络异常:模拟带宽限制(10Mbps→100Mbps波动)、包丢失(0.1%→5%)

- 节点宕机:随机关闭存储节点,观察数据恢复时间

数据一致性挑战

| 场景类型 | 模拟方法 | 观测指标 |

|---|---|---|

| 网络分区 | 切断区域间网络 | 数据收敛时间 |

| 脑裂现象 | 制造双主节点 | 数据冲突次数 |

| 版本回退 | 强制时间戳回滚 | 数据覆盖量 |

性能压测模型

构建多维度压力测试矩阵:

# 示例压测参数组合

stress_test_matrix = {

"io_depth": [1, 16, 64], # 并发深度

"block_size": [4k, 64k], # 数据块大小

"client_count": [10, 50], # 客户端数量

"workload": ["rand_read", "seq_write"], # 负载类型

}运维模拟工具链

开源模拟器

- Minio+MinIO Client:对象存储仿真环境

- Ceph-qa-suite:Ceph集群自动化测试框架

- Yahoo! CloudService:分布式系统模拟器

自建模拟平台

| 组件 | 技术选型 | 功能 |

|---|---|---|

| 故障注入 | Chaos Engineering Kit | 磁盘/网络故障模拟 |

| 监控采集 | Prometheus+Grafana | 实时指标可视化 |

| 负载生成 | Fio+BenchmarkFX | 多协议压测 |

| 日志分析 | ELK Stack | 异常行为检测 |

典型运维流程模拟

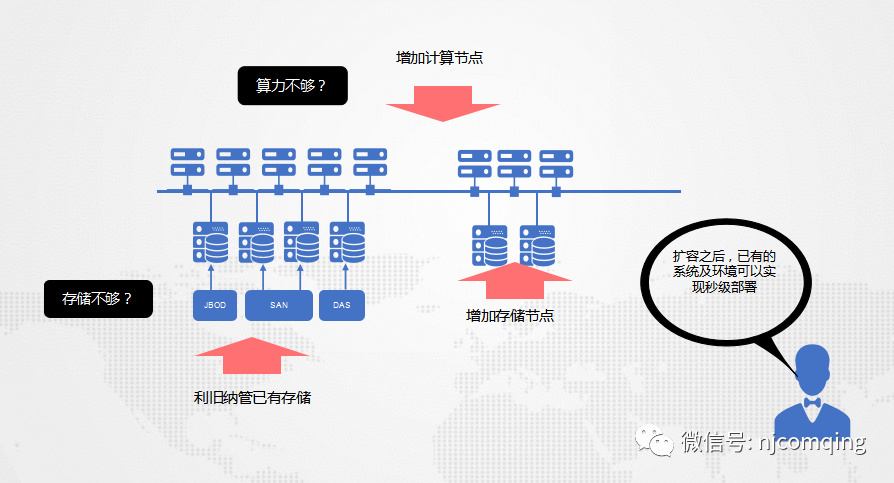

扩容演练

# 模拟新增节点流程 ./simulate_scale_out.sh --new_nodes 3 --data_rebalance # 验证数据迁移完整性 md5sum /data/block_ > pre_scale.md5 # 触发自动平衡机制

数据恢复测试

| 故障类型 | 恢复方式 | 成功标准 |

|---|---|---|

| 单节点离线 | 自动副本重建 | <60秒完成 |

| 机架级故障 | 跨机架恢复 | 数据可用性>99.9% |

| 位腐败 | 校验码修复 | 修复成功率100% |

版本升级回滚

graph TD

A[当前版本v1.0] --> B{升级v1.1}

B -->|成功| C[运行验证]

B -->|失败| D[回滚操作]

D --> E[版本一致性检查]

E --> F[服务恢复]运维指标监控体系

构建三级监控体系:

- 基础层:CPU/内存/磁盘IO(阈值:磁盘队列>8)

- 应用层:QPS/P99延迟/RPC重试率(健康标准:重试<1%)

- 业务层:SLA达标率/数据新鲜度(目标:99.99%可用性)

常见问题诊断矩阵

| 异常现象 | 可能原因 | 处理方案 |

|---|---|---|

| 写入毛刺 | 副本同步延迟 | 调整ACK策略 |

| 读取超时 | 热点数据分布不均 | 增加缓存层 |

| 空间膨胀 | 删除标记未清理 | 启动垃圾回收 |

FAQs

Q1:如何验证分布式存储系统的容灾能力?

A:应构建多层级故障模拟方案:

- 单点故障:随机关闭存储节点,观察自动恢复机制

- 机架级故障:模拟整个机架断网,验证跨机架冗余

- 数据中心级故障:切断整个可用区网络,测试异地多活架构

- 数据损坏:注入位翻转错误,检验校验码修复能力

建议使用混沌工程工具(如Chaos Monkey)进行自动化测试,记录RTO/RPO指标。

Q2:分布式存储扩容时如何保证业务不中断?

A:遵循渐进式扩容原则:

- 预先检查集群健康状态(无待修复数据)

- 分批添加新节点(每次不超过总容量10%)

- 启用数据平衡前设置限速(如限制到10MB/s)

- 监控迁移过程的关键指标:

- 源节点负载波动<20%

- 网络带宽利用率<80%

- 延迟抖动<5ms

- 完成后执行数据完整性校验