分布式数据采集常见问题及解决方法

- 行业动态

- 2025-05-11

- 1

分布式数据采集常见问题及解决方法

数据一致性问题

问题描述:分布式系统中,多个节点采集的数据可能存在时间戳差异、重复数据或数据冲突,导致全局数据不一致。

常见原因:

- 节点间时钟不同步(如NTP时间偏差)。

- 网络延迟导致数据到达顺序错乱。

- 数据去重逻辑不完善,导致重复写入。

解决方法:

| 方案 | 实现方式 | 适用场景 |

|——————-|—————————————————————————–|———————————-|

| 强一致性协议 | 使用Raft、Paxos等共识算法确保数据一致,但会牺牲部分性能。 | 对数据准确性要求极高的金融场景 |

| 最终一致性 | 允许短期不一致,通过异步同步机制(如Kafka)逐步对齐数据。 | 实时性要求高但容忍短暂延迟的场景 |

| 时间戳校准 | 部署NTP服务或使用逻辑时钟(如Lamport Clock)标记数据顺序。 | 跨数据中心的分布式系统 |

| 去重与冲突解决 | 基于唯一标识(如UUID)去重,或采用版本控制(如乐观锁)解决冲突。 | 日志采集、用户行为追踪系统 |

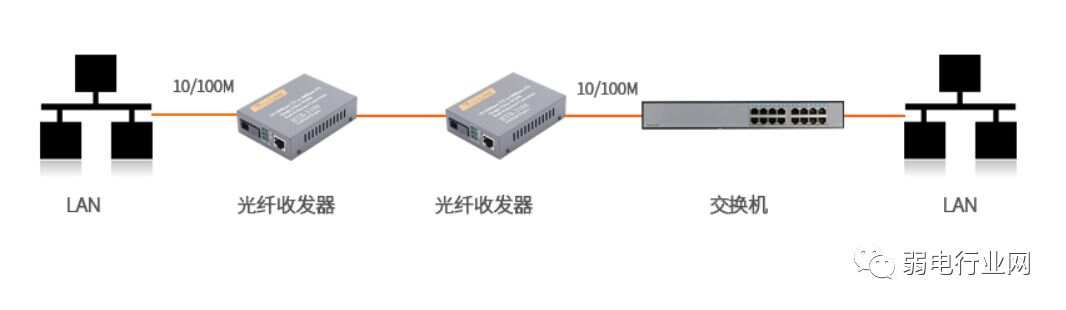

网络延迟与带宽瓶颈

问题描述:大规模数据采集时,节点间网络传输延迟高、带宽不足,导致数据丢失或延迟。

常见原因:

- 数据采集频率过高,超出网络承载能力。

- 未压缩数据传输,占用过多带宽。

- 跨地域传输未优化路由。

解决方法:

| 优化方向 | 具体措施 |

|——————-|———————————————————————————|

| 数据压缩 | 使用Protobuf、Snappy等轻量级协议压缩数据,减少传输体积。 |

| 批量传输 | 将高频次数据合并为批次(如每秒发送一次),降低网络请求次数。 |

| 边缘计算 | 在靠近数据源的节点预处理数据(如过滤、聚合),仅传输关键信息。 |

| 智能路由 | 基于网络拓扑动态选择最优路径(如使用SD-WAN技术),或部署本地缓存代理(如Redis)。 |

节点故障与容错

问题描述:分布式节点可能因硬件故障、网络中断或进程崩溃导致数据采集中断。

常见原因:

- 单点故障设计,缺乏冗余机制。

- 故障检测不及时,恢复周期长。

解决方法:

| 策略 | 实现方式 |

|——————-|—————————————————————————–|

| 主从备份 | 每个节点配置主备实例,主节点故障时自动切换至备节点。 |

| 心跳检测 | 通过ZooKeeper、Consul等工具实时监控节点状态,快速触发故障转移。 |

| 数据持久化 | 将采集数据同步写入本地磁盘或分布式存储(如HDFS),避免内存数据丢失。 |

| 熔断与降级 | 当节点故障率超过阈值时,暂时停止任务分配,优先保障核心节点运行。 |

数据倾斜与负载均衡

问题描述:部分节点因数据量过大成为瓶颈,导致整体采集效率下降。

常见原因:

- 数据源分布不均(如某些区域用户活跃度高)。

- 哈希分片策略不合理,未均匀分配负载。

解决方法:

| 优化手段 | 技术实现 |

|——————-|—————————————————————————–|

| 一致性哈希 | 使用虚拟节点(Virtual Node)平滑数据分布,避免单一节点过载。 |

| 动态负载均衡 | 基于节点CPU、内存使用率实时调整任务分配(如Kubernetes的HPA自动扩缩容)。 |

| 数据预处理 | 在采集端执行轻量级过滤(如正则匹配、阈值判断),减少无效数据传输。 |

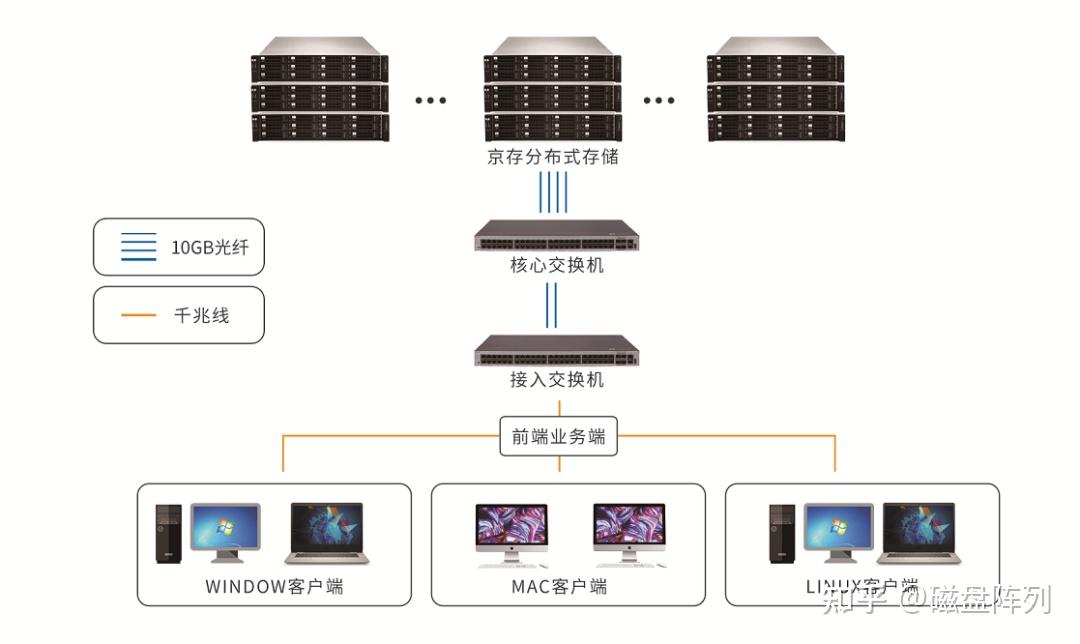

存储与计算资源瓶颈

问题描述:海量数据采集后,存储和计算资源不足,导致处理延迟或系统崩溃。

常见原因:

- 存储介质性能差(如传统机械硬盘)。

- 计算任务与存储耦合,资源竞争严重。

解决方法:

| 优化方案 | 实施步骤 |

|——————-|—————————————————————————–|

| 存算分离架构 | 将数据采集与存储解耦,使用独立集群处理计算任务(如Spark on Yarn)。 |

| 冷热数据分层 | 高频访问数据使用SSD,低频数据转入HDD或对象存储(如AWS S3)。 |

| 流批一体处理 | 通过Flink等引擎统一处理实时流数据与批量历史数据,复用计算资源。 |

时钟同步与时序数据问题

问题描述:分布式节点时钟不一致,导致时间戳混乱,影响时序数据分析(如监控告警、回溯)。

常见原因:

- 依赖本地时钟,未统一校准。

- 数据传输延迟导致时间戳偏移。

解决方法:

| 解决方案 | 技术选型 |

|———————|—————————————————————————–|

| NTP服务 | 部署NTP Server并强制同步所有节点时钟,误差控制在毫秒级。 |

| PTP协议 | 使用Precision Time Protocol(如IEEE 1588)实现亚毫秒级同步,适用于工业场景。 |

| 逻辑时间戳 | 采用Lamport Clock或Google Dapper的全局逻辑时钟,避免依赖物理时间。 |

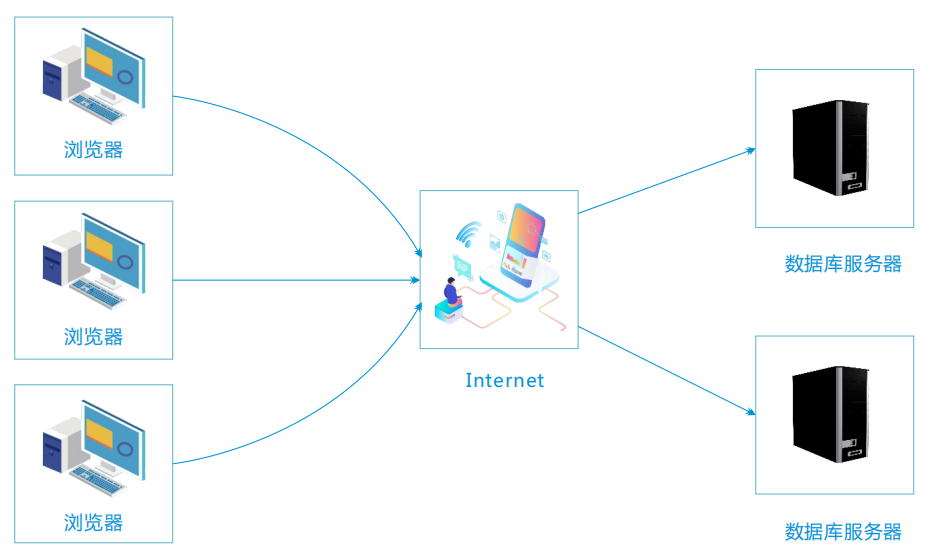

数据安全与隐私保护

问题描述:数据传输过程中可能被窃取或改动,敏感信息泄露风险高。

常见原因:

- 未加密传输(如明文HTTP)。

- 权限管理缺失,非规节点可接入系统。

解决方法:

| 防护措施 | 技术实现 |

|———————|—————————————————————————–|

| TLS加密 | 使用HTTPS/TLS协议加密传输,配合证书校验防止中间人攻击。 |

| 数据脱敏 | 在采集端对敏感字段(如手机号、身份证号)进行哈希或掩码处理。 |

| 访问控制 | 基于RBAC模型限制节点权限,结合JWT令牌认证。 |

监控与运维挑战

问题描述:分布式系统规模大,故障定位困难,缺乏统一监控指标。

常见原因:

- 日志分散存储,难以集中分析。

- 监控工具未覆盖关键链路(如网络、磁盘IO)。

解决方法:

| 工具与策略 | 实践建议 |

|———————|—————————————————————————–|

| 统一监控平台 | 使用Prometheus+Grafana采集节点指标(CPU、内存、流量),设置告警规则。 |

| 分布式追踪 | 通过Jaeger、Zipkin跟踪数据流转路径,定位延迟瓶颈。 |

| 日志聚合 | 将节点日志推送至ELK Stack(Elasticsearch+Logstash+Kibana)统一分析。 |

FAQs(常见问题解答)

Q1:如何选择适合的分布式数据采集框架?

A1:需根据业务需求评估以下因素:

- 实时性要求:Flume适合低延迟日志采集,Kafka适合高吞吐量场景。

- 数据源类型:数据库增量同步可选Debezium,文件系统采集可用Chunked上传。

- 生态兼容性:需与现有存储(如HDFS、S3)、计算引擎(如Spark)无缝对接。

建议通过压力测试和成本分析(如开源VS商业组件)综合决策。

Q2:如何处理高并发下的数据丢失问题?

A2:可采取以下组合策略:

- 可靠传输协议:使用TCP替代UDP,或基于ACK确认机制(如RabbitMQ持久化消息)。

- 本地缓冲:在采集端部署本地队列(如RocksDB),断网时暂存数据。

- 幂等写入:通过唯一ID(如UUID)确保重复数据不会被墙存储层。

- 监控告警:配置Prometheus监控消息积压量,触发自动扩容或人工干预