分布式数据存储倾斜快速检测

- 行业动态

- 2025-05-09

- 7

分布式数据存储倾斜快速检测方法与实践

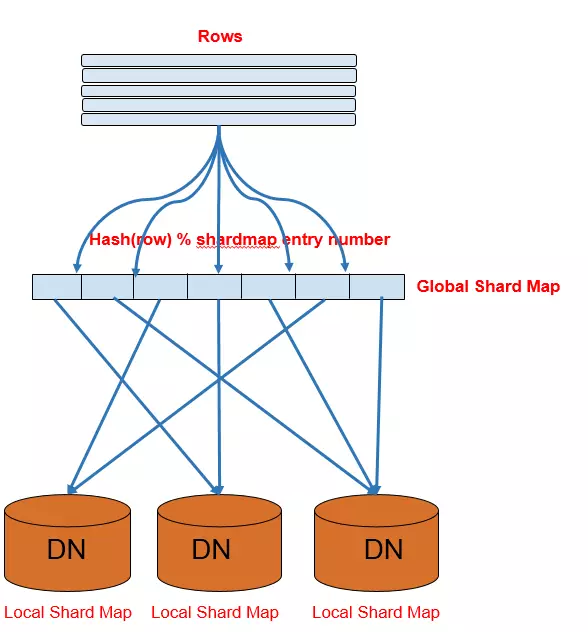

在分布式存储系统中,数据倾斜是指数据在多个存储节点上的分布不均衡,导致部分节点负载过高而其他节点处于空闲状态,这种现象会显著降低系统整体性能,甚至引发节点故障或服务中断,如何快速检测数据倾斜并采取纠正措施,是保障分布式存储系统稳定性和高效性的关键。

数据倾斜的典型表现与影响

| 现象 | 具体表现 |

|---|---|

| 节点负载不均 | 部分节点CPU、磁盘IO、网络带宽接近饱和,其他节点资源利用率低 |

| 数据分布失衡 | 某些分区的数据量远超平均值,例如10%节点存储了90%的数据 |

| 查询延迟波动 | 涉及高负载节点的查询响应时间显著延长,影响用户体验 |

| 系统扩展困难 | 新增节点后数据无法自动均衡,需人工干预 |

影响范围:

- 性能瓶颈:高负载节点成为系统吞吐量的“天花板”

- 硬件损耗:长期过载可能导致磁盘损坏或节点宕机

- 成本浪费:闲置节点的资源未被有效利用

- 数据可靠性风险:单点故障概率增加

快速检测数据倾斜的核心方法

实时监控与指标分析

通过监控系统采集以下关键指标,结合阈值告警快速定位异常:

| 指标类别 | 典型指标 | 告警阈值示例 |

|——————–|——————————————|————————————-|

| 负载类 | CPU利用率、磁盘IOPS、网络带宽 | CPU>85%持续1分钟,磁盘IOPS>10k/s |

| 数据分布类 | 分区数据量、文件数量、存储空间占比 | 某节点存储量>均值2倍 |

| 访问热度类 | 读写请求频率、热点Key分布 | 单个分区的QPS>全局均值5倍 |

工具支持:

- Prometheus+Grafana:实时采集并可视化节点负载

- Elasticsearch:存储日志并分析访问热点

- 自定义脚本:通过API定期拉取分区元数据(如HDFS的

fsck命令)

采样统计分析

对大规模数据集群,全量扫描耗时较长,可通过采样加速检测:

- 随机采样:按比例抽取分区元数据(如Spark RDD的

sample()方法) - 跳层采样:在HBase等系统中跳过中间层,仅统计首尾Region的数据量

- 时间窗口采样:对比不同时间段的数据分布变化(如每小时统计一次)

示例:

# 伪代码:计算分区数据量标准差

def detect_skew(partition_sizes):

mean = sum(partition_sizes)/len(partition_sizes)

stddev = (sum((x-mean)2 for x in partition_sizes)/len(partition_sizes))0.5

return stddev > mean 0.5 # 标准差超过均值50%则判定为倾斜对比分析法

通过横向对比不同维度的数据分布,识别异常节点:

- 节点间对比:比较所有节点的存储量、请求量分布

- 历史趋势对比:当前数据分布与历史基线的差异(如使用LSTM预测模型)

- 业务维度对比:按用户ID、地域、业务类型等标签统计分布

工具支持:

- Pandas/DataFrame:快速计算分组统计与分布差异

- Jupyter Notebook:交互式数据分析与可视化

自动化检测工具

集成以下工具实现自动化检测:

| 工具类型 | 代表工具 | 功能特点 |

|——————–|——————————————-|———————————————–|

| 系统内置工具 | HDFSBalancer、Ceph CRUSH Map | 基于策略自动平衡数据分布 |

| 开源监控平台 | Nagios+Check_MK、Zabbix | 自定义脚本监控数据倾斜指标 |

| 大数据诊断工具 | Spark Audit、Hadoop MBeans | 分析作业执行中的数据分布特征 |

| AI异常检测 | Prometheus+Pyrograf、Flink ML | 通过时序数据分析预测倾斜趋势 |

数据倾斜的解决方案

检测到倾斜后,需结合业务场景选择以下策略:

优化数据分片策略

| 问题根源 | 解决方案 | 适用场景 |

|---|---|---|

| 哈希分片不均匀 | 改用一致性哈希(如RingHash算法) | 键值分布未知或动态变化的场景 |

| 分片键设计不合理 | 增加组合键(如user_id+time_window) | 业务访问具有明显局部性热点的情况 |

| 数据增长不可预测 | 动态分片(如MongoDB的Shard Key更新) | 数据量持续增长且分布模式变化的系统 |

动态负载均衡

- 在线迁移:通过Storage Rebalancer将数据从高负载节点迁移到空闲节点

- 虚拟节点:在Consul/Etcd等系统中增加虚拟节点分散数据(如从3个节点扩展到10个虚拟节点)

- 权重调整:修改CRUSH Map中的节点权重,降低高负载节点的存储优先级

热点数据隔离

- 本地缓存:将高频访问的热数据加载到Redis或Memcached

- 分层存储:将冷热数据分离,热数据使用SSD存储,冷数据归档至HDD

- 副本控制:对热点数据增加副本数(如从1副本扩至3副本)以分散读压力

架构级优化

- 引入数据网格:通过Apache Ignite等内存网格技术实现跨节点数据共享

- 无中心化设计:采用S3兼容存储(如MinIO)的去中心化架构

- 计算存储分离:使用Ceph+RBD将存储池独立于计算节点管理

实战案例:电商大促场景的倾斜治理

背景:某电商平台在大促期间,用户画像分区出现严重倾斜,导致3个节点存储了80%的订单数据。

检测过程:

- 通过Prometheus监控发现,节点

dn3的磁盘IOPS达到20k,远超其他节点的5k - 使用Spark采样分析订单数据的

user_id分布,发现前10%的用户产生了65%的订单 - 对比历史数据,发现大促期间新注册用户的ID分配集中,导致哈希分片失效

解决措施:

- 临时方案:将

dn3设置为只读,新增两个节点并通过hdfs balancer迁移数据 - 长期方案:将分片键改为

user_id%1000,并引入一致性哈希算法 - 预防机制:部署Flink实时监控,当某分区QPS>1000时自动触发分片调整

FAQs

Q1:如何预防数据倾斜的发生?

- 设计阶段:根据业务访问模式设计分片键(如时间+用户ID组合键)

- 运维阶段:定期运行数据分布检查脚本(如每天凌晨执行

df -h统计) - 架构层面:采用多副本+动态扩缩容机制(如Kubernetes的HPA自动扩缩容)

Q2:检测到倾斜后如何紧急处理?

- 限流降级:对高负载节点的访问进行限流(如Nginx的

limit_conn模块) - 数据迁移:暂停写入并启动数据平衡工具(如Ceph的

ceph osd crush reweight) - 服务转移:将受影响业务的读写请求切换至备用节点(