上一篇

如何用C高效实现网络爬虫轻松抓取海量数据?

- 行业动态

- 2025-05-12

- 10

C#网络爬虫通过HttpClient组件进行网页请求,结合HtmlAgilityPack实现HTML解析,可高效提取结构化数据,开发者需处理异步编程、反爬机制及数据存储,同时遵循robots协议与隐私法规,适用于商业情报采集或舆情监控等场景。

C#网络爬虫技术的核心原理与实践指南

在当今数据驱动的时代,网络爬虫技术成为获取和分析信息的关键工具,C#作为一种高效、安全的编程语言,结合.NET平台的强大生态,能够轻松实现复杂的网络爬虫功能,本文将从技术原理、开发流程、合规性及优化策略等角度,系统解析如何用C#构建高效可靠的网络爬虫。

为什么选择C#开发网络爬虫?

高性能与异步编程

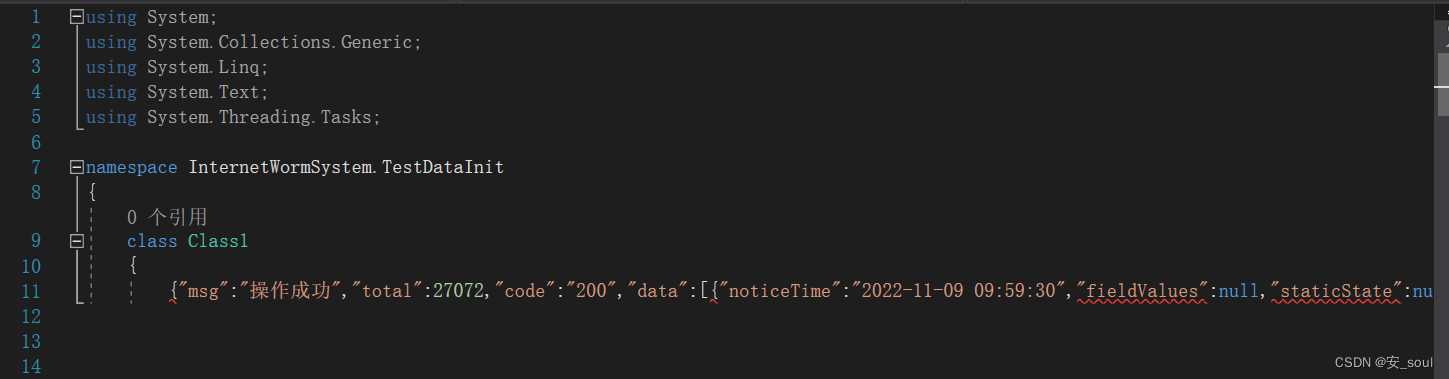

C#的async/await语法糖使异步请求处理变得简单,能高效管理大量并发HTTP请求,避免线程阻塞,使用HttpClient发送异步请求:using var client = new HttpClient(); var response = await client.GetAsync("https://example.com"); string html = await response.Content.ReadAsStringAsync();强大的HTML解析库

- HtmlAgilityPack:支持XPath查询,适合复杂DOM结构解析。

- AngleSharp:提供类浏览器解析能力,支持CSS选择器。

var doc = await context.OpenAsync("https://example.com"); var title = doc.QuerySelector("h1").TextContent;

完善的生态支持

.NET Core的跨平台特性(Windows/Linux/macOS)及NuGet包管理器,可快速集成反反爬虫库(如Polly)、代理池等扩展功能。

C#爬虫开发的核心技术点

HTTP请求管理

- User-Agent伪装:模拟浏览器行为,防止被识别为爬虫。

client.DefaultRequestHeaders.Add("User-Agent", "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"); - Cookie与Session:使用

CookieContainer维护登录状态。

- User-Agent伪装:模拟浏览器行为,防止被识别为爬虫。

数据解析与存储

- 正则表达式:快速提取结构化数据(如邮箱、电话)。

- JSON反序列化:通过

System.Text.Json处理API返回数据。var data = JsonSerializer.Deserialize<ApiResponse>(jsonString);

反反爬虫策略

- 请求频率控制:通过

Task.Delay()设置随机间隔(如1-3秒)。 - IP代理轮换:集成付费代理服务(如Luminati)。

- 验证码处理:调用OCR API(如Azure Cognitive Services)。

- 请求频率控制:通过

实战案例:爬取电商网站商品价格

public async Task CrawlProductPrices()

{

using var client = new HttpClient();

client.Timeout = TimeSpan.FromSeconds(10);

// 模拟浏览器请求头

client.DefaultRequestHeaders.Add("Accept-Language", "en-US,en;q=0.9");

for (int page = 1; page <= 5; page++)

{

var url = $"https://api.ecommerce.com/products?page={page}";

var json = await client.GetStringAsync(url);

var products = JsonSerializer.Deserialize<ProductList>(json);

foreach (var product in products.Items)

{

Console.WriteLine($"{product.Name}: {product.Price}");

await Task.Delay(1000); // 控制请求频率

}

}

}法律与道德:合规爬虫的关键原则

遵守Robots协议

检查目标网站的robots.txt文件,User-agent: * Disallow: /admin/ Crawl-delay: 5数据使用边界

- 避免爬取个人隐私数据(如手机号、身份证)。

- 遵循《GDPR》和《网络安全法》相关规定。

版权声明

若数据用于商业用途,需获得网站授权或遵守CC协议。

性能优化技巧

| 优化方向 | 具体方法 |

|---|---|

| 并发控制 | 使用Parallel.ForEach实现并行请求 |

| 缓存机制 | 用MemoryCache缓存已爬取URL |

| 异常处理 | 通过Polly库实现重试策略(如HTTP 503) |

var retryPolicy = Policy

.Handle<HttpRequestException>()

.WaitAndRetryAsync(3, retryAttempt =>

TimeSpan.FromSeconds(Math.Pow(2, retryAttempt)));C#开发网络爬虫需兼顾技术实现与合规性,通过合理选择库(如HttpClient、AngleSharp)、控制请求频率、遵守法律规范,可构建稳定高效的数据采集系统,建议开发者持续关注.NET生态更新(如.NET 7的性能改进),并优先采用异步编程模型以提升吞吐量。

引用说明

- Microsoft官方文档:HttpClient使用指南

- 欧盟《通用数据保护条例》(GDPR)

- W3C Robots Exclusion Protocol标准