上一篇

如何快速搭建GPU云服务器?

- 行业动态

- 2025-05-08

- 2163

创建GPU云服务器需先选择云服务商,登录控制台后选择GPU实例类型,按需配置CPU、内存及GPU规格,设置操作系统、存储空间,配置安全组开放必要端口,确认订单并支付,实例创建成功后通过远程工具连接即可使用。

在云计算和人工智能技术快速发展的今天,GPU云服务器已成为科研机构、游戏开发者和AI从业者的核心工具,本文将通过专业视角,详细解析从零开始创建GPU云服务器的完整流程,并提供权威的优化建议。

服务商选择与注册流程

- 主流服务商对比

- 阿里云:提供NVIDIA A100/V100实例,适合大规模模型训练

- 酷盾:AMD MI系列性价比突出,推荐图形渲染场景

- AWS EC2:P4实例支持8卡互联,适合分布式计算

- Azure NCv3系列:微软生态整合优势明显

- 注册认证要点

- 企业用户需准备营业执照扫描件

- 国际信用卡支持VISA/MasterCard双通道

- 学生开发者可申请教育优惠套餐(需.edu邮箱认证)

实例配置黄金法则

- GPU选型指南

- 训练场景:优先选择显存≥24GB的A100/Tesla V100

- 推理部署:T4/Tesla P4更具成本效益

- 图形工作站:Quadro RTX 6000专业渲染卡

- 组合配置建议

| 场景 | vCPU | 内存 | 存储方案 | |--------------|------|--------|-------------------| | 深度学习训练 | 16核 | 64GB | ESSD云盘 1TB | | 实时推理 | 8核 | 32GB | 本地SSD 500GB | | 视频渲染 | 32核 | 128GB | 高速NAS存储 |

系统环境部署规范

- 驱动安装标准流程

- NVIDIA驱动安装命令:

sudo apt install nvidia-driver-525 -y nvidia-smi # 验证安装

- CUDA工具包配置:

wget https://developer.download.nvidia.com/compute/cuda/12.2.2/local_installers/cuda_12.2.2_535.104.05_linux.run sudo sh cuda_12.2.2_535.104.05_linux.run

- 环境验证清单

- GPU状态检测:

nvidia-smi --query-gpu=timestamp,name,utilization.gpu,memory.total --format=csv

- CUDA版本检查:

nvcc --version

- cuDNN验证:

import torch print(torch.cuda.is_available())

生产环境最佳实践

- 安全加固方案

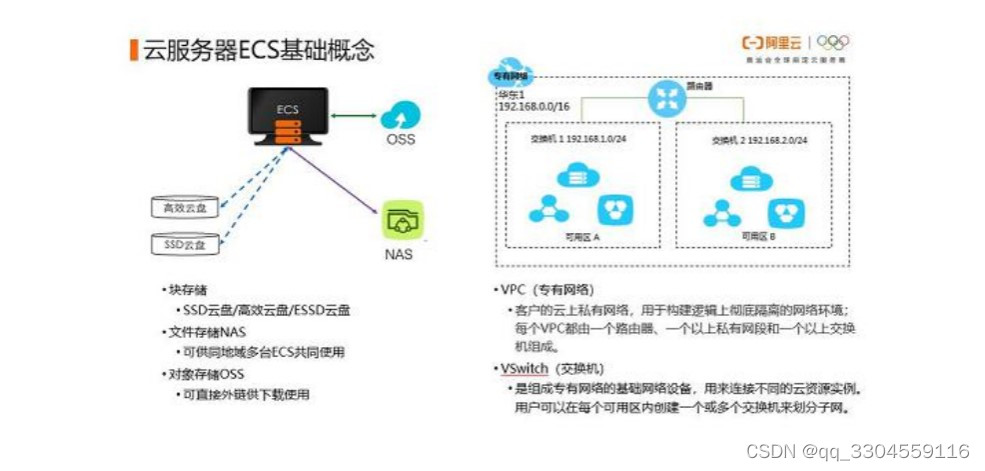

- 启用VPC私有网络隔离

- 配置安全组规则(建议仅开放22/3389端口)

- 安装云防火墙如Cloudflare Zero Trust

- 成本优化策略

- 竞价实例节省60%成本(适合容错场景)

- 自动伸缩组设置CPU利用率>70%触发扩容

- 对象存储OSS生命周期管理

- 监控体系构建

- Prometheus+Grafana监控框架部署

- 关键指标警报阈值设置:

- GPU利用率>90%持续10分钟

- 显存使用率>85%

- 温度超过85℃

故障排查工具箱

- 常见问题诊断

- 驱动冲突:

sudo apt purge nvidia*彻底清除后重装 - CUDA版本不兼容:使用conda创建虚拟环境

- 显存泄漏检测:

gpustat实时监控工具

- 性能调优技巧

- 混合精度训练配置:

from tensorflow.keras.mixed_precision import set_global_policy set_global_policy('mixed_float16') - NCCL网络优化:

export NCCL_IB_DISABLE=1 export NCCL_SOCKET_IFNAME=eth0

权威引用:

- NVIDIA官方文档《CUDA Installation Guide》v12.2

- 阿里云《GPU云服务器安全白皮书》2025版

- MLPerf Training Benchmark结果(v3.0)

通过以上专业级配置方案,用户可快速搭建高性能计算环境,建议定期进行压力测试和健康检查,结合业务需求动态调整资源配置,实现最优性价比。