上一篇

分布式流式计算框架

- 行业动态

- 2025-05-08

- 3515

分布式流式计算框架基于分布式架构实时处理连续数据流,具备低延迟、高吞吐特性,适用于实时分析与监控场景

分布式流式计算框架详解

分布式流式计算的核心特征

分布式流式计算框架是处理实时数据流的核心技术,其设计目标是实现低延迟、高吞吐、可扩展的数据处理能力,与传统批处理框架不同,流式计算框架需要解决数据持续输入、动态资源分配、状态管理、容错机制等关键问题,以下是其核心特征:

| 特征 | 描述 |

|---|---|

| 实时性 | 数据到达后立即处理,延迟通常在毫秒到秒级别。 |

| 连续性 | 支持无限数据流的持续处理,无需预定义数据边界。 |

| 可扩展性 | 通过横向扩展(增加节点)应对数据量激增,支持每秒百万级事件处理。 |

| 容错性 | 通过数据副本、检查点(Checkpoint)或日志重放机制保证故障恢复能力。 |

| 状态管理 | 支持有状态计算(如窗口运算),需解决状态持久化与分布式一致性问题。 |

| 事件时间处理 | 提供水印(Watermark)机制处理乱序数据,支持基于事件时间的精确计算。 |

主流分布式流式计算框架对比

以下是当前最流行的分布式流式计算框架及其技术特点:

| 框架 | 核心架构 | 处理模型 | 状态管理 | 延迟表现 | 典型场景 |

|---|---|---|---|---|---|

| Apache Flink | 基于流的原生设计,Master-Worker架构 | 逐条处理(低延迟模式)或微批处理 | 分布式快照(Checkpoint)+ 状态后端(RocksDB/Kafka) | 毫秒级 | 实时ETL、复杂事件处理、机器学习推理 |

| Apache Spark | 微批处理(Micro-Batch)架构 | 小批量数据处理(DStream) | 基于RDD的被动状态管理 | 亚秒级 | 实时分析、简单流处理 |

| Apache Kafka | 日志流为核心的分布式架构 | 事件流传输与轻量级处理 | 依赖外部存储(如Kafka State Store) | 依赖处理逻辑 | 日志聚合、流式数据传输 |

| Google Dataflow | 基于Apache Beam模型 | 统一批流处理(Unified Model) | 分布式存储(Cloud Storage) | 低延迟 | 大规模实时数据分析、云端流处理 |

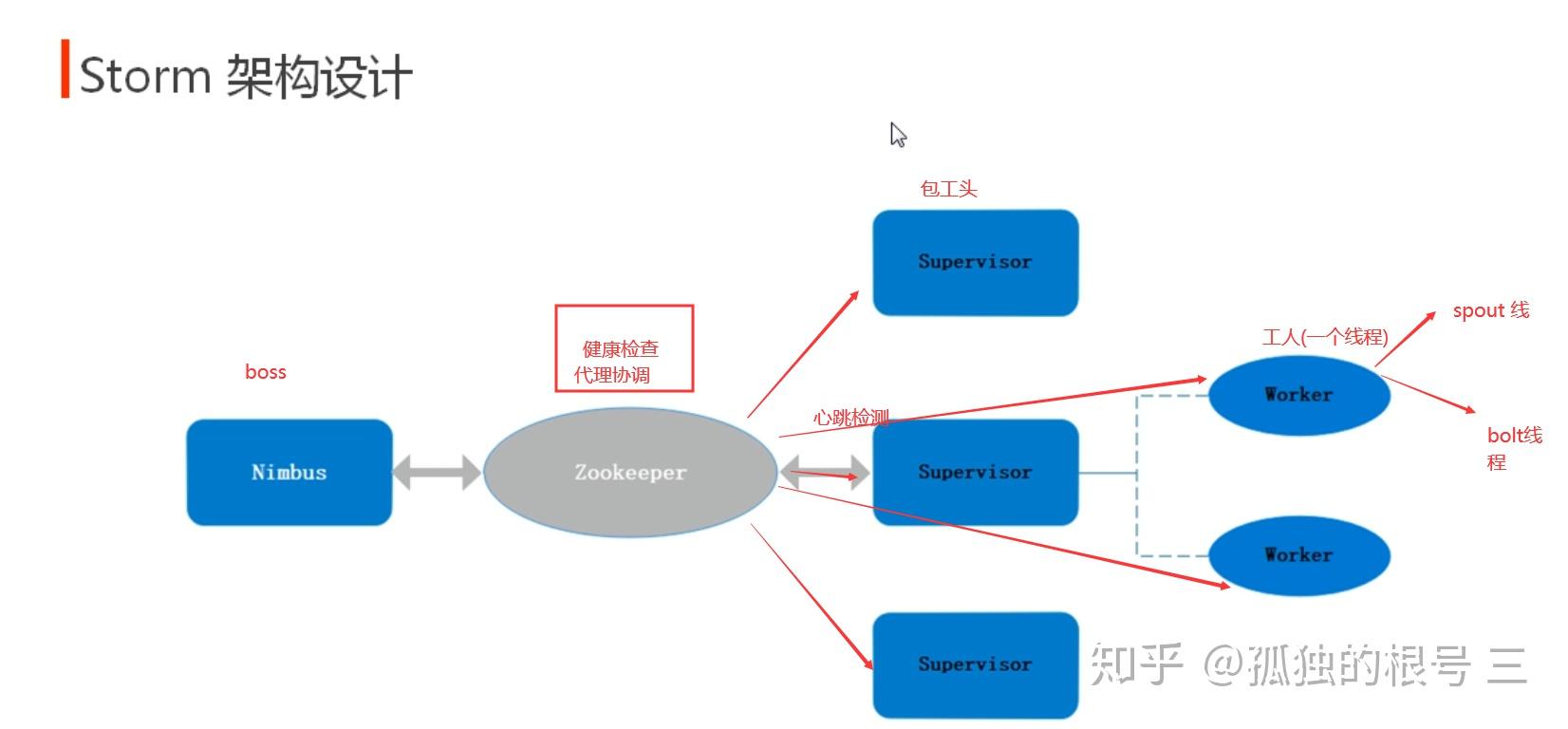

| Apache Storm | 多线程Spout-Bolt拓扑结构 | 逐条处理 | 依赖外部数据库(如Redis) | 低延迟 | 实时监控、简单流式计算 |

关键技术实现对比

时间语义与窗口操作

- Flink:支持事件时间(Event Time)、处理时间(Processing Time)和摄入时间(Ingestion Time),提供丰富的窗口类型(滚动窗口、滑动窗口、会话窗口)。

- Spark:仅支持处理时间,窗口操作依赖微批间隔,灵活性较低。

- Storm:依赖处理时间,需手动实现事件时间逻辑。

状态一致性与容错

- Flink:通过Checkpoint定期保存状态快照,支持精确一次(Exactly-Once)语义。

- Spark:微批处理模式下仅支持至少一次(At-Least-Once)语义。

- Kafka Streams:依赖Kafka的日志重放机制实现容错,状态存储在本地或外部Kafka主题。

资源管理与扩展性

- Flink:基于YARN或Kubernetes的动态资源分配,支持任务槽(Task Slot)隔离。

- Spark:依赖YARN/Mesos调度,微批处理可能导致资源利用率波动。

- Storm:静态拓扑结构,扩展性受限于Spout/Bolt的线程配置。

应用场景与选型建议

| 场景需求 | 推荐框架 | 理由 |

|---|---|---|

| 复杂事件处理(如CEP) | Apache Flink | 原生支持事件时间、状态管理和复杂窗口操作 |

| 实时日志分析 | Apache Kafka+Kafka Streams | 轻量级处理与传输一体化,生态兼容好 |

| 低延迟实时监控 | Apache Storm | 低延迟逐条处理,适合简单计算任务 |

| 大规模流批一体 | Google Dataflow | 统一API降低开发复杂度,云端优化 |

| 机器学习实时推理 | Apache Flink/Spark | Flink支持状态保存,Spark MLlib生态成熟 |

常见问题解答(FAQs)

Q1:如何选择流式计算框架?

A1:需综合考虑以下因素:

- 业务需求:低延迟选Storm/Flink,复杂逻辑选Flink/Dataflow。

- 数据规模:PB级数据优先Flink/Spark,中小型业务可选Kafka Streams。

- 生态兼容性:需与现有Kafka、HDFS等组件集成时,优先选择同源框架。

- 运维成本:云端场景推荐Dataflow,本地部署可选Flink/Spark。

Q2:如何处理流式计算中的乱序数据?

A2:主流方案包括:

- 水印机制(如Flink):通过标记事件时间阈值,允许一定延迟的数据到达。

- 延迟队列:将数据缓冲一段时间后再处理,牺牲延迟换取准确性。

- 事件时间重排序:基于时间戳对数据进行预排序