hbase数据仓库设计要求

- 行业动态

- 2025-05-08

- 4588

HBase数据仓库设计需注重列族划分、数据分区策略、版本控制优化、高效索引机制,合理选择存储引擎,实现读写分离,并

HBase数据仓库设计核心要求与实践指南

总体设计原则

HBase作为分布式列式存储系统,在数据仓库场景中需遵循以下核心原则:

| 设计维度 | 具体要求 |

|---|---|

| 高可用性 | 支持跨机房部署,数据副本数≥3,RegionServer故障自动切换 |

| 横向扩展性 | 支持在线扩容,业务无感知,存储容量可达PB级 |

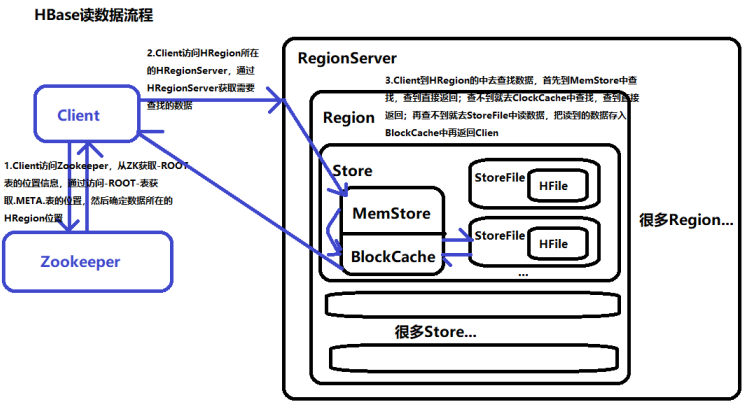

| 读写分离 | 写操作直写WAL+MemStore,读操作优先读取BlockCache |

| 成本优化 | 冷热数据分层存储,生命周期管理自动降级存储介质 |

| Schema灵活 | 支持动态添加列族,适应业务需求变更 |

表结构设计规范

RowKey设计

- 唯一性:必须全局唯一,建议采用复合键结构(如

user_id+timestamp) - 长度控制:<100字节,推荐64字节内

- 有序性:时间序列数据需保持递增顺序,非时间序列建议哈希前缀防热点

- 示例方案:

[reverse(user_id)] + [timestamp] + [business_type]通过反转用户ID分散写入压力,时间戳保证顺序

- 唯一性:必须全局唯一,建议采用复合键结构(如

列族设计

- 合并原则:将访问模式相似的列合并为列族(如基础属性放同一族)

- 数量限制:建议≤5个,避免元数据管理开销

- 版本管理:设置合理

VERSIONS参数(建议1-3),防止数据膨胀 - 典型设计:

| 列族名 | 存储内容 | 块大小 | 压缩算法 |

|————–|————————————|——–|—————-|

| info | ID、创建时间等基础字段 | 64KB | SNAPPY |

| metrics | 实时计算指标(温度、点击量等) | 128KB | LZO |

| details | JSON格式扩展字段 | 256KB | ZSTD |

预分区策略

- 计算方式:根据预计数据量/单Region最大存储计算

- Split点设置:时间序列按天/小时预分,哈希键按MD5取模

- 示例:

create 'user_behavior',{NUMREGIONS=>100,SPLITALGORITHMS=>{'user_id'=> 'hash'}}

数据存储优化

压缩算法选择

!压缩算法对比布隆过滤器配置

- ROW级别:减少Block误判,提升随机读性能

- 前缀过滤:开启

blockcache.bloom.block.on=true - 内存消耗:约占BlockSize的1/8

TTL策略

- 列级设置:对时效性数据设置自动过期(如日志留存30天)

- 示例:

alter 'access_log',{COLUMN_FAMILY:{'log_content'=>{TTL=>604800}}}

索引增强设计

二级索引实现

- 本地索引:在RowKey中嵌入索引字段(如

category_code+primary_key) - 协处理索引:使用Endpoint/Observer实现实时索引

- 外部索引:同步构建Elasticsearch索引,保持双写

- 本地索引:在RowKey中嵌入索引字段(如

倒排索引设计

- 适用场景:全文检索、多条件组合查询

- 存储方案:将索引数据存储为独立列族,定期刷新

- 更新机制:采用增量日志记录变更,异步重建索引

数据生命周期管理

分层存储策略

| 数据类型 | 存储层级 | 保留周期 | 转移规则 |

|—————-|——————-|—————-|————————-|

| 热数据 | HDD+SSD混合池 | 7天 | LRU淘汰 |

| 温数据 | SATA HDD | 30天 | 定时迁移 |

| 冷数据 | 蓝光存储/磁带 | 180天+ | 生命周期结束归档 |数据清理流程

- 软删除标记:增加

is_deleted标志位 - 批量清理:每天凌晨执行Major Compaction

- 物理删除:超过保留周期后触发永久删除

- 软删除标记:增加

性能优化关键项

缓存配置

- BlockCache:堆外内存占比≥50%,启用异步刷新

- Meta缓存:预加载常用-ROOT-表信息

- MemStore刷新:设置

hbase.client.write.buffer=2MB

读写分离优化

- 读路径:优先读取BlockCache→MemStore→HFile

- 写路径:WAL→MemStore→HFile(异步刷盘)

- 批量操作:AutoFlush每1000条触发,Retries=3

Compaction控制

- Minor Compact:阈值设为5个HFiles

- Major Compact:夜间低谷期执行,合并因子设为10

- 并发控制:单Region最多2个Compaction任务并行

监控与运维体系

核心监控指标

- 集群级:RegionServer负载、RS-ZK延迟、JVM堆内存使用率

- 表级:读写Latency、BlockCache命中率、Compact队列长度

- Region级:StoreFile数量、MemStore大小、RequestCount

异常处理机制

- 热点检测:当单个Region QPS>5000持续1分钟,触发自动Split

- 慢查询优化:捕获>500ms的查询,分析扫描行数/Filter效率

- 数据均衡:Region负载差异>30%时触发负载均衡

安全与合规设计

访问控制

- RBAC模型:按角色分配Table/ColumnFamiliy权限

- 加密传输:启用SSL/TLS 1.2+,禁用RC4算法

- 审计日志:记录所有Admin操作及敏感数据变更

数据脱敏

- 静态脱敏:存储时对身份证号等字段进行不可逆处理

- 动态脱敏:查询时根据用户权限返回掩码数据

- 字段级控制:通过Column ACL实现细粒度权限

FAQs

Q1:如何设计高并发场景下的RowKey避免热点?

A1:采用组合键策略,例如[hash(user_id)]+[timestamp]结构,先对业务主键做哈希取模(如MD5后取后4位),再拼接时间戳,这种设计可使写入均匀分布在多个Region,同时保持时间有序性,建议哈希位数根据并发量计算,例如每秒1万请求可设计为16个分区(2^4)。

Q2:HBase数据仓库如何实现历史数据查询加速?

A2:可采用三级加速体系:①建立时间维度预投影,按天/月建立二级索引表;②对老旧数据构建Bitmap索引,存储统计信息;③冷热数据分离,将30天前的数据转移到只读文件系统(如Amazon S3 Glacier),查询时自动路由请求,可对历史数据建立摘要表,存储