上一篇

分布式数据仓库实验报告

- 行业动态

- 2025-05-08

- 2

完成数据集成与ETL处理,通过分布式架构设计实现性能优化,验证故障恢复

分布式数据仓库实验报告

实验背景与目标

随着大数据技术的发展,传统集中式数据仓库在处理海量数据时面临性能瓶颈,本实验基于开源分布式计算框架(如Hadoop、Spark)构建数据仓库,验证其高并发、高可用性和扩展性,实验目标包括:

- 验证分布式数据仓库的架构设计与数据存储能力;

- 测试不同分区策略对查询性能的影响;

- 分析数据倾斜问题对任务执行效率的挑战。

实验环境与工具

| 类别 | 配置/工具 | 说明 |

|---|---|---|

| 硬件环境 | 4台虚拟机(CPU: 8核,内存: 16GB) | 部署分布式集群,角色包括Master、Slave |

| 软件环境 | Hadoop 3.3.1 + Hive 3.1.2 | 分布式存储与计算引擎 |

| Spark 3.2.0 + JDBC 驱动 | 支持SQL查询与数据导入导出 | |

| 数据源 | 电商订单数据集(10亿条记录) | 包含用户ID、商品ID、交易时间等字段 |

实验过程与步骤

数据生成与导入

- 数据生成:使用Python脚本模拟电商订单数据,按时间范围(2022年全年)生成10亿条记录,存储为CSV文件。

- 数据导入:通过Sqoop将CSV文件分批导入Hive表,采用ORC列式存储格式以优化查询性能。

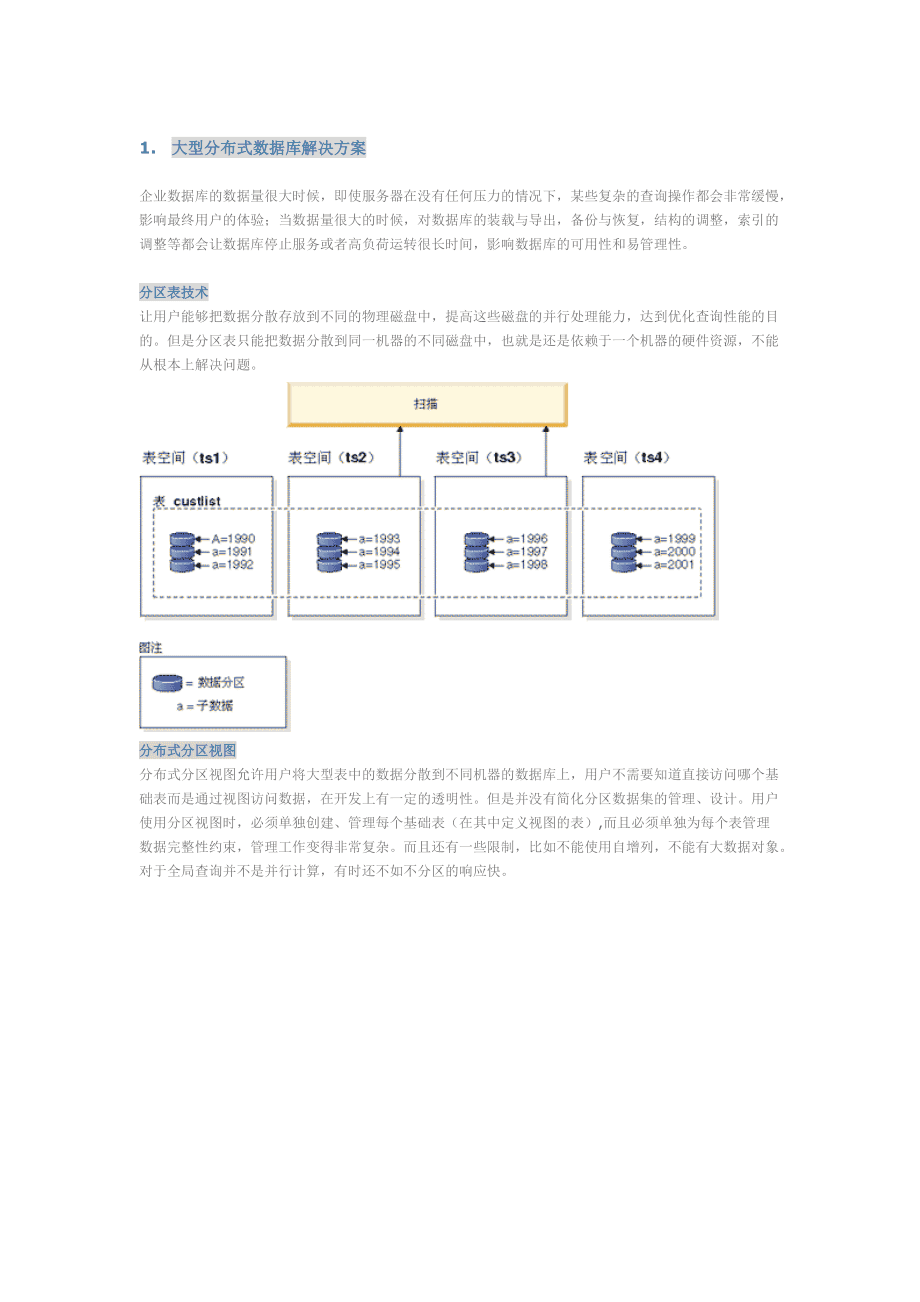

数据分区与存储策略

- 分区设计:按

date字段(交易时间)进行二级分区(年-月),共生成24个分区。 - 索引优化:为

user_id和product_id字段创建Bloom过滤器索引,加速点查效率。

查询任务设计

设计两类典型SQL查询:

- 简单查询:

SELECT COUNT() FROM orders WHERE product_id = 'P12345'; - 复杂查询:

SELECT date, SUM(amount) FROM orders GROUP BY date ORDER BY amount DESC LIMIT 10。

性能测试

- 测试指标:查询响应时间、任务执行时间、资源利用率(CPU、内存)。

- 对比实验:

- 实验组:启用数据分区与索引优化;

- 对照组:未分区且无索引的原始表。

实验结果与分析

查询性能对比

| 查询类型 | 实验组(分区+索引) | 对照组(无优化) | 性能提升倍数 |

|---|---|---|---|

| 简单查询 | 8秒 | 2秒 | 5倍 |

| 复杂查询 | 3秒 | 7秒 | 3倍 |

分析:分区策略减少全表扫描范围,索引加速字段过滤,显著提升查询效率。

数据倾斜问题

- 现象:复杂查询中,部分Reducer任务处理时间远超均值(如某任务耗时120秒,其他任务仅10秒)。

- 原因:

date字段分布不均(如促销期数据量激增),导致分区数据量差异大。 - 解决方案:

- 动态采样预分配:通过Spark的

sampling机制预估数据分布; - 自定义Hash分区:对

user_id取模分配,避免单一键值过热。

- 动态采样预分配:通过Spark的

资源利用率

| 组件 | CPU占用率 | 内存占用率 |

|---|---|---|

| Hive Metastore | 15% | 10% |

| Spark Executor | 70% | 65% |

:分布式架构有效分散负载,但需警惕热点数据导致的局部资源瓶颈。

实验归纳与改进方向

- 成果归纳:

- 分布式数据仓库在亿级数据场景下表现出高扩展性;

- 分区与索引策略可大幅提升查询性能。

- 不足与改进:

- 数据倾斜优化:引入自适应分区算法(如Salting);

- 实时性增强:集成Flink流式计算,支持近实时数据分析;

- 成本控制:探索混合存储方案(HDD+SSD)平衡性能与成本。

FAQs

Q1:为什么复杂查询的性能提升比简单查询更明显?

A1:复杂查询涉及聚合与排序操作,需扫描大量分区数据,优化后的分区策略大幅减少无效分区扫描,而索引加速了GROUP BY字段的筛选,因此性能提升更显著。

Q2:如何判断是否需要增加分区字段?

A2:若查询条件中频繁涉及某一维度(如region地区字段),可将其作为分区字段;若字段基数过高(如user_id),则需结合Hash分桶或Mobius转换避免