上一篇

分布式数据仓库实战指南

- 行业动态

- 2025-05-08

- 2

《分布式数据仓库实战指南》聚焦架构设计、数据集成、存储优化与计算引擎等核心模块,融合案例解析与最佳实践,助力大数据从业者高效构建可

从架构设计到落地实践

分布式数据仓库是支撑企业海量数据分析的核心基础设施,其设计需兼顾高并发、低延迟、高可用和可扩展性,以下从架构设计、技术选型、数据治理到落地实践,归纳实战经验。

分布式数据仓库架构设计核心原则

分层架构

- 源数据层:对接业务数据库、日志、文件等原始数据。

- 数据清洗层:通过ETL/ELT工具完成数据标准化、去重、格式转换。

- 明细数据层:存储结构化明细数据,支持复杂查询。

- 轻度聚合层:按业务主题预聚合数据(如按天/小时粒度)。

- 服务层:提供API或可视化接口,供BI、机器学习等场景调用。

存储与计算分离

- 存储层:选用分布式文件系统(如HDFS、S3)或列式存储(如Iceberg、Delta Lake)。

- 计算层:通过SQL引擎(如Presto、Trino)或计算框架(如Spark)实现按需计算。

- 优势:资源独立扩展,避免存储与计算资源争抢。

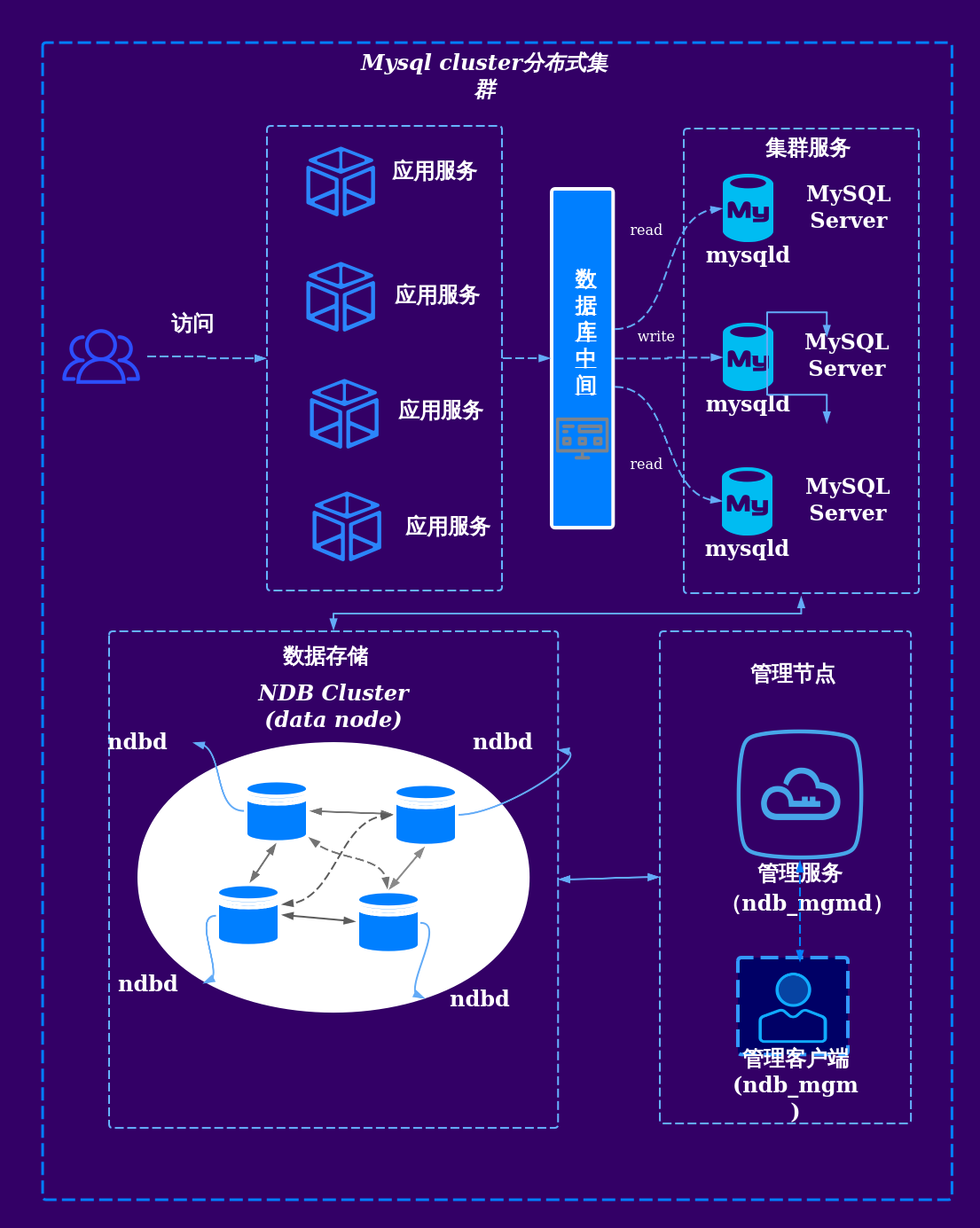

高可用与容灾设计

- 多活部署:采用主备或多副本机制,数据分片均匀分布。

- 故障转移:通过负载均衡器(如HAProxy)和心跳检测实现自动切换。

关键技术选型对比

| 组件 | 主流方案 | 适用场景 | 优缺点 |

|---|---|---|---|

| 数据集成 | Apache NiFi、Airflow、Kafka | 实时/批量数据同步 | NiFi适合流批一体,Airflow适合调度,Kafka高吞吐但需处理乱序 |

| 存储引擎 | Hive(TB级)、Iceberg(PB级) | 离线分析、ACID事务支持 | Hive成熟但扩展性差,Iceberg支持时间旅行和高效删除 |

| 计算引擎 | Presto、Spark SQL、Flink | 交互式查询、实时计算 | Presto轻量但功能有限,Spark适合复杂任务,Flink强实时性 |

| 元数据管理 | Apache Atlas、Hive Metastore | 数据血缘追踪、权限管理 | Atlas支持跨平台,Hive Metastore依赖HDFS |

数据治理与性能优化

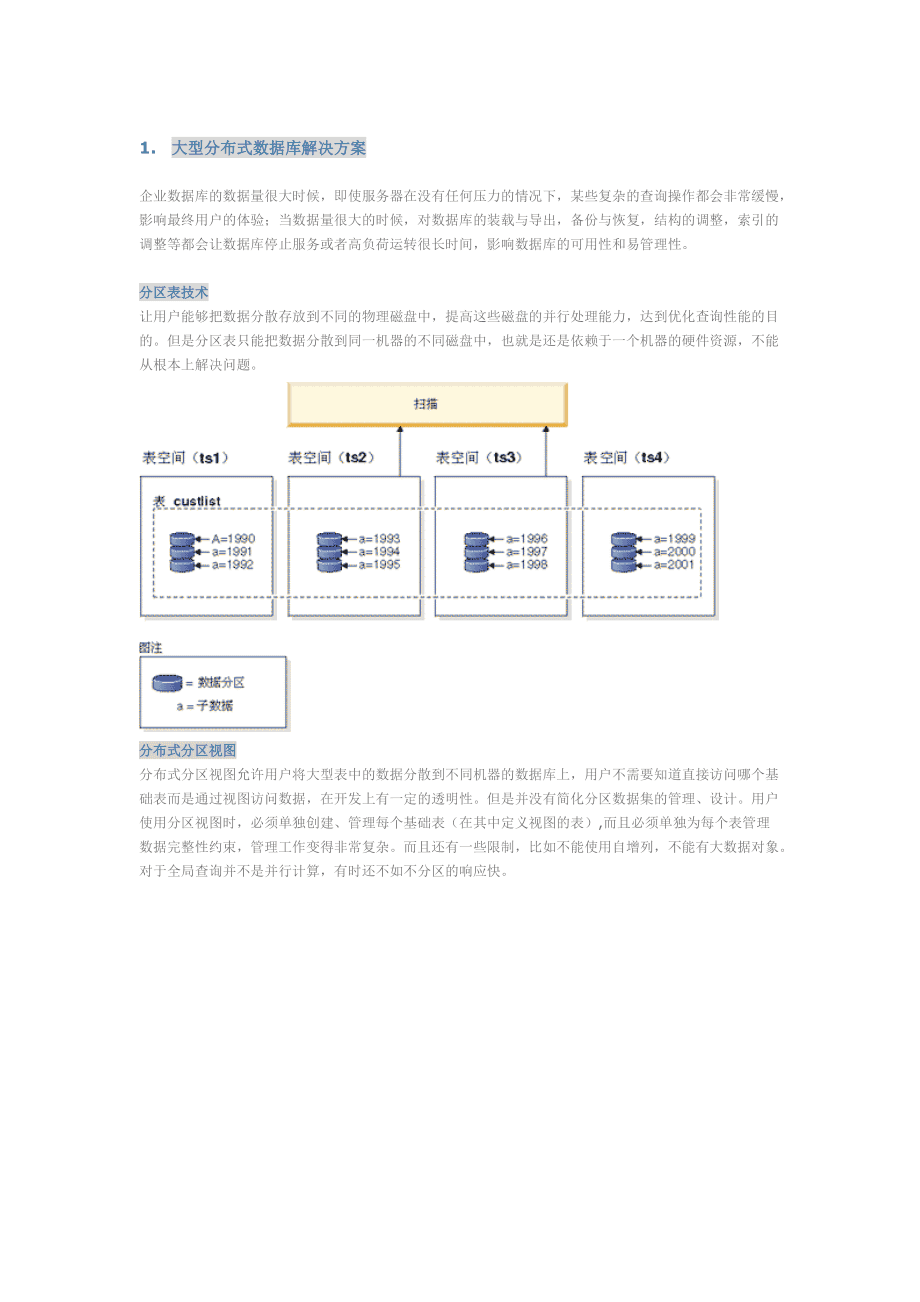

数据分区策略

- 时间分区:按天/小时划分,适合时序数据(如日志)。

- 哈希分区:均匀分布数据,避免热点问题。

- 复合分区:结合时间+哈希,平衡查询效率与负载。

索引与物化视图

- 二级索引:加速非分区字段查询(如用户ID)。

- 物化视图:预聚合高频查询结果,减少实时计算压力。

SQL调优技巧

- 避免全表扫描,优先使用分区键过滤。

- 减少子查询,改用JOIN或临时表。

- 广播小表而非大表,降低网络开销。

典型场景实战案例

场景1:电商大促数据分析

- 挑战:峰值流量下实时订单分析与历史数据关联。

- 方案:

- 数据同步:Kafka实时采集订单数据,Flink计算实时指标。

- 存储:Iceberg存储明细数据,按商品ID哈希分区。

- 查询:Presto关联实时与历史数据,生成大促报表。

场景2:日志合规审计

- 挑战:PB级日志存储与快速检索。

- 方案:

- 压缩存储:Parquet格式+Snappy压缩,节省50%空间。

- 索引优化:对IP地址、时间字段建立倒排索引。

- 查询加速:Trino+Redis缓存热门查询结果。

常见问题与避坑指南

数据倾斜问题

- 原因:Key分布不均(如某些用户ID高频访问)。

- 解决:哈希分桶、动态分区或本地预处理聚合。

元数据一致性

- 风险:多计算引擎共用Hive Metastore可能导致锁冲突。

- 方案:独立Metastore实例或使用Iceberg/Delta Lake统一管理。

成本控制

- 存储优化:开启列式存储压缩(如ORC/Parquet)、生命周期管理。

- 计算优化:按需启用资源队列,避免长期占用集群资源。

FAQs

Q1:如何选择合适的分布式存储引擎?

- A:若以离线分析为主且数据量TB级,Hive足够;若需PB级扩展、ACID事务或高效删除,优先Iceberg/Delta Lake,实时场景可结合Kafka+Flink。

Q2:数据仓库出现查询超时如何解决?

- A:

- 检查是否触发全表扫描,优化WHERE条件或添加分区。

- 查看执行计划,避免Shuffle操作过多。

- 对高频查询创建物化