上一篇

反向传播网络死机原因和应对方法

- 行业动态

- 2025-05-03

- 2

反向传播网络死机多因梯度消失/爆炸致参数停滞,可通过调整学习率、换ReLU等抗饱和激活函数、梯度裁剪及L2正则

反向传播网络死机原因与应对方法详解

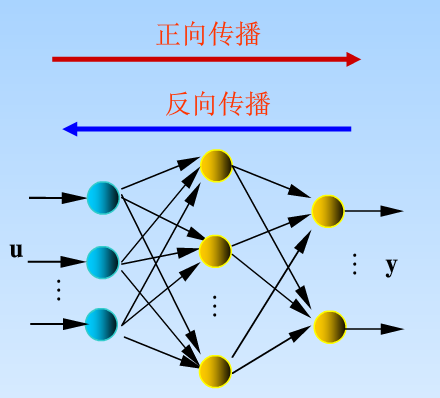

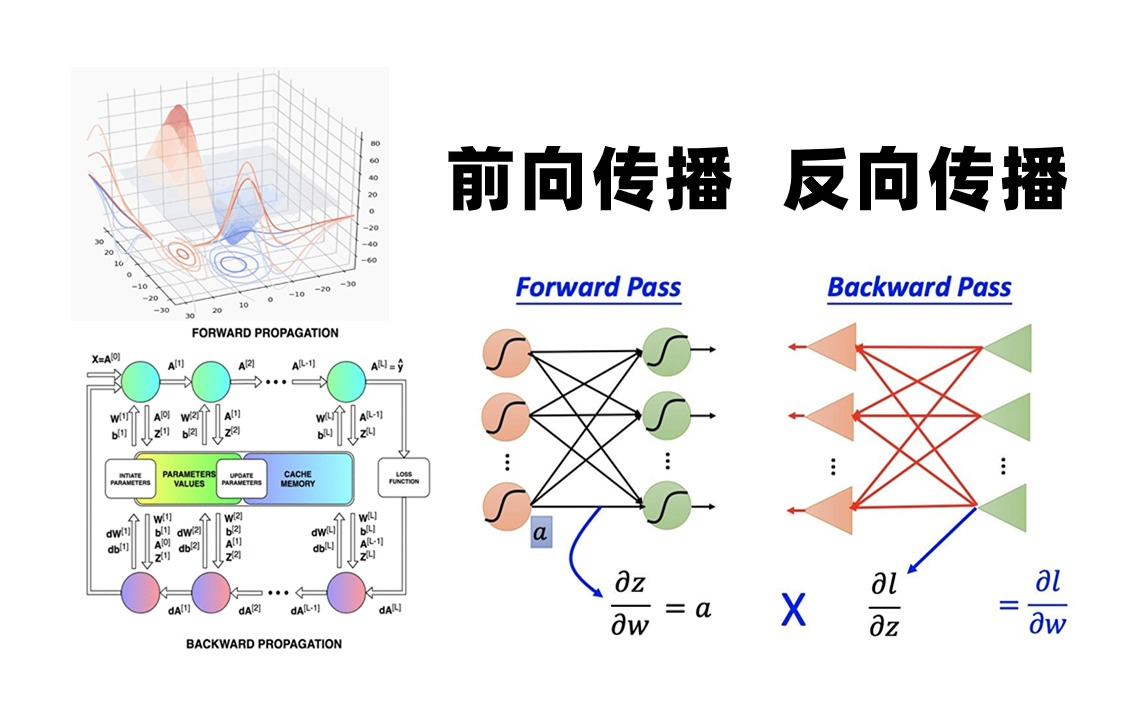

反向传播(Backpropagation)是深度学习的核心算法,但在实际应用中,模型训练过程中可能出现“死机”(如程序卡死、显存溢出、进程崩溃等)现象,以下是常见原因及对应的解决方法,结合理论分析与实践建议,帮助开发者快速定位并解决问题。

反向传播网络死机的核心原因

| 原因分类 | 具体表现 | 触发场景 |

|---|---|---|

| 数据问题 | 数据量过大、数据预处理错误、数据类型不匹配、数据加载阻塞 | 训练大规模数据集、未做归一化或标准化处理 |

| 模型复杂度过高 | 参数量过大、网络层数过深、计算图膨胀 | 设计超深网络(如上千层)、未使用残差结构 |

| 超参数设置错误 | 学习率过大/过小、梯度裁剪阈值不合理、批量大小(Batch Size)与硬件不匹配 | 初始化学习率过高(如1.0)、Batch Size过大 |

| 硬件资源限制 | 显存(GPU/CPU内存)不足、存储空间耗尽、多进程资源竞争 | 单机训练大模型(如Transformer)、多任务并行 |

| 代码实现问题 | 反向传播路径断裂、梯度计算错误、循环引用导致内存泄漏 | 自定义复杂网络结构、动态计算图生成错误 |

| 框架或环境问题 | 深度学习框架版本兼容性差、CUDA/cuDNN配置错误、多线程冲突 | 升级框架后未适配代码、多卡训练同步失败 |

具体原因分析与解决方案

数据问题

- 原因分析:

- 数据量过大:单批次数据加载超出显存容量,导致内存溢出。

- 预处理错误:数据未归一化或标准化,导致数值计算不稳定(如梯度爆炸/消失)。

- 数据类型不匹配:输入数据类型与模型期望不符(如浮点数精度问题)。

- 解决方法:

- 优化数据加载:使用数据生成器(如TensorFlow的

tf.data或PyTorch的DataLoader)分批加载数据,避免一次性加载全部数据。 - 数据预处理:对输入数据进行归一化(均值为0,方差为1)或标准化(值域缩放到[0,1]),减少数值波动。

- 检查数据类型:确保输入数据与模型参数的数值类型一致(如

float32)。

- 优化数据加载:使用数据生成器(如TensorFlow的

模型复杂度过高

- 原因分析:

- 参数量过大:模型层数过多或每层神经元数量过大,导致显存占用过高。

- 计算图膨胀:未优化的模型结构(如全连接层代替卷积层)导致计算量激增。

- 解决方法:

- 简化模型:减少网络层数或每层神经元数量,优先使用轻量化结构(如MobileNet)。

- 使用残差连接:通过ResNet等结构缓解梯度消失问题,降低模型深度对训练的影响。

- 模型剪枝与量化:训练后移除冗余参数,或使用低精度计算(如INT8)减少显存占用。

超参数设置错误

- 原因分析:

- 学习率过高:梯度更新步长过大,导致损失函数震荡或NaN值。

- 学习率过低:训练速度极慢,可能误判为“卡死”。

- 梯度裁剪阈值不合理:未限制梯度范数,导致数值溢出。

- 解决方法:

- 动态调整学习率:使用学习率调度器(如余弦退火、Warmup)或自适应优化器(如Adam)。

- 梯度裁剪:限制梯度范数(如

torch.nn.utils.clip_grad_norm_),防止数值爆炸。 - 调整Batch Size:根据显存容量选择合适Batch Size(如GPU显存不足时减小Batch Size)。

硬件资源限制

- 原因分析:

- 显存不足:大模型训练时显存溢出(如GPU内存不够)。

- 存储空间耗尽:日志文件、检查点文件过多占用磁盘空间。

- 解决方法:

- 混合精度训练:使用FP16或BFLOAT16降低显存占用(如NVIDIA的AMP技术)。

- 分布式训练:将模型拆分到多卡或多机(如Horovod、DDP)。

- 清理冗余文件:定期删除旧日志和检查点,使用

torch.cuda.empty_cache()释放显存。

代码实现问题

- 原因分析:

- 反向传播路径断裂:某些分支未接入计算图,导致梯度无法回传。

- 内存泄漏:循环引用或未释放变量导致内存持续增长。

- 解决方法:

- 检查计算图:确保所有参数均参与前向传播,避免使用

detach()阻断梯度。 - 代码调试:使用工具(如PyTorch的

autograd.gradcheck)验证梯度计算正确性。 - 优化内存管理:及时删除临时变量,使用

with torch.no_grad()包裹推理代码。

- 检查计算图:确保所有参数均参与前向传播,避免使用

框架或环境问题

- 原因分析:

- 版本兼容性:框架升级后API变更导致代码不可用。

- CUDA配置错误:多卡训练时未正确设置

CUDA_VISIBLE_DEVICES或NCCL参数。

- 解决方法:

- 固定框架版本:记录依赖版本(如

torch==1.10.0+cu113),避免随意升级。 - 多卡调试:检查NCCL通信库配置,确保多卡同步正常。

- 固定框架版本:记录依赖版本(如

常见问题FAQs

Q1:训练时显存突然溢出,如何快速定位原因?

- 解答:

- 检查模型复杂度:逐步减少网络层数或降低输入分辨率,观察显存变化。

- 监控显存占用:使用

nvidia-smi实时查看GPU内存使用情况,定位溢出阶段。 - 启用混合精度:通过FP16训练降低显存消耗,排除硬件限制问题。

Q2:梯度消失导致模型“假死”(损失不下降),如何解决?

- 解答:

- 初始化权重:改用He/Xavier初始化方法,避免初始梯度过小。

- 添加归一化层:在网络中插入BatchNorm或LayerNorm稳定梯度传播。

- 使用ReLU6/LeakyReLU:替代标准ReLU,缓解神经元“死亡”问题。